「自社の機密情報をクラウドに上げずにLLMを活用したい」

「APIの利用コストを気にせず、自由にAIを試したい」とお考えではありませんか。セキュリティポリシーやコストの観点から、クラウドベースのAIサービス導入に踏み切れない企業は少なくありません。その解決策となるのが、自社サーバーやPC上で大規模言語モデル(LLM)を動作させる

「ローカルLLM」です。ローカルLLMを構築すれば、外部にデータを送信することなく、セキュアな環境でAIの恩恵を最大限に引き出せます。この記事では、ローカルLLMの基礎知識から、2026年最新のおすすめツール、具体的な構築手順、そしてビジネスでの活用方法までを網羅的に解説します。読み終える頃には、自社でLLM環境を構築し、AI活用の第一歩を踏み出すための具体的な道筋が見えているはずです。AI導入の専門的な進め方や社内研修のノウハウをまとめた資料もご用意しておりますので、ぜひご活用ください。

ローカルLLMとは?クラウドとの違いを解説

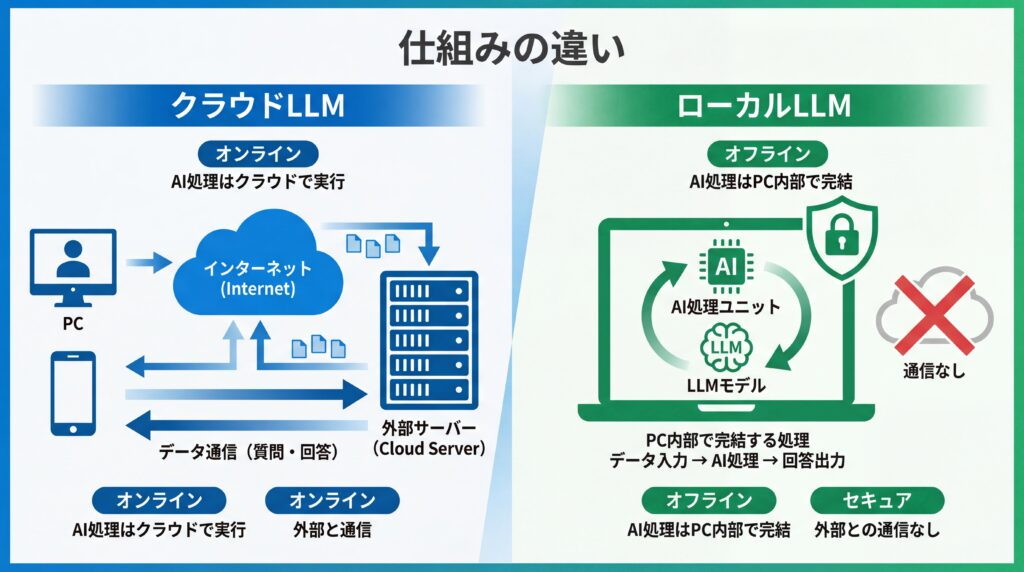

結論として、ローカルLLMとは自社で管理するコンピューターやサーバー上に直接インストールして使用する大規模言語モデルを指します。インターネット経由で利用するGPTシリーズなどとは異なり、適切に設定すればローカル環境で処理を完結させられることが最大の利点と言えるでしょう。

多くのツールはモデルのダウンロードやアップデートのために初期設定時にインターネット接続を要しますが、その後の運用は外部との通信を遮断して行えます。ただし、LM StudioやJanといったツールのドキュメントにもあるように、使用するクライアントアプリやプラグイン、デフォルトのテレメトリ設定によっては意図せず外部通信が発生する場合があるため、導入時の設定確認が重要です。 この仕組みにより、機密情報や個人情報を取り扱う業務でも情報漏洩のリスクを低減し、AIを活用できるのです。クラウドLLMが「サービスを借りる」感覚なら、ローカルLLMは「AIエンジンそのものを所有する」イメージに近いでしょう。

ローカルLLMの基本的な仕組み

ローカルLLMは、PCやサーバーに搭載されたGPU(Graphics Processing Unit)やCPUの計算能力を利用して稼働します。モデル本体のデータと、それを動かすためのプログラムを自社のマシンに保存し、ユーザーからの入力(プロンプト)に対して、そのマシン内で直接応答を生成する仕組みです。

処理の全てがローカル環境で完結するため、モデルのダウンロード時などを除けばインターネット接続が不要になります。この自己完結型のアーキテクチャが、高いセキュリティと高速な応答性能を実現する基盤となっています。

クラウドLLMとの比較(メリット・デメリット)

ローカルLLMとクラウドLLMは、それぞれに利点と欠点があります。どちらを選択すべきかは、利用目的やセキュリティ要件、予算によって大きく異なります。以下の表で、それぞれの特徴を比較してみましょう。

| 比較項目 | ローカルLLM | クラウドLLM |

|---|---|---|

| セキュリティ | 非常に高い(設定次第でオフライン可) | サービス提供者に依存 |

| カスタマイズ性 | 非常に高い(モデル改変可) | 限定的(API経由のみ) |

| コスト | 初期投資(ハードウェア)が必要 | 従量課金(API利用料) |

| 処理速度 | 高速(ネットワーク遅延なし) | ネットワーク環境に依存 |

| 導入・運用 | 専門知識が必要 | 比較的容易 |

| モデル性能 | オープンソースモデルに依存 | 常に最新・最高性能を利用可 |

セキュリティとカスタマイズ性を最優先するならローカルLLM、手軽に最高性能のモデルを利用したい場合はクラウドLLMが適していると言えるでしょう。自社の状況に合わせて最適な選択をすることが重要です。

ローカルLLMが注目される背景【2026年最新動向】

2025年現在、ローカルLLMへの注目が急速に高まっています。その背景には、いくつかの重要な技術的・社会的トレンドが存在します。

第一に、オープンソースLLMの劇的な性能向上が挙げられます。Meta社の「Llama 3」シリーズやMistral AI社のモデルなど、クラウドの商用モデルに匹敵する性能を持つモデルが次々と公開され、ライセンスの範囲内で誰でも利用できるようになりました。

第二に、企業のセキュリティ意識の高まりです。AI活用における情報漏洩リスクへの懸念から、データを外部に出さないオンプレミス(自社運用)環境への関心が高まっています。最後に、高性能なGPUが以前より入手しやすくなったことも、個人や中小企業がローカルLLMを導入するハードルを下げている要因です。

ローカルLLMを構築する主なメリット

ローカルLLMを自社で構築することには、クラウドサービスにはない数多くのメリットが存在します。特に「セキュリティ」「カスタマイズ性」「コスト・速度」の3点は、企業がローカルLLMを選択する上で大きな動機となります。

これらの利点を理解することで、自社の課題解決にローカルLLMがどのように貢献できるか、より具体的にイメージできるでしょう。

1. 高度なセキュリティとオフライン利用

ローカルLLMの大きなメリットは、適切に設定すれば機密情報を外部サーバーに送信せずにAI処理を完結できる点です。これにより、個人情報や研究開発データ、顧客情報といった社外秘の情報を扱う際の情報漏洩リスクを根本から排除できます。

ただし、ローカルで運用する場合でも、個人情報保護法などの関連法令や社内のセキュリティ規程を遵守する必要があります。アクセス権の管理、データの暗호化、操作ログの記録といった基本的なセキュリティ対策は、クラウド利用時と同様に徹底しなければなりません。また、インターネット接続が不安定な環境や、セキュリティポリシーで外部接続が制限されている閉域網内でも問題なく利用可能です。

2. 自由なモデルのカスタマイズ

オープンソースのLLMをベースにすることで、自社の特定の業務や目的に合わせてモデルを自由にカスタマイズできます。例えば、社内用語や専門知識を学習させる「ファインチューニング」を行うことで、業界特有の問い合わせに高精度で回答するチャットボットを開発できます。

さらに、社内ドキュメントやデータベースと連携させる「RAG(Retrieval-Augmented Generation)」という技術を組み合わせれば、最新の社内規定に基づいた回答を生成させることも可能です。このような深いレベルでのカスタマイズは、API経由での利用が基本となるクラウドLLMでは難しい点です。

3. コスト削減と高速処理

クラウドLLMのAPIは、利用量に応じて課金される従量課金制が一般的です。大量のデータを処理する場合、API利用料が想定以上に高額になるケースも少なくありません。ローカルLLMであれば、一度ハードウェアへの初期投資を行えば、どれだけ利用しても追加のAPI料金は発生しません。

加えて、ローカル環境ではインターネットを介さないため、ネットワークの遅延が応答速度に影響することもありません。ユーザーからのリクエストに対して瞬時に応答を返すことが可能となり、ユーザー体験の向上や業務の効率化に直結します。

ローカルLLM構築に必要なPCスペックと環境

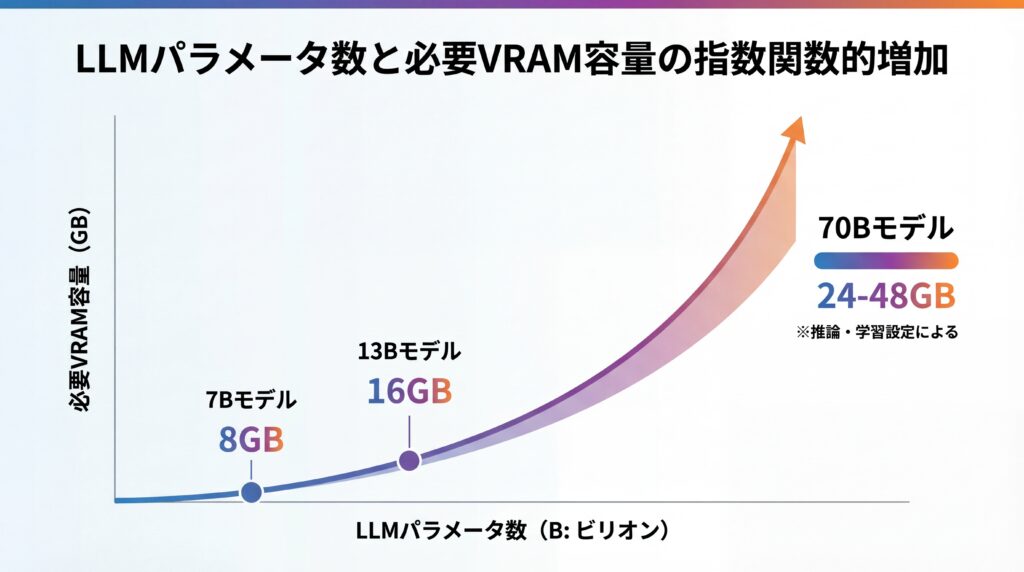

ローカルLLMを快適に動作させるためには、ある程度の性能を持つPCスペックが求められます。ITmediaの記事でも指摘されているように、最も重要な要素は動かしたいLLMの「モデルサイズ(パラメータ数)」であり、これによって必要なGPUのVRAM(ビデオメモリ)とメインメモリ(RAM)の容量が大きく変わります。

基本的には、モデルのサイズが大きくなるほど、より多くのVRAMとRAMが必要になると覚えておきましょう。ここでは、モデルサイズ別に推奨されるハードウェアスペックの目安と、OSごとの環境準備について解説します。

モデルサイズ別に見る推奨ハードウェア(GPU/CPU/RAM)

LLMを動かす上で最も重要なパーツはGPUです。特にNVIDIA社のGeForce RTXシリーズなどが一般的に利用されます。CPUやRAMも重要ですが、まずはVRAM容量を基準に考えるのが良いでしょう。

| モデルサイズ(パラメータ数) | 推奨VRAM | 推奨RAM | 代表的なモデル例 |

|---|---|---|---|

| 軽量〜中量級(〜8B) | 8GB以上 | 16GB以上 | Llama 3 8B, Mistral 7B, Gemma 7B |

| 中規模モデル(9B〜34B) | 16GB以上 | 32GB以上 | Gemma 2 9B, Phi-3 Medium, Llama 3 13B |

| 高性能モデル(70Bクラス) | 24GB〜48GB以上 | 64GB以上 | Llama 3 70B, Command R+ (※) |

70Bクラスの高性能モデルは、実装方法によって必要VRAMが大きく変動します。フル精度(FP16)での実行には40GB以上のVRAMが必要な場合もありますが、量子化(INT8/INT4)やCPUオフロードといった技術を用いれば24GB程度でも動作する場合があります。 ※Command R+は商用クラウドAPIでの提供が主であり、ローカルでの利用は一般的ではありません。

OSごとの環境準備

ローカルLLMの構築は、Windows、macOS、LinuxのいずれのOSでも可能です。ただし、OSによって準備の手順が若干異なります。

- Windows:WSL2(Windows Subsystem for Linux 2)を導入してLinux環境を構築するのが最もスムーズです。

- macOS:Appleシリコン(M1/M2/M3チップ)の性能が高く、特別な準備なしで多くのツールが動作します。

- Linux:特にUbuntuは開発環境として最も情報が多く、トラブルシューティングも行いやすいでしょう。

いずれのOSでも、PythonやGitといった基本的な開発ツールのインストールは事前に済ませておくと効率的に作業を進められます。

【2026年版】ローカルLLM構築におすすめのツール3選

かつては専門的な知識が不可欠だったローカルLLMの構築ですが、現在では便利なツールが登場し、初心者でも手軽に始められるようになりました。ここでは、2026年時点でおすすめの代表的なツールを3つ紹介します。(出典:【2026年最新】LLM実行ツールおすすめ5選!ローカル・クラウド別に紹介)

これらのツールは、モデルのダウンロードから実行、管理までを簡単に行えるように設計されており、目的やスキルレベルに応じて選ぶことができます。

1. Ollama:手軽なセットアップとCLI操作

Ollamaは、コマンドライン(CLI)での操作を基本とする、非常にシンプルで軽量なツールです。簡単なコマンドを一つ実行するだけで、モデルのダウンロードから実行までが完了する手軽さが最大の魅力と言えます。

開発者にとっては、APIサーバーを簡単に起動できる点も大きなメリットです。自作のアプリケーションにLLMを組み込みたい場合に非常に便利で、ローカルAI開発のデファクトスタンダード的なツールとなりつつあります。

2. LM Studio:GUIで直感的にモデルを管理

LM Studioは、グラフィカルなインターフェース(GUI)で直感的に操作できるデスクトップアプリケーションです。プログラミングの知識がなくても、マウス操作だけでモデルの検索、ダウンロード、チャットが完結します。

Hugging FaceというAIモデルの巨大なプラットフォームから、様々なオープンソースモデルを簡単に探して試せるのが特徴です。非エンジニアの方や、まずは色々なモデルを試してみたいという方に最適です。

3. Jan:オープンソースでプライバシー重視の選択肢

Janは、LM Studioと同様にGUIベースのツールですが、ソフトウェア自体がオープンソースで開発されている点が大きな特徴です。プライバシーを最優先に設計されており、全てのデータがローカルに保存され、ユーザーが許可しない外部への通信は行われません。

インターフェースも洗練されており、チャットの履歴管理や各種設定も分かりやすくまとまっています。完全にクローズドな環境で、安心してLLMを利用したい場合に有力な選択肢となります。

https://media.a-x.inc/llm-tools

目的に合わせて選ぶ!代表的なオープンソースLLMモデル

ローカル環境でLLMを動かす上で、どの「モデル」を選ぶかは非常に重要です。モデルによって性能、得意なタスク、動作に必要なPCスペックが大きく異なるため、目的や環境に合わせて最適なものを選択する必要があります。

基本的には「性能の高さ」と「特定の用途への特化度」という2つの軸で考えると、モデルを選びやすくなります。ここでは、代表的なオープンソースLLMをそれぞれの観点から紹介します。

性能で選ぶ:軽量・高速モデルと高性能モデル

まずは、汎用的な性能のバランスで選ぶ方法です。一般的なPCでも動作させやすい軽量モデルと、高性能なGPUを要求する代わりに非常に高い能力を持つモデルに大別されます。

- 軽量・高速モデル:Meta社の「Llama 3 8B」やGoogleの「Gemma 7B」、Mistral AIの「Mistral 7B」が代表格です。これらはVRAM 8GB程度のGPUでも動作し、日常的なタスクであれば十分な性能を発揮します。

- 高性能モデル:より複雑な推論や専門的な文章作成を求めるなら、「Llama 3 70B」のようなモデルが選択肢です。ただし、量子化を行っても24GB以上のVRAMが推奨されるなど、相応のハードウェア環境が必要となります。

まずは軽量モデルからスタートし、自社の用途で性能が不足する場合に高性能モデルの導入を検討するのが良いでしょう。

https://media.a-x.inc/llm-open-source

用途で選ぶ:日本語特化モデル

グローバルで開発されたモデルは英語性能が高い一方、日本語の細かなニュアンスや文化的な背景を苦手とすることがあります。そのため、日本語での利用がメインの場合は、日本語データで追加学習されたモデルを選ぶのが効果的です。

例えば、日本のELYZA社が開発した「ELYZA-japanese-Llama-2-7b」や、rinna社が公開している「rinna/nekomata-7b」などが有名です。これらのモデルは、日本語の文章生成や要約、対話において、海外製の汎用モデルよりも自然で高品質な結果を示すことがあります。

初心者でも簡単!Ollamaを使ったローカルLLM構築の2ステップ

ここでは、数あるツールの中でも特に手軽で人気のある「Ollama」を使い、実際にローカルLLM環境を構築する手順を解説します。専門的な知識はほとんど不要で、コマンドを数回入力するだけで、すぐにAIとの対話を始められます。

この手順通りに進めれば、誰でも簡単に自分だけのAIチャット環境を手に入れることが可能です。まずは軽量なモデルから試してみましょう。

ステップ1:インストールからモデル実行まで

最初のステップは、Ollama本体のインストールと、動かしたいLLMモデルのダウンロードです。以下の手順で進めます。

- Ollama公式サイトにアクセスし、お使いのOS(Windows, macOS, Linux)用のインストーラーをダウンロードします。

- ダウンロードしたファイルを実行し、画面の指示に従ってインストールを完了させます。

- ターミナル(WindowsではコマンドプロンプトまたはPowerShell)を開き、以下のコマンドを入力して実行します。

ollama run llama3

このコマンド一つで、Meta社の最新モデル「Llama 3」のダウンロードと実行が自動的に開始されます。初回はダウンロードに時間がかかりますが、完了するとプロンプトが表示され、すぐに対話を開始できます。

ステップ2:基本的な対話とAPI連携

モデルの実行が完了すると、ターミナル上で直接メッセージを入力してAIと対話できます。例えば、「日本の首都はどこですか?」と入力してEnterキーを押せば、AIからの回答が表示されます。

さらに、Ollamaはローカル環境にAPIサーバーを自動で立ち上げてくれます。別のターミナルを開き、以下のコマンドを実行することで、プログラムからLLMを呼び出すことも可能です。これにより、自作のアプリケーションやスクリプトにAI機能を簡単に組み込めます。

curl -X POST "http://localhost:11434/api/generate" -H "Content-Type: application/json" -d '{"model":"llama3","prompt":"Why is the sky blue?","stream":false}'

ローカルLLMの構築後の発展的な活用方法

ローカルLLMの真価は、単にチャット機能を利用するだけにとどまりません。構築したLLMを基盤として、様々なツールやデータと連携させることで、より高度で実用的なアプリケーションを開発できます。これにより、定型業務の自動化や、社内ナレッジの有効活用が飛躍的に進みます。

ここでは、代表的な発展的活用方法として「RAG連携」と「コーディング支援」の2つを紹介します。これらは多くの企業で導入効果が期待できる応用例です。

1. RAG連携とオリジナルAIチャットボット開発

RAG(Retrieval-Augmented Generation)は、LLMに外部の知識データベースを参照させる技術です。ローカルLLMと社内ドキュメント(マニュアル、議事録、社内規定など)を連携させることで、「社内ドキュメント検索に強く、業務支援を効率化できる」オリジナルのAIチャットボットを開発できます。

しかし、LLMは事実と異なる情報を生成する可能性があるため、生成された回答は必ず人間が確認し、最終的な判断を下すべきです。回答の根拠となったドキュメントを提示させるなど、検証プロセスや人間の監督、ログ管理といったガバナンスを組み込むことが極めて重要になります。

実際に、AI活用によって業務のあり方を大きく変革した企業も存在します。美容健康食品を扱うエムスタイルジャパン様では、コールセンターの履歴確認や広告レポート作成といった手作業をAIで自動化。その結果、コールセンターの確認業務にかかっていた月16時間がほぼゼロになるなど、全社で月100時間以上の業務削減を達成しました。(出典:月100時間以上の”ムダ業務”をカット!エムスタイルジャパン社が築いた「AIは当たり前文化」の軌跡)

2. コーディング支援やドキュメント生成の自動化

ローカルLLMは、ソフトウェア開発の現場でも強力なアシスタントとなります。VS Codeなどのエディタと連携させることで、オフライン環境でコードの自動補完や生成、リファクタリング、バグの発見などを行わせることができます。

これにより、開発者はコーディング作業そのものから解放され、より創造的な設計や要件定義に集中できます。また、書いたコードから仕様書やドキュメントを自動生成させることも可能で、開発プロセス全体の効率化に貢献します。

AIによる業務の代替は、開発職に限りません。例えば、SNS広告を手掛けるWISDOM合同会社様は、人材採用のコストと業務負荷に課題を抱えていました。しかし、AI活用を推進した結果、採用予定だった2名分の業務をAIが完全に代替し、事業成長を加速させることに成功しています。(出典:AX CAMP受講企業の成果事例)このように、AIは単なる効率化ツールではなく、企業の成長をドライブするエンジンにもなり得るのです。

ローカルLLM構築・運用時の注意点

ローカルLLMは多くのメリットをもたらす一方で、導入と運用にあたってはいくつかの注意点が存在します。特に、法的な側面である「ライセンス」と、技術的・コスト的な側面である「運用管理」は、事前にしっかりと理解しておく必要があります。

これらのポイントを見過ごすと、後々法的なトラブルに発展したり、想定外のコストが発生したりする可能性があるため、計画段階で必ず確認しましょう。

1. モデルのライセンスと商用利用

オープンソースとして公開されているLLMは、誰でも自由に利用できるわけではありません。各モデルには「ライセンス(利用許諾契約)」が定められており、その内容を遵守する必要があります。特に注意が必要なのが商用利用の可否や条件であり、モデルごとにライセンスが異なります。

例えば、Meta社のLlama 3は「Llama 3 Community License」という独自のライセンスを採用しており、月間アクティブユーザーが7億人を超えるような大規模サービスでの利用には制限が設けられています。このようにライセンスは複雑で変更される可能性もあるため、商用利用前には必ず法務部門やライセンスの専門家による確認を行うことが不可欠です。(出典:生成AIの著作権と商用利用のリスク|注意点と対策を解説)

2. 運用コストとセキュリティ管理

ローカルLLMはAPI利用料がかからない代わりに、サーバーの購入費用や維持管理コストが発生します。高性能なGPUを搭載したサーバーは高価であり、24時間稼働させる場合は電気代も無視できません。これらのランニングコストを含めたトータルコストを、クラウドサービスの利用料と比較検討することが重要です。

また、セキュリティに関しても自己責任となります。OSや利用するソフトウェアライブラリに脆弱性が発見された場合、自社で迅速にアップデート対応を行う必要があります。モデルデータや関連プログラムの適切なアクセス管理など、クラウドサービスであれば提供者側が行ってくれるセキュリティ対策を、自社で責任を持って実施しなければなりません。

専門知識不要でAI活用を推進するならAX CAMP

ここまで、ローカルLLMの構築方法や活用法について解説してきましたが、実践するにはある程度の専門知識や技術スキルが必要になるのも事実です。「何から手をつければいいかわからない」「自社の業務にどう活かせるかイメージが湧かない」と感じる方も少なくないでしょう。

もし、より手軽に、かつ着実にAI導入の成果を出したいとお考えなら、当社の法人向けAI研修・伴走支援サービス「AX CAMP」が力になります。AX CAMPは、単なるツールの使い方を学ぶ場ではありません。貴社の具体的な業務課題をヒアリングし、AIで成果を出すための最短ルートを一緒に考え、実現までサポートします。

プログラミングの知識がない方でも、ノーコードツールや実践的なプロンプトエンジニアリングを学ぶことで、現場の業務を次々と自動化していくことが可能です。これまで多くの企業様が、属人化していた業務の標準化や、手作業による長時間労働の削減を実現してきました。

「AI担当者を育成したい」「全社的なAIリテラシーを向上させたい」「まずは情報収集から始めたい」など、どのような段階でも構いません。貴社の状況に合わせた最適なプランをご提案しますので、まずは無料の資料請求やオンライン相談をご活用ください。

まとめ:LLMをローカルに構築し、セキュアなAI活用を実現しよう

本記事では、ローカルLLMの構築をテーマに、その基礎知識からメリット、必要な環境、おすすめのツール、具体的な構築手順、そして発展的な活用法までを網羅的に解説しました。

この記事の要点をまとめます。

- ローカルLLMとは:自社サーバー等で動作させるLLMで、適切な設定によりオフライン利用が可能。

- 主なメリット:高いセキュリティと自由なカスタマイズ性、コスト管理のしやすさ。

- 構築のポイント:動かしたいモデルサイズに合ったPCスペック(特にVRAM)の選定。

- おすすめツール:初心者でもOllamaやLM Studioで手軽に開始できる。

- 注意点:モデルのライセンス確認と、ハードウェア・運用管理コストの把握が不可欠。

ローカルLLMを正しく導入・活用すれば、クラウドサービスでは難しかったセキュアかつ柔軟なAI活用が実現します。特に、機密情報を扱う企業や、独自のAIアプリケーション開発を目指す企業にとって、その価値は計り知れません。

もし、自社だけでAI導入を進めることに不安を感じる場合や、より専門的な支援を受けながら最短で成果を出したい場合は、ぜひ「AX CAMP」にご相談ください。貴社の課題に寄り添い、AIを真のビジネス変革ツールとするための実践的なノウハウとサポートを提供します。