大規模言語モデル(LLM)の急速な進化は、ビジネスのあり方を大きく変えようとしています。しかし、その一方で

「LLMには限界がある」

「AI開発は停滞するのではないか」といった声も聞かれるようになりました。万能に見えるLLMですが、実用化を進める上では無視できない課題が存在するのも事実です。

この記事では、2026年現在の最新情報に基づき、LLMが直面している7つの技術的限界と社会的・倫理的な課題を詳しく解説します。さらに、その根本的な原因や、限界を突破するための次世代技術、ビジネスで賢く活用するための具体的な方法までを網羅的にご紹介します。

本記事を最後まで読めば、LLMの限界を正しく理解し、リスクを回避しながらその恩恵を最大限に引き出すための実践的な知識が身につきます。自社でのAI活用を成功させるための具体的なヒントが満載ですので、ぜひご一読ください。LLMの限界を踏まえた上で、自社に最適なAI研修や導入支援にご興味のある方は、AX CAMPが提供するサービス資料も併せてご覧ください。

記事:【AI導入しないことが経営リスクになる時代】先行企業が手にした圧倒的な競争優位とは?

そもそもLLMとは?限界を語る前に知っておきたい基礎とメリット

最近、ビジネスや日常生活で頻繁に耳にする「LLM」。これは「Large Language Models」の略で、日本語では大規模言語モデルと訳されます。そもそもLLMとは、インターネット上の膨大なテキストデータを学習することで、人間のように自然な文章を生成したり理解したりできるAIのことです。代表的な例としては、OpenAI社のChatGPTやGoogle社のGeminiなどが挙げられます。

LLMが持つ能力は多岐にわたり、私たちの仕事や創造性を大きく後押しするメリットがあります。具体的には、以下のようなタスクを得意とします。

- 文章作成・要約: メール文やブログ記事の作成、長文ドキュメントの要約

- 翻訳・質疑応答: 高精度な多言語間の翻訳や、専門的な質問への回答

- アイデア創出: ブレーンストーミングの壁打ち相手や新しい視点の提供

- コード生成: プログラミングコードの自動生成やデバッグ支援

これらの能力は、業務効率化や新たなアイデア創出に直結する強力なツールです。しかし、その万能に見える能力にも限界は存在します。本記事でその「LLMの限界」を深く探る前に、まずはその基礎とメリットを正しく理解しておくことが重要です。

なぜ今「LLMの限界」が注目されるのか?

現在、「LLMの限界」が注目を集める背景には、AIの能力向上がこれまでと同じペースでは続かない可能性を示唆する2つの大きな要因があります。それは、モデルの性能向上ペースが鈍化し始める「スケール則の限界」と、学習に不可欠な「高品質データの枯渇」という問題です。

これまでLLMは、パラメータ数とデータ量を増やすことで性能を高める「スケール則(Scaling Law)」に従って進化を遂げてきました。しかし、モデルが巨大化するにつれて性能の伸び率が飽和し始め、同時にインターネット上の高品質なテキストデータも消費し尽くされつつあります。これが、今後の性能向上を阻む大きな壁として立ちはだかっているのです。

スケール則の限界とデータ枯渇問題

スケール則とは、LLMの性能がモデルのサイズ(パラメータ数)、データセットのサイズ、そして計算リソースという3要素によって予測可能であるという経験則です。OpenAIなどの研究機関は、この法則を道しるべにGPTシリーズなどを開発し、驚異的な性能向上を実現してきました。

しかし、この成長には物理的な限界が近づいています。モデルのサイズを2倍にしても、性能が2倍になるわけではなく、その向上率は徐々に低下します。さらに、学習に必要な計算コストと消費電力は爆発的に増加し続けており、持続可能性の観点からも問題視されています。加えて、2026年頃には高品質な言語データが枯渇するという予測もあり、データ量の増加による性能向上が見込めなくなる可能性が指摘されています。(出典:NRI未来創発)

高度化する社会の要求と次世代モデル開発の難航

ビジネスや社会がAIに求める要求は、単なる文章生成や要約といったタスクを超え、より高度で複雑なものへと変化しています。具体的には、物理世界と対話するロボットの制御や、複数の専門知識を組み合わせた複雑な問題解決、あるいは創造的なアイデアの立案などです。

現在のLLMは、テキストデータから次に来る単語を予測するという基本的な仕組みで動いているため、こうした高度な要求に応えるには構造的な限界があります。現実世界の物理法則や因果関係を真に理解しているわけではないため、論理的な推論や計画立案が苦手です。このギャップを埋める次世代モデルの開発は、世界中の研究機関が取り組んでいますが、その道のりは決して平坦ではありません。

LLMが直面する7つの技術的限界

LLMは多くのタスクで人間を凌駕する性能を見せる一方で、その能力には明確な技術的限界が存在します。ビジネスで活用する際には、これらの限界を正しく認識し、適切な対策を講じることが不可欠です。ここでは、LLMが直面している主要な7つの技術的限界を3つのカテゴリーに分けて解説します。

具体的には、「精度と信頼性」「知識とデータ」「構造とコスト」の3つの側面から、LLMが抱える課題を明らかにしていきます。これらの課題を理解することで、AIに任せるべきタスクと人間が判断すべきタスクを的確に見極められるようになります。

1. 精度と信頼性の限界(ハルシネーション・論理的推論)

LLMの最も有名な限界の一つが、ハルシネーション(Hallucination)です。これは、AIが事実に基づかない情報を、あたかも真実であるかのように堂々と生成する現象を指します。学習データに存在しない情報や、誤った関連性を学習した結果として発生し、特に情報の正確性が求められる業務で大きなリスクとなります。(出典:AIのハルシネーション(幻覚)とは?その原因や危険性、対策を解説)

また、LLMは複雑な数学的計算や多段階の論理的推論が苦手です。一見すると正しいように見える回答でも、途中の計算や論理展開に誤りを含んでいることが少なくありません。これは、LLMが言語のパターンを学習しているだけで、真の意味で論理を理解しているわけではないことに起因します。

2. 知識とデータの限界(リアルタイム性・コンテキスト長)

LLMの知識は、学習に使われたデータセットが作成された時点で固定されています。そのため、モデル単体では学習データに含まれていない最新の出来事やリアルタイムの情報に関する質問には正確に答えられません。この問題を緩和するため、検索拡張生成(RAG)や外部APIとの連携といった技術が開発されており、最新情報に基づいた応答が可能になりつつありますが、完全なリアルタイム性の実現にはまだ課題があります。

さらに、LLMが一度に処理できる情報の量には「コンテキスト長」という上限があります。これは、モデルが対話の文脈を記憶できる長さを示しており、この上限を超えると古い情報から忘れていってしまいます。長文のドキュメントを要約したり、長時間の会議の議事録を作成したりする際に、情報の一部が欠落する原因となります。

3. 構造とコストの限界(計算リソース・身体性の欠如)

GPT-5やGemini 2.5 Proといった最先端のLLMを開発・運用するには、莫大な計算リソースと電力が必要です。スーパーコンピュータ級の設備を数ヶ月間稼働させる必要があり、そのコストは数百億円に達することもあります。(出典:LLMのコスト構造とビジネスインパクト)このコストの高さが、AI開発への参入障壁となり、一部の巨大テック企業による寡占状態を生む一因となっています。

もう一つの構造的な限界は「身体性の欠如」です。LLMはテキストデータのみを学習しているため、現実世界の物理的な感覚や常識を持ち合わせていません。「ドアを押す」と「ドアを引く」の違いを、テキスト上の知識としては知っていても、実際の身体的な経験として理解しているわけではないのです。このため、物理的な操作を伴うロボットの制御など、現実世界とのインタラクションが求められる分野での活用には大きな課題が残されています。

技術だけではない社会的・倫理的な限界

LLMの限界は、技術的な側面に留まりません。AIが社会に広く浸透するにつれて、その基盤となる学習データに起因する「バイアス」の問題や、生成物が引き起こす「著作権・プライバシー侵害」のリスクなど、社会的・倫理的な課題が深刻化しています。

これらの問題は、単にモデルの精度を上げるだけでは解決できず、法整備や社会的なルール作りを含めた多角的なアプローチが求められます。企業がLLMを導入する際には、これらのリスクを十分に理解し、適切なガバナンス体制を構築することが不可欠です。

学習データに起因するバイアスと公平性の問題

LLMは、インターネット上などに存在する膨大なテキストデータを学習して構築されます。この学習データには、人間の社会が持つ様々な偏見やステレオタイプ(バイアス)が含まれており、AIはそれを無批判に学習してしまいます。その結果、特定の性別、人種、国籍、職業などに対する差別的・偏見に満ちたコンテンツを生成してしまう可能性があります。

例えば、過去のデータから「医者は男性、看護師は女性」といった固定観念を学習し、そのステレオタイプを助長するような文章を生成することがあります。このようなバイアスは、採用活動や人事評価などの重要な意思決定にAIを利用した場合、不公平な結果を招く危険性があり、企業の信頼を著しく損なうリスクをはらんでいます。

著作権やプライバシー侵害のリスク

LLMの学習データには、著作権で保護された記事、書籍、画像などが含まれている可能性があります。AIがこれらのデータを学習し、酷似したコンテンツを生成した場合、著作権侵害にあたるのではないかという議論が世界中で巻き起こっています。現時点では法的な判断基準が確立されておらず、企業がビジネスで生成AIを利用する上で大きな不確実性となっています。

また、プライバシー侵害のリスクも見過ごせません。学習データに個人のブログやSNS投稿などが含まれていた場合、AIがその情報を記憶し、プロンプトに応じて個人の氏名や連絡先といった個人情報を意図せず出力してしまう可能性があります。そのため、サービス提供者側には、顧客データを学習に利用しない方針を明示したり、ログの保存期間を定めたりするなど、厳格なデータガバナンス体制が求められます。

LLMの限界を生む根本的な原因

これまで見てきたLLMの様々な限界は、単なる個別の問題ではなく、その根底にある技術的な仕組みに起因しています。現在のLLMの主流である「自己回帰モデル(Autoregressive Model)」の構造的な課題と、学習方法がテキストデータのみに依存しているという2点が、その根本的な原因として挙げられます。

これらの根本原因を理解することは、LLMの能力を過信せず、その弱点を補うような使い方を見出す上で非常に重要です。なぜLLMが論理的な間違いを犯したり、常識外れな回答をしたりするのか、その本質に迫ります。

自己回帰モデルの構造的課題

自己回帰モデルとは、一言で言えば「次に来る単語を予測する」処理を延々と繰り返す仕組みです。例えば、「今日の天気は」という入力があれば、次に最も来そうな「晴れ」という単語を予測し、次に「晴れです」の次に最も来そうな単語を予測する、という形で文章を生成していきます。

この仕組みは、流暢で人間らしい文章を生成する上で非常に効果的ですが、長期的な計画性や論理的な一貫性を保つことには構造的な挑戦が伴います。自己回帰的な生成は、時に文章全体での矛盾や、複雑な指示の意図の取りこぼしに繋がることがあります。ただし、この課題に対しては、Chain-of-Thought(思考の連鎖)やRAG(検索拡張生成)といった技術で、ある程度の緩和が可能になってきています。

テキストデータのみに依存した学習方法

LLMのもう一つの根本的な限界は、その知識がテキスト、つまり「言葉の世界」だけで完結している点にあります。人間は、言葉だけでなく、五感を通じて現実世界に触れ、物事を体験的に学習します。熱いものに触れば火傷をすること、リンゴは木から落ちることを、身体を通して学びます。

一方で、LLMはこうした物理的な実世界での経験(身体性)を持ちません。そのため、言葉の上での関係性は理解できても、その背景にある因果関係や物理法則を真に理解しているわけではありません。この「経験の欠如」が、常識的な判断の誤りや、現実離れした回答(ハルシネーション)を生む根本的な原因の一つとなっています。

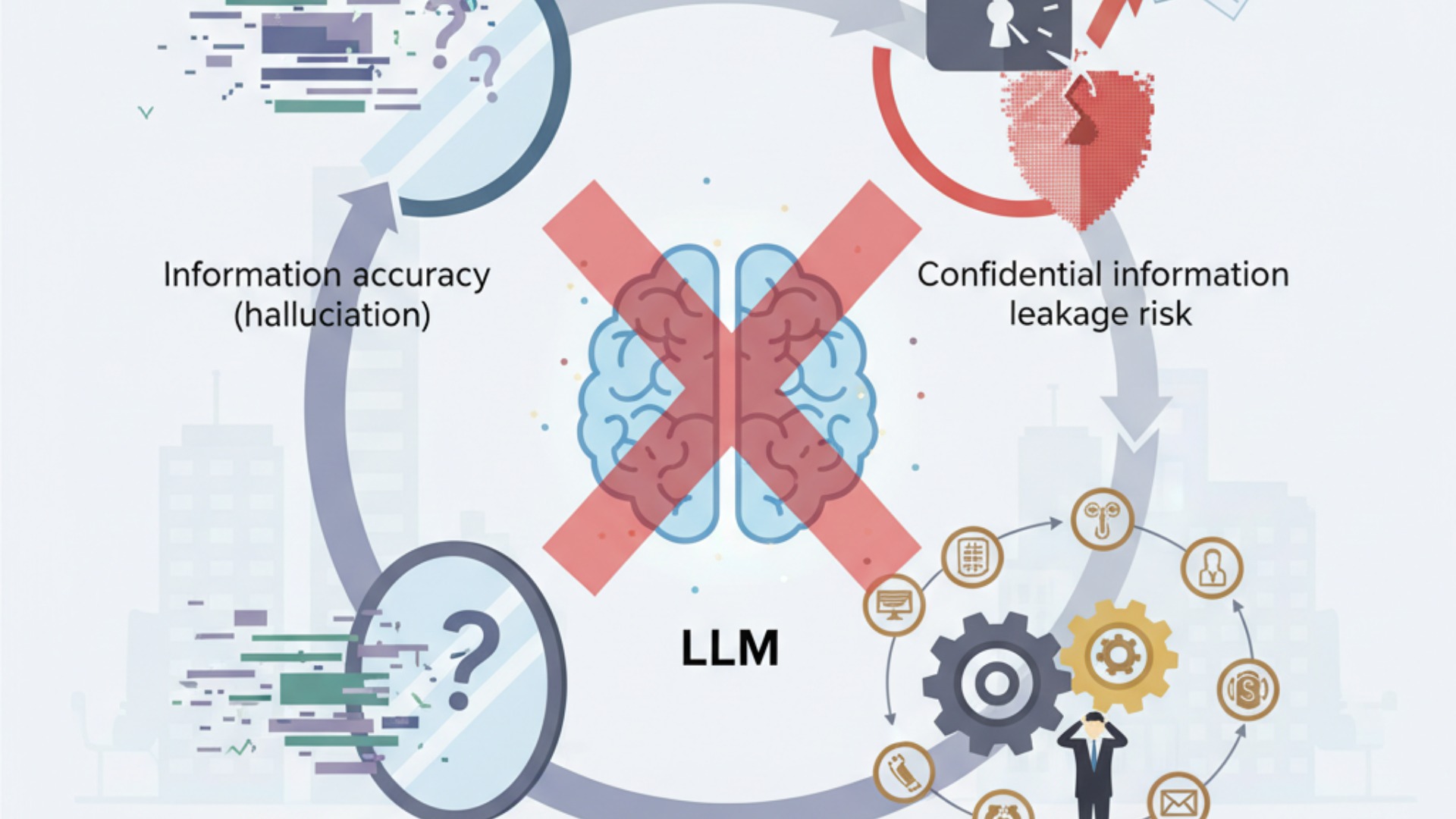

ビジネス活用におけるLLMの限界と注意点

LLMの技術的・倫理的な限界を理解することは、ビジネスでAIを安全かつ効果的に活用するための第一歩です。特に、情報の不正確さ(ハルシネーション)、機密情報の漏洩リスク、そして専門分野への対応力不足という3つの点には細心の注意を払う必要があります。

これらの限界を知らずに導入を進めると、顧客の信頼を失ったり、重大なセキュリティインシデントを引き起こしたりする可能性があります。しかし、限界を正しく認識し、適切な対策を講じれば、LLMは業務効率化の強力なツールとなり得ます。ここでは、具体的な企業事例を交えながら、ビジネス活用の注意点と成功のポイントを解説します。

C社様の事例:属人化解消とSNS運用効率化

SNSマーケティング事業を展開するC社様は、業務の属人化とインプレッション数の伸び悩みに課題を抱えていました。AX CAMPの導入を通じて、非エンジニアチームがAIによるSNS完全自動化システムを内製化。その結果、従来1日3時間以上かかっていた運用業務をわずか1時間に短縮し、66%もの工数削減に成功しました。これは、LLMの限界を理解し、定型的な業務の自動化に特化して活用した好例です。(出典:月間1,000万impを自動化!C社でAI活用が当たり前の文化になった背景とは?)

WISDOM合同会社様の事例:採用コストの課題をAIで解決

SNS広告やショート動画制作を手がけるWISDOM合同会社様は、事業拡大に伴う人材採用コストと業務負荷の増大が課題でした。AX CAMPの研修でAI活用スキルを習得し、業務自動化を推進した結果、採用予定だった2名分の業務負荷をAIが完全に代替することに成功。LLMをクリエイティブな業務のアシスタントとして活用しつつ、定型業務を自動化することで、採用コストを抑えながら生産性を向上させました。(出典:採用予定2名分の業務をAIが代替!WISDOM社、毎日2時間の調整業務を自動化)

エムスタイルジャパン様の事例:全社的な業務削減を実現

美容健康食品の製造販売を行うエムスタイルジャパン様では、コールセンターの履歴確認や手作業での広告レポート作成に多くの時間を費やしていました。AX CAMPでGAS(Google Apps Script)とAIを連携させる手法を学び、業務自動化を実践。その結果、コールセンターの確認業務(月16時間)がほぼゼロになるなど、全社で月100時間以上の業務削減を達成しました。特定の課題に対して、LLMを他のツールと組み合わせて適用することで、大きな成果を上げています。(出典:月100時間以上の”ムダ業務”をカット!エムスタイルジャパン社が築いた「AIは当たり前文化」の軌跡)

【2026年最新】LLMの限界を突破する次世代AI技術

現在のLLMが抱える限界を克服するため、世界中の研究機関や企業では次世代AI技術の開発が精力的に進められています。これらの新技術は、テキスト情報だけでなく、画像や音声、さらには物理世界の法則までを理解し、より人間に近い高度な知能を実現することを目指しています。「マルチモーダルAI」や「世界モデル」は、その代表格です。(出典:【2026年最新】AIの進化を加速させる次世代技術7選!注目の研究や今後の動向を解説)

これらの技術はまだ研究開発段階のものも多いですが、すでに一部は実用化が始まっており、今後のAIの進化の方向性を占う上で非常に重要です。ここでは、LLMの限界を突破する可能性を秘めた最先端の技術動向をご紹介します。

注目すべき技術の一つが、テキスト、画像、音声、動画など複数の異なる種類の情報(モダリティ)を統合的に扱うマルチモーダルAIです。Googleの「Gemini」シリーズやOpenAIの次世代モデル「GPT-5」などは、このマルチモーダル対応をさらに進化させており、画像や音声の内容を理解した上での対話や、より高度な情報処理を可能にしています。(出典:Introducing GPT-5)

さらに、AIが現実世界の仕組みや物理法則をシミュレーションし、未来の結果を予測する「世界モデル(World Model)」の研究も進んでいます。一部の企業が開発する最新の動画生成技術もその一つとされ、単に映像を生成するだけでなく、その背景にある物理的な一貫性を理解しようと試みています。これにより、AIがより常識的で、因果関係に基づいた推論を行えるようになると期待されています。

これらの次世代技術は、LLMが苦手としてきた身体性や論理的推論の限界を補い、AIの応用範囲をさらに広げる可能性を秘めています。(出典:マルチモーダルAIとは?LLMとの違いや活用事例、今後の展望を解説)

LLMの限界を踏まえた賢い活用法とプロンプト術

LLMに限界があるからといって、その価値が失われるわけではありません。むしろ、限界を正しく理解し、それを前提とした使い方をすることで、AIをより安全かつ効果的なビジネスパートナーにできます。その鍵となるのは、「AIの回答を鵜呑みにしない」「人間が最終責任を持つ」「AIの得意な領域で活用する」という3つの原則です。(出典:【プロンプトのコツ】生成AIの精度を高める10の基本とテンプレート)

これらの原則を実践に移すための具体的な方法として、ファクトチェックの徹底や、AIの役割を明確に指示するプロンプト術、そして人間とAIの適切な協業体制の構築が挙げられます。ここでは、明日からでも実践できる賢い活用法をご紹介します。

まず最も重要なのは、AIが生成した情報のファクトチェックを必ず行うことです。特に、数値データ、固有名詞、専門的な情報については、信頼できる情報源で裏付けを取るプロセスを業務フローに組み込む必要があります。AIはあくまで「優秀なアシスタント」であり、最終的な事実確認の責任は人間が負うという意識が不可欠です。(出典:生成AIのセキュリティリスクとは?具体的な7つの脅威と対策を解説)

次に、回答の精度を高めるプロンプト術も有効です。例えば、「あなたは経験豊富なマーケティングコンサルタントです。以下の情報に基づいて、30代女性向けのキャッチコピーを5つ提案してください」のように、AIに具体的な役割(ペルソナ)を与えることで、出力の質と方向性をコントロールしやすくなります。また、参照してほしい情報やデータがあれば、それをプロンプトに含めることで、ハルシネーションを抑制する効果も期待できます。

最終的には、AIを意思決定者としてではなく、情報収集、アイデア出し、文章のドラフト作成といった人間の思考を補助するツールとして位置づけることが賢明です。AIが出した複数の選択肢を基に、最終的な判断は人間の経験と洞察に基づいて行う。このような協業体制を築くことが、LLMの限界を補い、その能力を最大限に引き出すための現実的なアプローチと言えるでしょう。

LLMの限界を乗り越える実践的アプローチとプロンプト術

前述の基本的な心構えに加え、LLMの限界を技術的に乗り越えるための、より高度で実践的なアプローチとプロンプト術も登場しています。これらは単なる「使い方」の工夫にとどまらず、LLMをシステムに組み込む際の設計思想にも関わる重要な手法です。

- RAG(Retrieval-Augmented Generation): LLMが学習していない最新情報や、社内文書のようなクローズドなデータを外部データベースから検索(Retrieval)させ、その内容を根拠に回答を生成させる技術です。これにより、「2024年第3四半期の自社製品の売上データを基に分析して」といった、ハルシネーションを抑えた正確な指示が可能になります。

- 思考の連鎖(Chain-of-Thought)プロンプティング: 複雑な問いに対し、「ステップバイステップで考えてください」と指示を与えるプロンプト術です。結論だけを急がせるのではなく、思考のプロセスを言語化させることで、LLMは論理的な間違いに自ら気づきやすくなり、回答の精度が向上します。

- ツール連携による機能拡張: LLM単体では不可能なタスクを、外部ツールと連携させることで解決するアプローチです。例えば、最新の為替レートを計算させるためにWeb検索APIを呼び出させたり、Pythonコードを実行させたりすることで、LLMの応用範囲を現実世界へと大きく広げます。

これらのアプローチは、LLMの限界を悲観するのではなく、それを前提として外部のデータやツールで補うという発想に基づいています。こうした工夫を凝らすことで、LLMは単なる対話相手から、より信頼性の高い業務遂行パートナーへと進化するのです。

「AI開発は停滞する」は本当か?今後の展望

LLMの限界が明らかになるにつれ、「ムーアの法則の終焉」になぞらえてAI開発の停滞を懸念する声も聞かれます。しかし、結論から言えば、開発が完全に「停滞する」可能性は低いでしょう。正しくは、これまでのようなパラメータ数を増やすことによる性能向上が踊り場を迎え、AI開発のフェーズが「スケール(規模)」から「効率」や「質」へと転換する時期に来ていると捉えるべきです。

短期的には性能向上のペースが鈍化するように見えるかもしれませんが、水面下では次世代のアーキテクチャや、より効率的な学習方法の研究が活発に進められています。今後のAIは、一つの巨大なモデルが全てをこなすのではなく、多様なモデルが協調して動作する、より洗練された形へと進化していくと予測されます。

今後の展望として、3つの大きな方向性が考えられます。

- 特定タスク特化モデルの台頭:汎用的な巨大LLMだけでなく、医療、法律、製造業といった特定のドメイン知識に特化した、より小型で高効率なモデルの開発が進みます。これにより、各業界のニーズに即した、コストパフォーマンスの高いAIソリューションが普及するでしょう。

- エンボディードAI(Embodied AI)の進化:LLMがロボットなどの物理的な身体(ボディ)と結びつき、現実世界でタスクを実行する「エンボディードAI」の研究が加速します。これにより、AIの活用範囲はデジタル空間から、製造ラインや物流倉庫、家庭内といった物理空間へと大きく広がります。

- AIアライメント研究の重要性の高まり:AIの能力が向上するにつれて、その目標を人間の価値観や倫理観と一致させる「アライメント」技術の重要性が増します。AIが暴走したり、予期せぬ悪影響を及ぼしたりするのを防ぎ、社会にとって真に有益な存在にするための研究が、AI開発の中心的なテーマの一つとなります。

したがって、「停滞」という言葉は現状を正確に表してはいません。むしろ、AIは新たなブレークスルーに向けた、質的な進化の時代に突入したと言えるでしょう。

LLMの限界を理解し、ビジネスに活かすならAX CAMP

LLMの限界を正しく理解し、ハルシネーションや情報漏洩といったリスクを管理しながらビジネスで成果を出すには、専門的な知識と実践的なスキルが不可欠です。しかし、「何から学べば良いかわからない」「自社のどの業務に適用できるのか判断できない」といった悩みを抱える企業は少なくありません。

そのような課題を解決するのが、実践型の法人向けAI研修・伴走支援サービス「AX CAMP」です。AX CAMPでは、LLMの仕組みや限界といった基礎知識から、具体的な業務改善に繋げるためのプロンプトエンジニアリング、さらには自社専用のAI開発まで、企業のニーズに合わせた体系的なカリキュラムを提供しています。(出典:【2026年最新】生成AIの企業活用事例17選!導入のポイントや注意点も解説)

AX CAMPの最大の特長は、単なる知識の提供に終わらない「伴走型支援」にあります。経験豊富なコンサルタントが貴社のビジネス課題を深く理解し、研修で学んだスキルを実際の業務に落とし込むまでを徹底的にサポート。AI導入の企画から実装、そして全社的な定着まで、一気通貫でご支援することで、AI活用の成功確率を飛躍的に高めます。

LLMの限界という壁を乗り越え、AIを真の競争力に変えるために、専門家の知見を活用してみませんか。まずは無料の資料請求で、AX CAMPが提供する具体的なサービス内容をご確認ください。

まとめ:LLMの限界を正しく理解し、次世代AIの可能性を探る

本記事では、2026年現在のLLMが直面する技術的・社会的限界から、その根本原因、そして今後の展望までを網羅的に解説しました。LLMは決して万能ではなく、その活用には限界とリスクの正しい理解が不可欠です。

この記事の要点を以下にまとめます。

- LLMの性能向上は「スケール則の限界」と「データ枯渇」により踊り場を迎えている。

- ハルシネーションやバイアス、著作権問題など、技術的・倫理的な課題が多数存在する。

- 限界の根本原因は「自己回帰モデル」の構造と「テキストのみ」の学習方法にある。

- ビジネス活用では、情報の正確性や機密情報漏洩のリスクに十分な注意が必要。

- AI開発は停滞ではなく、マルチモーダルAIなど次世代技術への質的転換期にある。

重要なのは、LLMの限界を悲観的に捉えるのではなく、AIの特性を理解した上で、人間とAIが協業するための最適な役割分担を見出すことです。AIを「思考の壁打ち相手」や「定型業務の自動化ツール」として賢く活用することで、企業は生産性を飛躍的に向上させることができます。

AX CAMPでは、この記事で解説したようなLLMの限界と、それを乗り越えるための実践的な活用法を、貴社のビジネスに合わせて具体的にご提案します。専門家の伴走支援のもと、リスクを最小限に抑えながらAI導入を成功させたいとお考えなら、ぜひ一度、無料相談会にお越しください。