LLM(大規模言語モデル)がどのようにして人間のような文章を生成するのか、その心臓部である

「アーキテクチャ」の仕組みは、一見すると複雑に感じられるかもしれません。

「Transformer」や「Attention」といった専門用語を見聞きしても、具体的にどのような役割を果たしているのかを正確に理解するのは難しいものです。しかし、この基本構造を掴むことで、AIの進化の方向性やビジネスへの応用可能性をより深く洞察できるようになります。

この記事では、LLMの根幹をなすTransformerアーキテクチャの基本から、計算効率と性能を飛躍的に向上させる「Mixture of Experts (MoE)」や「状態空間モデル (SSM)」といった2026年時点の最新トレンドまで、その仕組みと重要性を体系的に解説します。LLMの技術的な背景を理解し、AIを活用したシステム開発や事業企画に役立つ知識を得たい方は、ぜひご一読ください。AIの専門家による伴走支援に興味がある方向けの情報もご紹介します。

LLMアーキテクチャとは?基本構成と重要性

LLMアーキテクチャとは、大量のテキストデータから言語のパターンを学習し、人間が生成するような自然な文章を作り出すための「設計図」です。この設計図の優劣が、LLMの性能、つまり文章生成の質や応答の速さ、そして学習の効率を直接的に決定づけます。そのため、LLMを理解し活用する上で、アーキテクチャの知識は不可欠と言えるでしょう。

LLMの性能は、主にモデルの構造と、その規模を示す「パラメータ数」という2つの要素に大きく依存します。これらの要素がどのように組み合わさり、どう進化してきたのかを知ることが、LLMの能力の源泉を理解する鍵となります。

基本となるエンコーダー・デコーダーモデル

多くのLLMアーキテクチャの原型は、「エンコーダー・デコーダーモデル」にあります。これは、入力された情報を処理する部分(エンコーダー)と、その情報をもとに出力を生成する部分(デコーダー)が連携して動作するモデルです。

具体的には、以下のような役割分担になっています。

- エンコーダー:入力文の意味や文脈を圧縮し、数値のベクトル(意味を凝縮した情報)に変換する。

- デコーダー:エンコーダーが生成したベクトルを受け取り、それを基に次の単語を予測し、文章を生成する。

ただし、全てのLLMがこの両方の構造を持つわけではありません。例えば、文章生成を得意とするGPTシリーズはデコーダーのみ、文章の意味理解に特化したBERTはエンコーダーのみの構造を採用しています。このように、目的に応じて最適な構造が選択されるのが一般的です。

性能を決定づけるスケーリング則

LLMの性能は、モデルを大きくすればするほど向上する傾向にありますが、やみくもに大きくすれば良いわけではありません。モデルの性能を効率的に向上させるための法則が「スケーリング則(Scaling Law)」です。これは、モデルの性能が「パラメータ数」「データセットのサイズ」「計算量」の3つの要素のバランスによって決まるという経験則を指します。

特に、DeepMind社が2022年に発表した研究は、このスケーリング則に大きな影響を与えました。この研究により、従来考えられていたよりもモデルのパラメータ数を増やすより、学習データの量を増やす方が、同じ計算コストでより高い性能を発揮できることが示されたのです。この発見は、その後のLLM開発におけるリソース配分の最適化に大きな指針を与えています。(出典:LLM(大規模言語モデル)とは?仕組みや種類、代表的なモデルを解説)

LLMの心臓部「Transformer」アーキテクチャの仕組み

現在のほとんどのLLMの基盤となっているのが、2017年にGoogleの研究者たちが発表した「Transformer」という画期的なアーキテクチャです。 Transformerが登場する以前の主流であったRNN(再帰型ニューラルネットワーク)系のモデルは、文章を単語の列として順番に処理する逐次処理の仕組みでした。そのため、長い文章になるほど前の単語の情報を忘れやすく、文脈の長距離依存関係を捉えるのが苦手で、処理の並列化が難しいという課題がありました。

Transformerは、後述する「自己注意機構(Self-Attention)」という仕組みを用いることで、文章中の単語間の関連性を距離に関係なく直接的に計算し、文脈を深く理解することを可能にしました。 さらに、処理の並列化が容易であるため、大規模なデータセットを使った学習を高速に行える点も、LLMの発展を大きく加速させた要因です。

文脈を捉える自己注意機構(Self-Attention)

自己注意機構(Self-Attention)は、Transformerの最も革新的な要素であり、文章中のある単語が、他のどの単語と強く関連しているのか、その「注目度」を計算する仕組みです。 これにより、モデルは単語の表面的な意味だけでなく、文脈の中での役割や関係性を捉えることができます。

例えば、「その動物は道路を渡らなかった。なぜなら、それは疲れすぎていたからだ。」という文があったとします。自己注意機構は、「それ」という代名詞が「その動物」を指しているという関連性の強さを数値的に学習し、文脈を正確に理解します。この計算は、入力された各単語のベクトルから「Query(検索クエリ)」「Key(検索対象のキー)」「Value(キーに対応する値)」という3種類のベクトルを生成し、それらの関連度を算出することで実現されます。

多角的な情報を抽出するマルチヘッドアテンション

マルチヘッドアテンションは、自己注意機構をさらに強力にするための仕組みです。これは、自己注意機構の計算を複数(例えば8個や12個)並列で実行し、それぞれの結果を統合するアプローチを指します。

自己注意機構を1つだけ使うと、ある特定の観点からの単語間の関連性しか捉えられない可能性があります。しかし、複数の「ヘッド」を持つことで、あるヘッドは文法的な関係性(主語と述語の関係など)に注目し、別のヘッドは意味的な関連性(同義語や対義語の関係など)に注目するといったように、多角的な視点から文脈情報を抽出できるようになります。これにより、より豊かで複雑な文章のニュアンスをモデルが理解できるようになるのです。

単語の順序を伝える位置エンコーディング

Transformerの自己注意機構は、単語間の関連性を捉える点では非常に強力ですが、そのままでは「どの単語が文のどの位置にあるか」という順序の情報を扱うことができません。文章において語順は意味を決定づける極めて重要な要素です。

この課題を解決するのが「位置エンコーディング(Positional Encoding)」です。これは、各単語の位置情報を示す特殊なベクトルを、単語のベクトルに加算する手法です。三角関数などを用いて、各位置に固有の値を割り当てることで、モデルは単語の絶対的な位置や相対的な位置関係を学習できます。これにより、「AがBを叩いた」と「BがAを叩いた」の違いを正確に認識できるようになるのです。

【2026年最新】注目のLLMアーキテクチャのトレンド

LLMアーキテクチャの世界は、今なお急速な進化を続けています。近年のトレンドは、モデルの性能を極限まで高めると同時に、増大し続ける計算コストをいかに効率化するかという点に集約されます。特に「Mixture of Experts (MoE)」と「状態空間モデル (SSM)」は、効率化と長文処理の向上を狙う研究領域で注目されているアプローチです。

これらの新技術は、LLMの能力を新たな次元へと引き上げる可能性を秘めており、これまで以上に大規模で高性能なモデル開発を可能にすると期待されています。

Mixture of Experts (MoE) による計算効率の向上

Mixture of Experts(MoE)は、巨大な1つのモデルですべてを処理するのではなく、複数の「専門家(Expert)」と呼ばれる小規模なネットワークを組み合わせるアーキテクチャです。 入力されたデータ(トークン)に応じて、「ゲート」や「ルーター」と呼ばれる機構が最適な専門家を選択し、その専門家だけを活性化させて処理を行います。

この仕組みの最大の利点は、モデル全体のパラメータ数を巨大にしながらも、推論時に使用する計算リソースを大幅に削減できる点です。 例えば、8人の専門家がいても、入力ごとに2人だけが働くといった運用が可能になります。実際に一部のオープンソースモデルや商用モデルで採用が公表されており、計算効率と性能を両立させるための重要な技術として応用が進んでいます。(出典:【2026年最新】AIのトレンド予測10選!企業が取るべき戦略とは?)

Transformerを超えるか?状態空間モデル (SSM)

状態空間モデル(SSM)は、Transformerが抱える根本的な課題、すなわち入力される文章が長くなるほど計算量が二乗で増加する(O(n²))という問題を解決する可能性を秘めた、新しいアーキテクチャとして注目されています。SSMはもともと制御工学などで用いられてきた理論ですが、近年の研究で言語モデリングに応用され、大きな成果を上げています。(出典:状態空間モデルに基づく深層学習の発展と展望)

SSMの代表格である「Mamba」などのモデルは、RNN(再帰型ニューラルネットワーク)のように情報を内部の状態として保持しながら、線形時間(O(n))で計算を進めることができます。 これにより、数百万トークンといった超長文の文脈を効率的に処理できる可能性が示されています。まだ研究開発段階の技術ではありますが、Transformerの計算効率の限界を打ち破るポテンシャルを持つことから、次世代LLMのアーキテクチャ候補として世界中の研究者が注目しています。(出典:Mambaによる物体検出:性能向上のためのSSM活用術)

https://media.a-x.inc/llm-open-source

目的別に見るLLMアプリケーションのアーキテクチャパターン

LLMをビジネスで活用する際には、LLM単体をそのまま使うだけでなく、外部のデータやシステムと連携させるアーキテクチャを構築することが一般的です。これにより、LLMの能力を最大限に引き出し、より信頼性が高く、特定の業務に特化したアプリケーションを実現できます。ここでは、その代表的なパターンである「RAG」と「マルチエージェントシステム」について解説します。

これらのパターンを理解することは、自社の課題解決にLLMをどう適用できるかを具体的にイメージする上で非常に重要です。

外部知識を活用するRAG(Retrieval-Augmented Generation)

RAG(Retrieval-Augmented Generation、検索拡張生成)は、LLMが回答を生成する際に、社内文書や最新のウェブ情報など、外部の信頼できる情報源をリアルタイムで参照するアーキテクチャです。 これにより、LLMが学習していない最新情報や、企業独自の専門知識に基づいた回答が可能になります。(出典:Retrieval-Augmented Generation (RAG)とは)

RAGの仕組みは、まずユーザーからの質問に関連する情報をデータベースから検索(Retrieval)し、その検索結果をプロンプトに含めてLLMに渡すという流れです。 このアプローチの最大のメリットは、LLMが事実に基づかない情報を生成してしまう「ハルシネーション」を大幅に抑制できる点です。 また、回答の根拠となった情報源をユーザーに提示できるため、出力結果の信頼性が飛躍的に向上します。(出典:RAG(Retrieval-Augmented Generation)とは?仕組みや活用事例を解説)

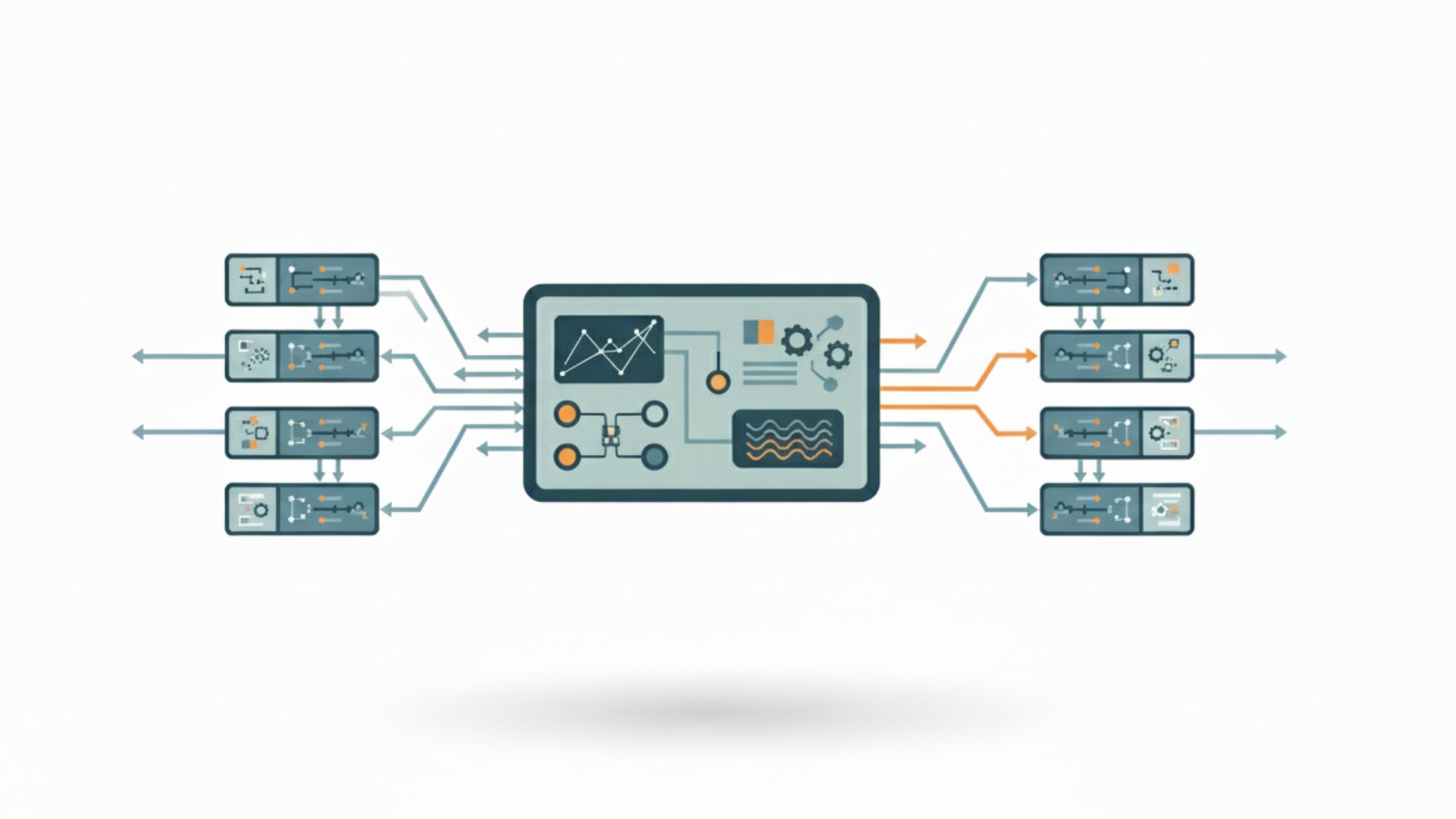

複雑なタスクを分担するマルチエージェントシステム

マルチエージェントシステムは、1つの複雑なタスクを、それぞれ異なる役割を持つ複数の自律的なAIエージェントが協調して解決するアーキテクチャです。単一のLLMでは対応が難しい、多段階の思考や複数のツール利用が必要な問題に対して有効なアプローチとされています。

例えば、「最新の市場動向を調査し、競合と比較した上で、新商品のマーケティング戦略を立案せよ」というタスクがあったとします。この場合、「調査エージェント」がウェブ検索を行い、「分析エージェント」が収集したデータを分析し、「戦略立案エージェント」が最終的なレポートを作成する、といった役割分担が考えられます。このように、タスクを分解し、専門家チームのように連携させることで、より高度で精度の高いアウトプットを目指すのがマルチエージェントシステムの狙いです。

代表的なLLMと採用されているアーキテクチャ

現在、世界中で様々なLLMが開発されていますが、その多くは本記事で解説したTransformerアーキテクチャを基礎としています。 しかし、各モデルは性能や効率を追求するために、それぞれ独自の改良や工夫を加えています。主要なLLMがどのようなアーキテクチャを採用しているかを知ることで、それぞれのモデルの特性や得意分野をより深く理解できます。

ここでは、2025年9月時点において業界で注目されている代表的なLLMファミリーを取り上げ、公表されている情報や専門家の分析に基づき、そのアーキテクチャの特徴を比較します。ただし、特に各モデルの内部構造については公式に詳細が明かされていない部分も多く、確定情報と推測が混在している点にご留意ください。

| モデルファミリー | 開発元 | ベースアーキテクチャ | 特徴的な技術・コンセプト |

|---|---|---|---|

| GPTシリーズ | OpenAI | Transformer (デコーダーオンリー) | クエリに応じて最適なモデルを振り分けるルーティング技術の採用(推測を含む)。 |

| Geminiファミリー | Transformer (マルチモーダル) | ネイティブなマルチモーダル設計、MoE技術の応用による高効率化(一部モデルで採用と公表)。 | |

| Claudeファミリー | Anthropic | Transformer (デコーダーオンリー) | 長文コンテキスト処理能力、安全性と倫理性を重視した設計(Constitutional AI)。 |

OpenAIのGPTシリーズは、一貫してデコーダーオンリーのTransformerがベースとされています。特に最新世代では、クエリ(指示)の内容に応じて最適な専門モデルを動的に選択するルーティングシステムが採用されている可能性が指摘されており、これは従来のトークン単位で専門家を切り替えるMoEとは異なるアプローチかもしれません。

GoogleのGeminiファミリーは、テキストだけでなく画像や音声などを統合的に扱えるよう、最初からマルチモーダルを前提として設計されている点が特徴です。一部の高性能モデルでは、計算効率を高めるためにMoEアーキテクチャが採用されていることが公表されています。AnthropicのClaudeファミリーは、特に数十万トークンを超える長文の読解・生成能力に優れており、AIの安全性を確保するための独自の設計思想が組み込まれています。アーキテクチャの詳細は非公開ですが、現時点(2025年9月)でMoEの採用は公式に発表されていません。

このように、各社はTransformerという共通の土台の上に、自社の強みや目指す方向性に応じた独自のアーキテクチャ改良を重ね、熾烈な開発競争を繰り広げているのです。(出典:【2026年最新】主要LLM比較!GPT-5、Claude3、Gemini 2.5 Proの性能や料金を徹底解説)

LLMアーキテクチャの専門知識を深めるならAX CAMP

この記事で解説したLLMアーキテクチャの仕組みは、AI技術の進化を理解する上で非常に重要です。しかし、TransformerやMoEといった概念を理論として知っているだけでは、それをビジネスの現場で活かすことは難しいかもしれません。本当に価値を生むのは、これらの技術を自社の課題解決にどう結びつけるかを考え、実践するスキルです。

例えば、当社の研修を導入された企業様からは、具体的な成果が報告されています。

- LP制作の外注費を月10万円削減:ライティング業務をAIで内製化し、制作時間も3営業日から2時間に短縮(グラシズ様)

- 記事執筆時間を24時間から10秒に短縮:コンテンツ制作の生産性が飛躍的に向上(Route66様)

- SNS運用時間を3時間から1時間に短縮:月間1,000万インプレッションを達成し、業務時間を約67%削減(C社様)

もし、あなたが「LLMの技術的な背景をさらに深く学びたい」「学んだ知識を具体的な業務改善や新規事業開発に繋げたい」とお考えなら、実践的なスキル習得に特化した研修プログラムを検討してみてはいかがでしょうか。独学だけでは得られない体系的な知識と、実務に即した応用力を身につけることができます。

私たちAX CAMPが提供する法人向けAI研修では、第一線で活躍する専門家が、LLMの基礎理論から最新のアーキテクチャトレンド、さらには具体的な業務活用シナリオまでを網羅したカリキュラムを提供しています。受講者一人ひとりの課題に寄り添う伴走支援を通じて、知識を実務で「使いこなせる」状態へと導くことを目指します。自社にAI活用を定着させ、競争力を高めたいご担当者様は、まずはお気軽に無料相談へお申し込みください。

まとめ:LLMアーキテクチャを理解してAI開発を加速させよう

本記事では、LLMの根幹を支えるアーキテクチャについて、その基本から最新トレンドまでを解説しました。LLMの進化と応用を理解する上で、押さえておくべき重要なポイントは以下の通りです。

- Transformerが基本:現代のLLMのほとんどは、自己注意機構を持つTransformerが基盤です。

- 文脈理解が鍵:自己注意機構により、単語間の関連性を捉え、文脈を深く理解します。

- 効率化がトレンド:MoEは、専門家モデルを使い分けることで計算効率を大幅に向上させるアプローチとして注目されています。

- 長文処理への挑戦:SSMは、Transformerの計算量の課題を解決する次世代技術として期待されています。

- 応用パターン:RAGは、外部知識を参照することで回答の信頼性を高める実践的な手法です。

LLMアーキテクチャの知識は、単なる技術的な好奇心を満たすだけでなく、AIプロジェクトの企画や開発において、適切なモデル選定やシステム設計を行うための羅針盤となります。これらの仕組みを理解することで、AIの可能性と限界を見極め、より効果的な活用戦略を描くことができるでしょう。

AX CAMPでは、こうした専門的な知識を、貴社のビジネス課題に直結する実践的なスキルへと昇華させるための支援を行っています。AI導入による業務の自動化や生産性向上を本気で目指すなら、専門家の知見を活用することが成功への最短ルートです。AIの力を最大限に引き出すための具体的なステップについて、まずは無料相談で詳しくお話ししませんか。