大規模言語モデル(LLM)が、まるで人間のように自然な文章を生成できるのはなぜか、その裏側にある

「ベクトル」技術について疑問に思ったことはありませんか?実は、LLMが言葉の意味を理解し、文脈に応じた適切な回答を作り出す上で、ベクトル化というプロセスが中心的な役割を果たしています。この技術を理解することで、なぜLLMが時に不正確な情報を生成するのか(ハルシネーション)、そしてその対策として注目されるRAG(検索拡張生成)の仕組みまで、より深く知ることが可能です。

この記事では、LLMとベクトルの関係を基礎から徹底的に解説します。ベクトル化の仕組み、それによって何が可能になるのか、そしてビジネスでどのように活用されているのかを、具体的な事例を交えながら探っていきます。AI活用の精度を高めたいエンジニアや企画担当者の方は、ぜひ最後までご覧ください。貴社のAI導入・活用を加速させるヒントがここにあります。実践的なAI研修や導入支援にご興味のある方は、弊社の「AX CAMP」に関する資料もぜひご活用ください。

記事:【AI導入しないことが経営リスクになる時代】先行企業が手にした圧倒的な競争優位とは?

LLMにおけるベクトル(ベクトル化)とは?

結論として、LLMにおけるベクトル化とは、テキストや画像などの情報を、コンピュータが処理しやすい数値の配列(ベクトル)に変換する技術のことです。人間が使う言葉や画像そのものは、コンピュータにとって単なるデータの羅列に過ぎません。そこで、これらの非構造化データを意味的な特徴を捉えた数値のベクトルに変換することで、LLMは初めてその内容を理解し、処理できるようになります。

このプロセスは「Embedding(エンベディング、埋め込み)」とも呼ばれ、LLMが言語の壁を越えて多様なデータを扱えるようにするための根幹技術です。この変換により、単語や文の複雑な関係性を数学的に扱えるようになり、AIの応用範囲が大きく広がります。

テキストや画像を数値の配列で表現する技術

ベクトル化の核心は、単語、文章、画像といったデータを高次元のベクトル空間に配置することにあります。例えば、「犬」という単語は[0.2, 0.9, -0.1, …]といった数百から数千次元の数値のリストとして表現されます。同様に、「猫」という単語も別の数値リストで表現されるのです。

重要なのは、この数値変換がランダムに行われるのではなく、対象の持つ意味や文脈的な特徴を保持したまま行われる点です。これにより、コンピュータは数値の演算を通じて、データ間の意味的な関係性を捉えることが可能になります。

「意味の近さ」を多次元空間の距離で測る

ベクトル化されたデータは、多次元空間上の点としてプロットされます。この空間では、意味的に近い単語や文章は、ベクトル空間上でも物理的に近い位置に配置されます。例えば、「犬」と「猫」のベクトルは、「机」や「車」のベクトルよりもずっと近くに位置することになるのです。

この「距離」を計算することで、LLMは単語や文章の類似度を定量的に判断できます。2つのベクトル間の距離が小さければ関連性が高く、大きければ関連性が低いと判断します。この仕組みが、後述する高度な意味検索やレコメンデーション機能を実現する基盤となっています。

Embedding(埋め込み)との関係性

「ベクトル化」としばしば同義で使われるのが「Embedding(エンベディング)」という言葉です。Embeddingは、単語や文章などの情報を、意味を保持した密なベクトル表現に変換する技術そのものや、その変換されたベクトル自体を指します。

つまり、ベクトル化はEmbeddingを実現するための一連のプロセスと捉えることができます。OpenAIなどのAPIを利用すれば、専門的な知識がなくともテキストデータをEmbedding(ベクトル化)することが可能です。この手軽さが、多くの開発者にとってLLMを活用したアプリケーション開発のハードルを下げています。

なぜLLMはテキストを「数値のベクトル」で扱うのか?

LLMがテキストを数値のベクトルで扱う最大の理由は、コンピュータが自然言語の「意味」を数学的に処理できるようにするためです。人間は「犬」と「猫」が似ていて、「車」とは全く違うことを経験的に理解していますが、コンピュータは文字の並びだけではその違いを認識できません。

テキストをベクトルに変換することで、単語や文章の関係性をベクトル空間内の距離や角度として計算できるようになります。これにより、「意味が近い」「対義語である」「上位・下位概念である」といった複雑な関係性を、コンピュータが数学的な演算で捉えられるようになるのです。このベクトル表現がなければ、LLMが文脈を理解したり、質問に対して適切な回答を生成したりすることは根本的に不可能です。

ベクトルが可能にする「意味」での検索

ベクトル化技術がもたらした最も大きな革新の一つが、「意味」による検索、すなわちセマンティック検索(意味検索)の実現です。これまでの検索エンジンは、入力されたキーワードと完全に一致する文字列を探す「キーワード検索」が主流でした。

しかし、ベクトル検索では、検索クエリ(質問文)もベクトルに変換し、データベース内に保存されている膨大な文書のベクトルの中から、空間的に最も距離が近い(=意味的に最も類似している)ものを見つけ出します。これにより、キーワードが完全一致しなくても、ユーザーの検索意図を汲み取った、より関連性の高い情報を提供できるようになりました。例えば、「AIに関連する研究」と検索すれば、「データサイエンス」に関する文書もヒットさせることが可能です。

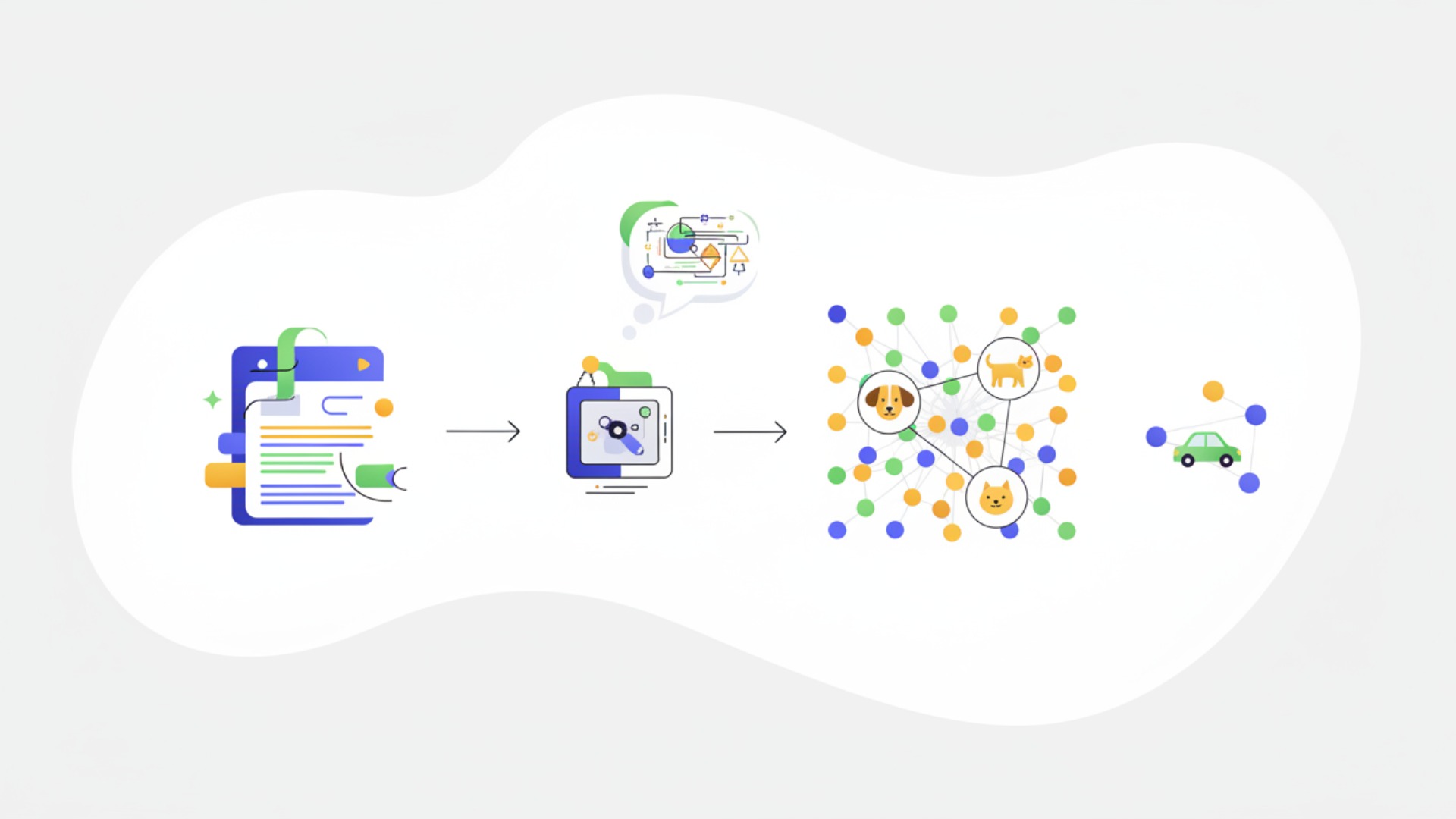

テキストがベクトルに変換される仕組み

テキストが意味を持つベクトルに変換されるまでには、大きく分けて3つのステップがあります。まず文章を最小単位に分解し、それを数値に置き換え、最終的に意味を凝縮したベクトルを生成します。この一連のプロセスによって、コンピュータは言葉の壁を越えてテキストの深い文脈を理解できるようになります。

ステップ1:トークン化(単語や文字への分割)

最初のステップは「トークン化」です。これは、入力された文章を、LLMが処理できる最小単位である「トークン」に分割するプロセスを指します。トークンは、単語、句読点、あるいはサブワード(単語より小さい単位)などです。

例えば、「今日は良い天気です。」という文章は、「今日」「は」「良い」「天気」「です」「。」のようにトークン化されます。この分割作業が、後続の処理でコンピュータが文章の構造を解析するための基礎となります。

ステップ2:数値IDへの変換

次に、トークン化された各トークンを、あらかじめ定義された辞書(ボキャブラリ)に基づいて一意の数値IDに変換します。例えば、「今日」は「101」、「は」は「102」といった具体的な数値に置き換えられます。

この段階では、まだ各トークンは独立した数値であり、意味的な関連性は考慮されていません。あくまで、コンピュータが後続の計算処理を行うための準備段階です。

ステップ3:Embeddingモデルによるベクトル化

最後のステップが、Embeddingモデルを用いて数値IDを高次元の密なベクトル(Dense Vector)に変換するプロセスです。ここで初めて、各トークンに「意味」が与えられます。

Embeddingモデルは、大量のテキストデータを事前学習する過程で、どの単語がどのような文脈で使われるかを学習しています。その結果、似たような文脈で出現する単語(例:「犬」と「猫」)は、ベクトル空間上で近い位置に配置されるベクトルを生成できるようになるのです。このステップを経て、単なる数値の羅列だったテキストが、意味的な関係性を持つベクトルデータへと昇華されます。

ベクトル化によってLLMで実現できること

ベクトル化は、単にテキストを数値に変換するだけでなく、LLMの能力を飛躍的に向上させ、多様なアプリケーションを実現する基盤技術です。意味に基づいた高度な情報検索から、個々のユーザーに最適化された体験の提供まで、その可能性は多岐にわたります。

高度なセマンティック検索(意味検索)の実装

ベクトル化によって、キーワードの一致に頼らないセマンティック検索が可能になります。ユーザーが入力した質問文の「意図」をベクトルとして捉え、データベース内の情報と意味的な類似度でマッチングさせます。これにより、表記ゆれや曖昧な表現にも柔軟に対応し、ユーザーが本当に求めている情報を提供できます。

RAG(検索拡張生成)による回答精度向上

RAG(Retrieval-Augmented Generation:検索拡張生成)は、LLMの回答精度を向上させるための重要な技術です。LLMは時に事実に基づかない情報を生成する「ハルシネーション」という課題を抱えています。

RAGでは、ユーザーの質問に関連する情報を、まずベクトル検索を用いて信頼できる外部データベース(社内文書など)から探し出します。そして、その検索結果を参考情報としてLLMに与え、回答を生成させます。これにより、LLMが外部の信頼できる情報を参照するため、ハルシネーションを抑制しやすくなります。ただし、参照情報を誤って解釈するリスクは残るため、回答に根拠を提示させるなどの対策を組み合わせることが、回答の信頼性を高める上で重要です。

商品やコンテンツのパーソナライズと推薦

ECサイトや動画配信サービスなどでは、ユーザーの過去の閲覧履歴や購買履歴をベクトル化し、そのユーザーの「好み」のベクトルを算出します。そして、ベクトル空間上でそのユーザーの好みに近い商品やコンテンツのベクトルを探し出し、推薦(レコメンデーション)します。

これにより、一人ひとりの興味関心に合わせたパーソナライズされた体験を提供できます。ベクトル化は、顧客満足度の向上とビジネス機会の創出に直結する技術と言えるでしょう。

ベクトル検索の仕組みと重要性

ベクトル検索は、LLMが膨大な情報の中から適切な答えを見つけ出すための羅針盤のような役割を果たします。従来の検索方法とは根本的に異なり、「意味」を基準に情報を整理・検索することで、LLMの応答精度を劇的に向上させ、弱点であるハルシネーションを抑制する鍵となります。

従来のキーワード検索との決定的な違い

従来のキーワード検索とベクトル検索の最も大きな違いは、検索の基準が「文字列の一致」か「意味の類似性」かという点です。キーワード検索は、入力された文字と完全に一致する文書を探すため、同義語や表記ゆれ(例:「PC」と「パソコン」)に対応できず、関連性の高い情報を見逃すことがありました。

一方、ベクトル検索は、単語や文章を意味を捉えたベクトルに変換して比較するため、キーワードが一致しなくても文脈的に関連性が高ければ検索結果として表示できます。この「意味を理解する」能力が、ユーザーの曖昧な検索意図にも応えられる、より柔軟で高精度な検索を実現します。

最近傍探索アルゴリズムの役割

ベクトル検索の裏側では、「最近傍探索(Nearest Neighbor Search)」というアルゴリズムが動いています。これは、大量のベクトルデータの中から、クエリ(質問)のベクトルに最も近いベクトルを効率的に見つけ出す技術です。

データ量が膨大になると、すべてのデータとの距離を計算するのは非効率的です。そのため、近似的に最も近いベクトルを高速に見つけ出す「近似最近傍探索(ANN)」といったアルゴリズムが用いられます。これらのアルゴリズムがあるおかげで、数百万、数億といった大規模なデータセットに対しても、瞬時に類似検索を行うことが可能になっています。

LLMのハルシネーションを抑制する効果

LLMの大きな課題であるハルシネーション(事実に基づかない情報を生成する現象)に対しても、ベクトル検索は有効な対策となります。RAG(検索拡張生成)の仕組みでベクトル検索を用いることで、LLMが回答を生成する際に、信頼できる情報源(社内データベースなど)を参照させることができます。

これにより、LLMが自身の知識だけで不確かな回答を創作するのを防ぎ、回答の事実性(ファクトフルネス)を大幅に向上させることができます。企業がコンプライアンスや正確性を重視する業務にLLMを導入する上で、ベクトル検索は不可欠な技術と言えるでしょう。

LLMとベクトル技術の具体的な活用事例

LLMとベクトル技術の組み合わせは、既に多くのビジネスシーンで具体的な成果を上げています。社内情報の効率的な活用から、顧客体験の向上、さらには煩雑な問い合わせ業務の自動化まで、その応用範囲は広がり続けています。

事例1:社内ナレッジ検索システムの構築

多くの企業では、社内規定、マニュアル、過去の議事録といった膨大なナレッジが様々な場所に散在し、有効活用されていないという課題を抱えています。ここにベクトル検索を導入することで、従業員は自然言語で質問するだけで、関連する情報を文書の場所を問わず横断的に探し出すことが可能になります。

例えば、「在宅勤務の経費精算について知りたい」と入力すれば、キーワードが完全一致しなくても、関連する社内規定や申請マニュアルが即座に提示されます。これにより、情報検索にかかる時間が大幅に削減され、生産性向上に繋がります。

Inmark様の事例

Web広告運用代行を手がけるInmark様では、毎日の広告チェック業務に多くの時間を費やしていました。AX CAMPでAIツールの活用法を学び、ベクトル検索技術などを応用することでこの業務を自動化。結果として、毎日1時間以上かかっていたチェック業務をわずか2週間でゼロにすることに成功しました。(出典:【Inmark株式会社様】AI研修で広告チェック業務が2週間でゼロに! 属人化解消と生産性向上を実現したAX CAMPの魅力とは)

事例2:ECサイトにおける画像・テキストでの商品検索

ECサイトでは、ベクトル技術は顧客の購買体験を大きく向上させます。ユーザーが探している商品の画像をアップロードするだけで、AIがその画像の特徴をベクトル化し、似たデザインや雰囲気の商品をデータベースから推薦する「画像検索」がその一例です。

また、「春にぴったりの軽やかなワンピース」といった曖昧なテキストでの検索に対しても、セマンティック検索が有効に機能します。これにより、顧客は具体的な商品名を知らなくても、自分のイメージに近い商品を簡単に見つけられるようになります。

エムスタイルジャパン様の事例

美容健康食品を扱うエムスタイルジャパン様は、コールセンターでの履歴確認や広告レポート作成といった手作業に課題を抱えていました。AX CAMPの研修を通じて業務自動化を推進し、月に16時間かかっていたコールセンターの確認業務をほぼゼロにするなど、全社で月100時間以上の業務削減を達成しました。(出典:【株式会社エムスタイルジャパン様】月100時間以上の“ムダ業務”をカット! 全社的な「AI当たり前文化」を築いた、AX CAMP伴走支援の軌跡)

事例3:顧客からの問い合わせ内容の自動分類とFAQ推薦

カスタマーサポートの現場では、日々大量の問い合わせが寄せられます。ベクトル化技術を使えば、問い合わせ内容の意味を解析し、事前に設定されたカテゴリ(例:「料金について」「使い方について」)に自動で分類できます。

さらに、分類された内容に基づいて、関連するFAQ(よくある質問)を自動でユーザーに提示することも可能です。これにより、オペレーターの負担を軽減し、ユーザーは24時間365日、自己解決の機会を得ることができます。結果として、顧客満足度の向上とサポート業務の効率化を両立できます。

WISDOM合同会社様の事例

SNS広告制作を行うWISDOM合同会社様では、事業拡大に伴う人材採用コストと業務負荷が課題でした。AX CAMPでAI活用スキルを習得し、問い合わせ対応を含む様々な業務を自動化。その結果、採用予定だった2名分の業務をAIで代替することに成功し、コスト削減と生産性向上を実現しました。(出典:【WISDOM合同会社様】AI導入で採用2名分の人件費を削減! 未経験から自走する組織を築いたAX CAMPの教育とは)

主要なEmbeddingモデルと選び方のポイント【2026年版】

ベクトル化の品質は、使用するEmbeddingモデルの性能に大きく左右されます。現在、OpenAIやGoogleといった大手テック企業から、多様なオープンソースコミュニティまで、様々なモデルが提供されています。それぞれのモデルは特性やコストが異なるため、自社の目的や要件に合わせて最適なものを選択することが重要です。

1. OpenAI社のモデル(例:text-embedding-3-large)

OpenAI社は、GPTシリーズで知られるLLMだけでなく、高性能なEmbeddingモデルも提供しています。最新モデルの一つである「text-embedding-3-large」は、非常に高い精度を誇り、特に多言語のテキストに対する意味理解能力に優れています。

従量課金制で利用でき、APIを通じて手軽に高度なベクトル化を実現できるため、精度を最優先する商用アプリケーションや、多言語対応が必須のサービスに適しています。OpenAIの公式レポートによると、多言語評価ベンチマークであるMTEBやMIRACLで高いスコアを記録しています。ただし、特定の日本語タスクや専門分野においては、他のモデルが有利な場合もあるため、実際の業務データを用いた検証が重要です。(出典:New embedding models and API updates)

2. Google社のモデル(例:text-embedding-gecko)

Google社も、Vertex AIプラットフォームなどを通じて多様なEmbeddingモデルを提供しています。「text-embedding-gecko」などのモデルは、Googleの長年にわたる検索技術と自然言語処理の研究に裏打ちされており、安定した性能とスケーラビリティが特長です。

Google Cloudの他のサービスとの連携がスムーズであるため、既にGoogle Cloudをインフラとして利用している企業にとっては導入しやすい選択肢と言えるでしょう。(出典:Use embedding models for text)

3. オープンソースモデル(例:Sentence Transformers)

特定の要件に合わせてモデルをカスタマイズしたい場合や、コストを抑えたい場合には、オープンソースのEmbeddingモデルが有力な選択肢となります。Sentence Transformersは、その代表的なライブラリの一つで、様々な事前学習済みモデルが公開されており、特定のドメインのデータでファインチューニングすることも可能です。

ただし、オープンソースモデルを活用するには、モデルの選定、環境構築、運用管理などを自社で行う必要があり、一定の技術力が求められます。

用途やコストに応じたモデル選定の基準

最適なEmbeddingモデルを選ぶためには、以下の基準を総合的に考慮する必要があります。

| 選定基準 | 考慮すべきポイント |

|---|---|

| 精度 | 自社のタスク(検索、分類など)において、どの程度の意味理解能力が必要か。特に専門用語や業界固有の表現を扱う場合は、ベンチマークスコアなどを参考に慎重に評価する。 |

| コスト | 商用APIは処理量に応じた従量課金、オープンソースは自社での運用コスト(サーバー代、人件費)がかかる。予算と予想される利用量から費用対効果を算出する。 |

| 対応言語 | 日本語のみで十分か、多言語対応が必要か。多言語対応モデルは一般的に汎用性が高いが、特定言語に特化したモデルの方が精度が高い場合もある。 |

| 処理速度 | リアルタイムでの応答が求められるアプリケーションか、バッチ処理で十分か。モデルのサイズや次元数によって処理速度は異なる。 |

| カスタマイズ性 | 自社データでファインチューニングを行い、独自のベクトル表現を獲得したいか。オープンソースモデルはカスタマイズの自由度が高い。 |

これらの基準を元に、まずは小規模なPoC(概念実証)で複数のモデルを試し、自社のユースケースに最も合致するものを見極めるアプローチが有効です。

ベクトルデータを格納するベクトルデータベースとは?

Embeddingモデルによって生成された大量のベクトルデータを効率的に管理し、高速な検索を実現するために特化したシステムが「ベクトルデータベース」です。LLMを活用したアプリケーション、特にRAGのようにリアルタイムでの検索性能が求められるシステムにおいて、ベクトルデータベースは必須のインフラとなりつつあります。(出典:ベクトルデータベースの深堀り:原理、活用方法、そして選び方まで徹底解説)

高速な類似性検索に特化したデータベース

ベクトルデータベースの最大の特徴は、高次元のベクトルデータに対する類似性検索(ベクトル検索)を極めて高速に実行できる点です。従来のデータベースは、特定の条件に合致するデータを抽出することには長けていましたが、ベクトル間の距離計算のような複雑な処理は得意ではありませんでした。

ベクトルデータベースは、近似最近傍探索(ANN)などの特殊なインデックス技術やアルゴリズムを用いることで、数百万、数億件のベクトルデータの中からでも、ミリ秒単位で類似ベクトルを検索することを可能にします。

主要なベクトルデータベースの種類

現在、市場には様々なベクトルデータベースが存在し、それぞれに特徴があります。代表的なものとして以下が挙げられます。

- Pinecone: フルマネージドのクラウドサービスとして提供され、導入が容易。

- Weaviate: オープンソースでありながら、高度な検索機能を持つ。

- Milvus: 大規模なデータセットに対応可能なオープンソースのデータベース。

- Elasticsearch: 従来の強力な全文検索機能に加え、近年のバージョンではベクトル検索機能も統合されており、ハイブリッド検索の基盤として利用できます。

これらの選択肢の中から、スケーラビリティ、運用形態(クラウドかオンプレミスか)、コスト、既存システムとの連携性などを考慮して選定する必要があります。

従来のリレーショナルデータベースとの違い

従来のリレーショナルデータベース(RDB)とベクトルデータベースの最も大きな違いは、データの格納方法と得意な処理にあります。RDBは、行と列で構成されるテーブル形式で構造化データを厳密に管理し、SQL言語を用いて正確なデータを抽出することを得意とします。

一方、ベクトルデータベースは、非構造化データから抽出されたベクトルデータを格納し、「意味の近さ」という曖昧な基準で高速に検索することに特化しています。両者は競合するものではなく、用途に応じて使い分ける、あるいは組み合わせて利用される補完的な関係にあるのです。

https://media.a-x.inc/llm-vector-db

LLMのベクトル活用における課題と今後の展望

LLMとベクトル技術は急速に進化していますが、その活用をスケールさせていく上ではいくつかの課題も存在します。一方で、これらの課題を克服するための研究開発も活発に進んでおり、将来的にはさらに高度で洗練されたAIの実現が期待されています。

計算コストとスケーラビリティの課題

高品質なベクトルを生成するEmbeddingモデルや、大規模なベクトルデータを扱うベクトルデータベースは、相応の計算リソース(GPUなど)を必要とし、コストが課題となる場合があります。特に、データ量が億単位に達するような大規模サービスでは、インデックスの構築や更新、検索処理にかかるコストと時間をいかに最適化するかが重要になります。

また、新しいデータが頻繁に追加される環境では、インデックスを効率的に更新し、検索精度と速度を維持し続けるための運用設計も課題となります。

マルチモーダル化の進展とベクトル表現の進化

今後の大きなトレンドとして、テキストだけでなく、画像、音声、動画など複数の種類の情報(モダリティ)を統合的に扱う「マルチモーダルAI」の進化が挙げられます。これに伴い、ベクトル表現も進化しています。

異なるモダリティの情報を共通のベクトル空間上で表現し、例えば「犬が吠えている画像」と「『ワンワン』という音声」を意味的に近いベクトルとして扱う研究が進んでいます。この技術が発展すれば、より人間の感覚に近い、複合的な情報理解が可能なAIが実現するでしょう。

https://media.a-x.inc/llm-multimodal

ハイブリッド検索による精度と網羅性の両立

ベクトル検索(意味検索)は非常に強力ですが、専門用語や製品型番、特定の固有名詞といったキーワードが重要なケースでは、従来のキーワード検索の方が高い精度を発揮することがあります。そこで、両者の長所を組み合わせた「ハイブリッド検索」が注目されています。

ハイブリッド検索は、ベクトル検索とキーワード検索を同時に実行し、それぞれの結果を統合して最適なランキングを生成するアプローチです。これにより、意味の類似性(網羅性)とキーワードの正確性(精度)を両立させ、よりユーザーの意図に沿った、信頼性の高い検索結果を提供することが可能になります。

LLMのビジネス活用ならAX CAMPにお任せください

LLMとベクトル技術の可能性を自社のビジネスに活かしたいとお考えなら、ぜひAX CAMPにご相談ください。多くの企業が「何から手をつければ良いかわからない」「専門知識を持つ人材がいない」といった課題に直面しています。AX CAMPは、そうした課題を解決するための実践的な法人向けAI研修・伴走支援サービスです。

私たちの強みは、単なる知識の提供に留まらない点にあります。貴社の具体的な業務内容や課題をヒアリングし、実務に直結するAI活用の企画立案から、プロトタイプの開発、そして現場への導入・定着までを一気通貫でサポートします。ベクトル検索を用いた社内ナレッジシステムの構築や、RAGによる顧客対応の自動化など、記事で紹介したような具体的なソリューションの実現を支援します。

研修では、エンジニアだけでなく、企画職やマネージャー層も対象とし、それぞれの役割に応じた最適なカリキュラムを提供。AIを「使う側」と「作る側」双方の視点から、全社的なAIリテラシーの向上と活用文化の醸成を目指します。まずは無料相談から、貴社の可能性を広げる第一歩を踏み出してみませんか。

まとめ:LLMとベクトルの関係を理解しビジネス活用を成功させよう

本記事では、LLMの根幹技術である「ベクトル」について、その仕組みからビジネスでの活用事例、将来の展望までを網羅的に解説しました。最後に、重要なポイントを振り返ります。

- ベクトル化とは:テキストや画像などの情報を、意味を保持したままコンピュータが扱える数値の配列に変換する技術。

- ベクトル検索:キーワード一致ではなく「意味の近さ」で検索する技術で、曖昧な表現にも対応可能。

- RAGへの応用:ベクトル検索で信頼性の高い情報を参照させることで、LLMの回答精度を向上させ、ハルシネーションを抑制。

- ビジネス活用:社内ナレッジ検索、ECサイトの推薦、顧客対応の自動化など、幅広い分野で業務効率化と付加価値創出に貢献。

- 今後の展望:マルチモーダル化やハイブリッド検索の進化により、さらに高度なAI活用が期待される。

LLMとベクトルの関係性を正しく理解することは、これからのAI時代においてビジネスを成功させるための必須知識と言えるでしょう。しかし、理論の理解と現場での実践の間には、依然として大きなギャップが存在します。

もし、貴社が「AIを導入したいが、具体的な進め方がわからない」「専門家の支援を受けながら、着実に成果を出したい」とお考えであれば、AX CAMPの提供する伴走支援サービスが最適な解決策となります。専門的な知見を持つコンサルタントが、貴社の状況に合わせた最適な活用法を提案し、導入から定着までを徹底的にサポートします。まずは、無料の資料請求や個別相談会で、具体的な支援内容をご確認ください。