会議の議事録、大量の業界レポート、日々流れ込んでくるニュース記事。これらの情報をすべて読み込み、要点を把握する作業に多くの時間を費やしていないでしょうか。LLM(大規模言語モデル)による要約は、こうした情報処理の課題を解決する強力な技術です。人間のように文脈を深く理解し、自然で的確な要約を瞬時に生成することで、情報収集や資料作成のあり方を根本から変える力を持っています。

この記事では、LLMによる要約の基本的な仕組みから、長文を扱うための主要な手法、そして精度を極限まで高めるプロンプトのコツまで、網羅的に解説します。さらに、Pythonを使った具体的な実装例や、実際のビジネス現場での活用事例も紹介します。自社の業務に合わせたAIの導入や活用方法について、より具体的な情報を求める方には、弊社AX CAMPの資料もご参考になるはずです。

LLMによる要約とは?2026年最新の仕組みと基本を解説

結論:LLM(大規模言語モデル)による要約とは、AIがテキストの文脈を理解し、重要なポイントをまとめた新しい文章を生成する技術です。人間が文章の要点を掴んで自分の言葉で説明するように、LLMは単語や文の関係性を確率的に計算し、文脈に沿った自然な要約文を作り出します。

この技術の根幹には、「Transformer」と呼ばれるニューラルネットワークのアーキテクチャが存在します。Transformerは、文章中のある単語が他のどの単語と強く関連しているかを効率的に学習する仕組みです。これにより、文章全体の意味やニュアンスを深く捉えることが可能になり、従来のキーワード抽出型の手法とは一線を画す、高品質な要約が実現されています。

抽出型要約と生成型要約の違い

AIによる要約は、大きく「抽出型」と「生成型」の2種類に分けられます。両者の違いは、要約文をどのように作成するかにあります。

抽出型要約は、元の文章に含まれる文の中から、重要だと判断される部分を抜き出してつなぎ合わせる手法です。アルゴリズムが比較的シンプルで高速に動作する一方、元の文章にない表現は使えません。そのため、要約が不自然になったり、文脈が途切れたりすることがあります。

一方で生成型要約は、LLMが得意とするアプローチです。元の文章全体の内容を一度理解し、その意味を解釈した上で、全く新しい文章として要約を生成します。このため、より自然で人間が作成したような、流暢で分かりやすい要約を作成できるのが最大の特長です。柔軟性も高く、文字数や文体、要約の視点を細かく指定することもできます。

| 種類 | 特徴 | メリット | デメリット |

|---|---|---|---|

| 抽出型要約 | 元の文から重要な部分を抜き出す | ・処理が高速 ・事実の正確性が高い | ・文章が不自然になりやすい ・元の文にない表現は使えない |

| 生成型要約 | 内容を理解し、新しい文章を生成する | ・自然で流暢な文章 ・要約の長さや文体を調整可能 | ・ハルシネーションのリスク ・計算コストが高い |

従来のAI要約との進化点 – Gemini 3・GPT-5.2世代の能力

LLMの登場により、AIによる要約技術は飛躍的な進化を遂げました。従来のAI要約は、主にTF-IDFなどの統計的手法を用いて、文章中で頻出する単語を重要なキーワードとみなし、それらを含む文を抽出する「抽出型」が主流でした。

しかし、2025年後半に登場したGoogleのGemini 3やOpenAIのGPT-5.2といった最新のLLMは、文脈を深く理解する能力が格段に向上しています。単語の出現頻度だけでなく、文法構造や単語間の複雑な関係性を捉えることで、「AはBの原因である」といった因果関係や、「しかし」という逆接のニュアンスまで汲み取ることが可能です。これにより、表面的なキーワードを拾うだけでは不可能だった、文章の本質を捉えた質の高い要約が可能になったのです。(出典:Claude Sonnet 4.5を超える性能の「Claude 4」やマルチモーダルモデル「Claude Sonnet 4.5」などが登場予定 – GIGAZINE)

LLMで要約を行うメリット

LLMによる要約を活用する最大のメリットは、情報処理にかかる時間を劇的に短縮し、生産性を飛躍的に向上させる点にあります。これまで人間が数時間かけて行っていた作業を、AIがわずか数秒から数分で完了させることが可能です。(出典:世界初、映像情報から人の感情・関係性・行動目的をテキストで構造化する技術を開発 | Panasonic Newsroom Japan)

具体的なメリットとしては、主に以下の4点が挙げられます。

- 業務時間の大幅な短縮

- 情報収集の質の向上

- 属人性の排除と品質の標準化

- 多言語への迅速な対応

例えば、長時間の会議の議事録や、数十ページにわたる調査レポートを読む時間を大幅に削減できます。また、大量のニュース記事や顧客からのフィードバックを瞬時に要約・分析することで、市場のトレンドや顧客ニーズを素早く把握し、意思決定のスピードと質を高めることができます。誰が実行しても一定レベルの品質の要約が得られるため、業務の属人化を防ぎ、組織全体の情報処理能力を底上げする効果も期待できるでしょう。

LLM要約の主要な手法3選

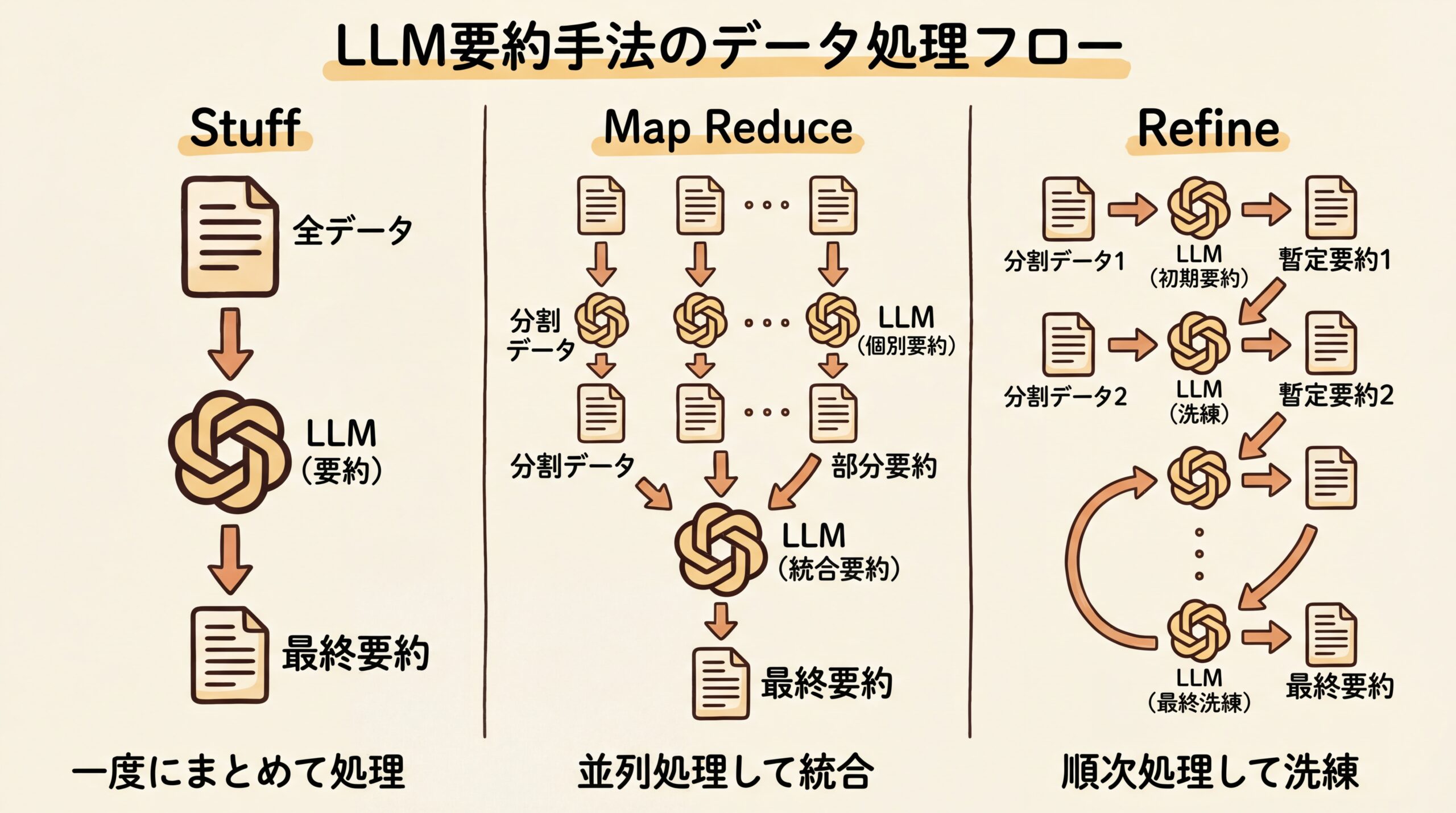

LLMで長文を要約する際には、モデルが一度に処理できるテキスト量(コンテキストウィンドウ)の制限が課題となります。この課題を解決するため、テキストを分割して効率的に処理する代表的な手法として、「Stuff」「Map Reduce」「Refine」の3つが広く用いられています。

これらの手法は、それぞれ処理方法と得意な場面が異なるため、目的に応じて使い分けることが重要です。ここでは、各手法の仕組みと特徴を解説します。

1. Stuff(スタッフィング)

Stuffは、要約したい文章の全体を一度にプロンプトへ入力する、最もシンプルで直接的な手法です。テキストを分割する必要がないため、実装が簡単で、文章全体の文脈を完全に保持したまま要約を生成できるという利点があります。

ただし、この手法が使えるのは、入力するテキスト全体の長さがLLMのコンテキストウィンドウ内に収まる場合のみです。近年のモデルではコンテキストウィンドウが大幅に拡大していますが、数万語を超えるような非常に長いドキュメントには適用できないという明確な限界があります。

2. Map Reduce(マップリデュース)

Map Reduceは、長文を扱うための非常に効果的な手法です。まず、元の長文テキストを、コンテキストウィンドウに収まるサイズの複数のチャンク(塊)に分割します。次に、各チャンクを個別にLLMに入力して、それぞれの要約を作成します(Mapフェーズ)。最後に、生成された各チャンクの要約をすべて結合し、それをさらにLLMに入力して最終的な一つの要約にまとめ上げます(Reduceフェーズ)。

この手法の最大の利点は、どれだけ長い文章でも原理的に処理が可能な点です。各チャンクの要約処理を並列化できるため、処理速度が速いことも特長です。一方で、チャンクを分割する際に文脈が途切れてしまい、チャンクをまたぐ重要な情報が失われる可能性があるというデメリットも存在します。(出典:Map reduce | 🦜️🔗 LangChain)

3. Refine(リファイン)

Refineは、文脈の連続性を重視した逐次的なアプローチです。まず、最初のチャンクを要約します。次に、その要約結果と2番目のチャンクを合わせてLLMに入力し、要約内容を更新(Refine)させます。このプロセスを最後のチャンクまで繰り返し、徐々に要約を洗練させていく手法です。

前のチャンクの情報を引き継ぎながら処理を進めるため、Map Reduceで起こりがちなチャンク間の文脈の断絶を防ぎやすいという大きなメリットがあります。しかし、処理を並列化できず、一つずつ順番に行う必要があるため、他の手法に比べて処理に時間がかかり、APIコストも高くなる傾向があります。

LLM要約の精度を高めるプロンプトのコツ

LLMによる要約の品質は、モデルに与える指示、すなわちプロンプトの設計に大きく左右されます。精度を高めるためには、何を、どのような形式で、誰のために要約してほしいのかを具体的かつ明確に伝えることが極めて重要です。

要約の精度を向上させるための、今日から実践できるプロンプトのコツをいくつか紹介します。

- 役割を与える:特定の専門家になりきらせることで、その視点に基づいた要約を生成させます。(例:「あなたは経験豊富な編集者です。」)

- 出力形式を指定する:箇条書き、段落数、文字数などを具体的に指定することで、望む形式の要約を得やすくなります。(例:「箇条書き3点で、それぞれ50字以内でまとめてください。」)

- 要約の焦点を指定する:文章のどの側面に注目してほしいかを明確に指示します。(例:「この記事の結論と、その根拠となるデータに焦点を当てて要約してください。」)

- 対象読者を設定する:誰に向けた要約なのかを伝えることで、専門用語の使用頻度や表現の平易さを調整させます。(例:「小学生にも理解できるように、専門用語を使わずに説明してください。」)

- 思考プロセスを促す:複雑な内容の場合、「ステップ・バイ・ステップで考えて」といった一文を加えることで、モデルが論理的に情報を整理し、より正確な要約を生成する助けとなります。

これらのコツを組み合わせることで、単に「要約して」と指示するのに比べ、格段に意図に沿った高品質なアウトプットを引き出すことが可能になります。

【実践】PythonとLangChainを使ったLLM要約の実装手順

LLM要約の仕組みを理解したら、実際にコードを書いて動かしてみましょう。ここでは、LLMアプリケーション開発のためのフレームワークである「LangChain」とPythonを用いて、LLM要約を実装する基本的な手順を紹介します。LangChainを利用することで、複雑な処理を比較的短いコードで実現できます。

今回は、長文要約で広く使われるMap Reduce手法を例に、具体的な実装の流れを見ていきます。

環境構築とデータ準備

まず、実装に必要なライブラリをインストールします。LangChainの基本的な機能に加え、OpenAIのモデルを利用するためのパッケージが必要です。ターミナルやコマンドプロンプトで以下のコマンドを実行してください。

pip install langchain langchain-openai openai tiktoken(出典:Summarization | 🦜️🔗 LangChain)

次に、プログラム内でOpenAIのAPIキーを設定します。【重要】APIキーを直接コードに書き込むことは、セキュリティ上非常に危険なため避けるべきです。代わりに、環境変数やシークレット管理サービスを利用して安全にキーを読み込むことを強く推奨します。(出典:Best Practices for API Key Safety | OpenAI Help Center) その上で、要約したいテキストデータをファイルから読み込むか、変数として直接定義して準備します。

Map Reduce手法による要約コード例

LangChainを使えば、Map Reduceのような複雑な要約プロセスも簡単に実装できます。以下は、テキストを分割し、Map Reduce手法で要約を実行するPythonコードのサンプルです。

最初に、必要なモジュールをインポートします。`ChatOpenAI`でモデルを指定し、`load_summarize_chain`で要約の処理チェーンを呼び出します。テキストの分割には`RecursiveCharacterTextSplitter`が便利です。

次に、LLMモデルのインスタンスを作成します。2025年11月にはOpenAIから「GPT-5.2」が、Googleから「Gemini 3」が発表されるなど、より高性能なモデルが利用可能になっています。 今回は例として、推論能力と速度のバランスが調整された`GPT-5.2`モデルを使用します。 続いて、`RecursiveCharacterTextSplitter`を使って、長いテキストを適切なサイズのチャンクに分割します。(出典:OpenAI chat | 🦜️🔗 LangChain)

最後に、`load_summarize_chain`を呼び出します。ここで`chain_type=”map_reduce”`と指定するのがポイントです。このチェーンに分割したテキスト(docs)を渡して実行するだけで、Map Reduce処理による要約結果を得られます。LangChainのバージョンによって記述方法が変更される可能性があるため、公式ドキュメントを併せてご確認ください。(出典:Summarize | LangChain)

このように、LangChainが提供する機能を活用することで、開発者はLLMとの複雑なやり取りを意識することなく、数行のコードで高度な要約機能を実装できます。

LLM要約のビジネス活用事例

LLMによる要約技術は、すでに多様なビジネスシーンで導入され、具体的な成果を上げています。その活用範囲は、日々の定型業務の効率化から、これまで見過ごされてきたデータからのインサイト抽出まで多岐にわたります。ここでは、AX CAMPの支援を通じてAI活用を実現した企業の事例を紹介します。

SNS運用時間を66%削減したC社の事例

SNSマーケティング・広告代理事業を手掛けるC社様は、SNS運用業務の属人化と、それに伴うインプレッション数の伸び悩みに課題を抱えていました。AX CAMPの導入を通じて、非エンジニアのみのチームでありながらSNSの完全自動化システムを内製化。この過程でLLMの要約技術などを活用し、トレンド情報の収集や投稿文の生成を効率化しました。結果として、1日3時間以上かかっていた運用業務をわずか1時間に短縮(66%削減)し、月間1,000万インプレッションという高い成果を達成しました。(出典:月間1,000万impを自動化!C社でAI活用が当たり前の文化になった背景とは?)

採用2名分の業務を代替したWISDOM合同会社の事例

SNS広告やショート動画制作を行うWISDOM合同会社様では、事業拡大に伴う人材採用コストと既存メンバーの業務負荷増大が課題となっていました。AX CAMPの研修でAIスキルを習得し、社内の様々な業務にAIを導入。特に、リサーチ業務や資料作成においてLLMの要約機能を活用し、情報収集の時間を大幅に短縮しました。この取り組みにより、新たに2名を採用した場合と同等の業務量をAIが代替することに成功し、コストを抑えながら生産性を大きく向上させました。(出典:【AX CAMP】WISDOM合同会社の導入事例)

全社で月100時間以上の業務を削減したエムスタイルジャパン社の事例

美容健康食品の製造販売を行うエムスタイルジャパン社様は、コールセンターの履歴確認や広告レポート作成といった手作業の多さに悩まされていました。AX CAMPの研修でGAS(Google Apps Script)とAIを連携させる技術を習得し、これらの定型業務の自動化に着手。特に、長文になりがちなコールセンターの応対履歴をLLMで要約・分類することで、確認作業が劇的に効率化されました。その結果、月間で16時間かかっていた業務がほぼ0時間になり、全社で月100時間以上の業務削減という大きな成果につながりました。(出典:月100時間以上の”ムダ業務”をカット!エムスタイルジャパン社が築いた「AIは当たり前文化」の軌跡)

LLM要約を利用する際の注意点と今後の展望【2026年最新】

LLMによる要約は非常に強力なツールですが、その特性を理解し、適切に利用することが重要です。特に、生成される情報の正確性(ファクト)と、入力するデータのセキュリティには細心の注意を払う必要があります。これらの注意点を押さえつつ、今後の技術的な展望も見据えていきましょう。

利用上の注意点(正確性・セキュリティ・ガバナンス)

LLMを利用する上で最も注意すべき点の一つが「ハルシネーション(Hallucination)」です。これは、AIが事実に基づかない情報や、もっともらしい嘘の内容を生成してしまう現象を指します。LLMは統計的にそれらしい単語を繋げて文章を生成する仕組みのため、情報の正誤を判断しているわけではありません。そのため、要約された内容は必ず元の情報と照らし合わせるなど、人間によるファクトチェックが不可欠です。

また、セキュリティ面も重要な考慮事項です。企業の機密情報や個人情報を外部のLLMサービスに入力する際は、情報漏洩のリスクを十分に理解し、対策を講じる必要があります。具体的には、データがAIの学習に利用されないかサービスの利用規約を確認し、入力データを匿名化するなどの対策が求められます。 安全性を最優先するなら、データが保護される法人向けサービスや、自社環境で運用するオンプレミス型の導入を検討することが重要です。

今後の展望(Gemini 3が拓くマルチモーダル・AIエージェントとの連携)

LLM技術の進化はテキストデータだけに留まりません。現在の開発競争の核となっているのが「マルチモーダル化」です。マルチモーダルAIは、テキストに加えて、画像、音声、動画といった複数の異なる種類のデータ(モーダル)を統合的に理解し、処理することができます。

2025年11月に発表されたGoogleの「Gemini 3」やOpenAIの「GPT-5.2」といった最新モデルは、このマルチモーダル性能を大幅に向上させています。 これにより、例えば会議の動画と資料を同時に読み込ませ、映像内のスライドの内容や発言者の表情、声のトーンまで含めて文脈を理解し、高精度な議事録を自動生成するといった活用が現実のものとなりつつあります。 パナソニックが開発した、映像から人物の感情や関係性をテキスト化する技術のように、AIが扱える情報の種類は急速に拡大しており、要約技術もより高度で複合的なものへと進化しています。(出典:世界初、映像情報から人の感情・関係性・行動目的をテキストで構造化する技術を開発 | Panasonic Newsroom Japan)

LLMの高度な活用やシステム開発ならAX CAMPへ

LLMによる要約技術の可能性を感じ、自社の業務プロセスに組み込みたいとお考えの方も多いのではないでしょうか。「特定のフォーマットで要約結果を出力したい」「社内データベースと連携させて、必要な情報だけを要約させたい」といった、より高度な活用を目指す場合、専門的な知識と開発スキルが必要になります。

しかし、AI人材の確保や育成は多くの企業にとって大きな課題です。AX CAMPは、そうした課題を解決するために設計された実践型の法人向けAI研修・伴走支援サービスです。単なる知識のインプットに留まらず、貴社の実際の業務課題をテーマに、手を動かしながらAIシステムのプロトタイプ開発まで行います。

経験豊富な専門家が伴走し、企画の壁打ちから技術的な実装サポートまで一貫して支援するため、AI活用の内製化に向けた確かな一歩を踏み出すことが可能です。この記事でご紹介したようなLLMの要約機能を自社システムに組み込むといった具体的なテーマにも対応できます。AIを活用した本格的な業務改革や、新たなサービス開発にご興味をお持ちでしたら、まずは無料相談にてお気軽にご相談ください。

まとめ:LLMによる要約を使いこなし、業務効率を最大化しよう

本記事では、LLMによる要約の仕組みから主要な手法、精度向上のコツ、そしてビジネスでの具体的な活用事例までを幅広く解説しました。最後に、重要なポイントを改めて振り返ります。

- LLM要約:AIが文脈を深く理解し、人間のように自然で質の高い要約を生成する技術。

- 主要な手法:長文を扱う際は、目的に応じて「Stuff」「Map Reduce」「Refine」などの手法を使い分ける。

- 精度の向上:プロンプトで役割や形式、焦点を具体的に指示することで、要約の品質は飛躍的に向上する。

- ビジネス活用:議事録作成、レポート分析、情報収集など、様々な業務の時間を大幅に短縮し、生産性を高める。

- 注意点:ハルシネーション(事実に基づかない情報の生成)や情報セキュリティのリスクを理解し、対策を講じることが不可欠。

LLMによる要約は、情報過多の現代において、ビジネスパーソンがより本質的な業務に集中するための強力な武器となります。この記事で紹介した知識や手法を活用し、日々の業務効率を最大化させましょう。

もし、自社への導入や、より高度なシステム開発、AI人材の育成に課題を感じている場合は、ぜひAX CAMPの活用をご検討ください。専門家の伴走支援のもと、貴社の課題に即したAI活用を現実のものとし、競合他社に先んじた業務改革を実現するお手伝いをします。