自社の機密情報を活用してAIの精度を高めたい、しかしクラウドサービスにデータをアップロードすることにはセキュリティ上の懸”念がある”。多くの企業が抱えるこのジレンマを解決するのが、LLM(大規模言語モデル)のオンプレミス導入です。オンプレミス環境であれば、外部にデータを出すことなく、自社の管理下で安全にAIを運用できます。

この記事を読めば、LLMをオンプレミスで導入するメリットや具体的な手順、さらには2026年最新のおすすめモデルまで、実践的な知識を網羅的に理解できます。セキュアなAI活用環境を構築し、ビジネスを加速させるための一歩を踏み出しましょう。AX CAMPでは、こうした専門的なAI導入に関するご相談も承っておりますので、お気軽にお問い合わせください。

LLMのオンプレミス導入とは?クラウドとの違いを解説

LLMのオンプレミス導入とは、自社が管理するサーバーやデータセンター内にLLMの実行環境を構築・運用する方式を指します。これに対して、インターネット経由で外部の事業者が提供するサーバー上のLLMを利用するのがクラウド型サービスです。両者の最も大きな違いは、モデルとデータがどこに存在し、誰が管理するかにあります。

オンプレミスでは物理的なハードウェアの調達からシステムの構築、保守・運用までをすべて自社で行う必要があります。(出典:オンプレミスとは|IDCフロンティア)一方、クラウド型はインフラの管理をサービス提供事業者に任せられるため、迅速に利用を開始できるのが特長です。この根本的な違いが、セキュリティやコスト、カスタマイズ性の考え方に大きく影響を及ぼします。

オンプレミスとクラウドの主な違い

オンプレミスとクラウドには、それぞれメリットとデメリットが存在します。特にセキュリティ、コスト、カスタマイズ性の観点から、どちらが自社のニーズに適しているかを慎重に判断する必要があります。以下の表で、両者の主な違いを整理しました。

| 項目 | オンプレミス | クラウド |

|---|---|---|

| セキュリティ | 非常に高い(閉域網で完結) | サービス提供事業者に依存 |

| カスタマイズ性 | 非常に高い(モデル改変・独自データ学習が自由) | 提供される範囲内に限定 |

| コスト構造 | 初期投資(ハードウェア費)が高額、ランニングコストは低い傾向 | 初期投資は低い、利用量に応じた従量課金が主 |

| 運用負荷 | 高い(自社で保守・管理、または外部委託) | 低い(事業者が保守・管理) |

| 導入スピード | 時間がかかる | 速い |

このように、オンプレミスは初期投資と運用負荷が大きいものの、セキュリティとカスタマイズ性を最大限に高められる点が大きな強みです。機密情報や個人情報など、外部に出せないデータを扱う企業にとって、オンプレミスは有力な選択肢となるでしょう。

なぜ今オンプレミスLLMが注目されるのか

近年、オンプレミスでLLMを導入する動きが活発化しています。その背景には、データプライバシーに対する意識の高まりと、高性能なオープンソースLLMの登場があります。多くの企業が、DX推進の鍵としてAI活用を掲げる一方で、情報漏洩リスクを深刻な経営課題と捉えています。

クラウドサービスを利用する場合、自社の重要なデータを外部のサーバーに預けることになり、情報漏洩の懸念が常に伴います。オンプレミスであれば、社内ネットワーク内で処理が完結するため、このリスクを根本的に排除できます。(出典:政府情報システムにおけるクラウドサービスの利用に係る基本方針)

また、Meta社の「Llama 3」やMicrosoft社の「Phi-3」など、商用利用可能で非常に高性能なオープンソースLLMが次々と公開されています。自社の業務に特化した独自のAIを、セキュアな環境で構築・運用したいというニーズの高まりが、今オンプレミスLLMが注目を集める最大の理由と言えます。

LLMをオンプレミスで導入する3つのメリット

LLMをオンプレミスで導入することには、「セキュリティの強化」「自由なカスタマイズ」「長期的なコスト管理」という主に3つの大きなメリットがあります。これらは、クラウドサービスでは得難い利点であり、企業の競争力を左右する重要な要素となり得ます。

特に、規制の厳しい業界や、独自のノウハウをAIに学習させたい企業にとって、オンプレミス導入は戦略的な一手となるでしょう。それぞれのメリットについて、具体的に見ていきます。

メリット1:高水準のセキュリティを確保できる

オンプレミス導入の最大のメリットは、極めて高いレベルのセキュリティを確保できる点です。社内の閉じたネットワーク内でLLMを運用するため、機密情報や顧客の個人情報といったセンシティブなデータを外部サーバーに送信する必要が一切ありません。これにより、外部からのサイバー攻撃や不正アクセスによる情報漏洩リスクを最小限に抑えることができます。(出典:【図解】オンプレミスとクラウドの違いとは?メリット・デメリット、移行のポイントも解説)

金融、医療、法務といった厳格なデータ管理が求められる業界や、製品の設計情報など企業の根幹に関わる情報を扱う製造業などでは、このセキュリティの高さが導入の決め手となります。クラウドサービスが提供するセキュリティ対策も年々向上していますが、自社の管理下で物理的にデータを保管できる安心感は、オンプレミスならではの強みです。

メリット2:自社データで自由にカスタマイズできる

自社の業務に合わせてLLMを自由にカスタマイズできることも、オンプレミスの大きな魅力です。オープンソースのLLMをベースに、社内に蓄積された独自のデータセット(過去の問い合わせ履歴、技術文書、議事録など)を追加学習させることで、業界や自社の専門用語に特化した高精度なAIを構築できます。

例えば、社内向けの問い合わせ対応チャットボットを開発する場合、自社の人事規定や経理マニュアルを学習させることで、従業員からの具体的な質問に対して的確に回答できるようになります。このような深いレベルでのカスタマイズは、汎用的なクラウドサービスでは困難です。自社の「暗黙知」をAIに継承させ、独自の競争優位性を築くことが可能になります。

メリット3:長期的なランニングコストを抑制できる

クラウド型のLLMサービスは、APIの利用回数や処理するデータ量に応じて課金される従量課金制が一般的です。そのため、利用が拡大すればするほど、ランニングコストが増大し続ける可能性があります。

一方でオンプレミスは、最初にGPUサーバーなどのハードウェア導入に高額な初期投資が必要ですが、一度環境を構築してしまえば、月々の利用料は発生しません。もちろん、電気代や保守・運用にかかる人件費はかかりますが、AIの利用頻度が高い企業にとっては、長期的に見てクラウドサービスよりも総コストを抑えられるケースが多くあります。(出典:オンプレミスとクラウドの違いとは?メリット・デメリットや移行のポイントを解説)将来的なコスト構造が予測しやすいため、予算計画を立てやすい点もメリットと言えるでしょう。

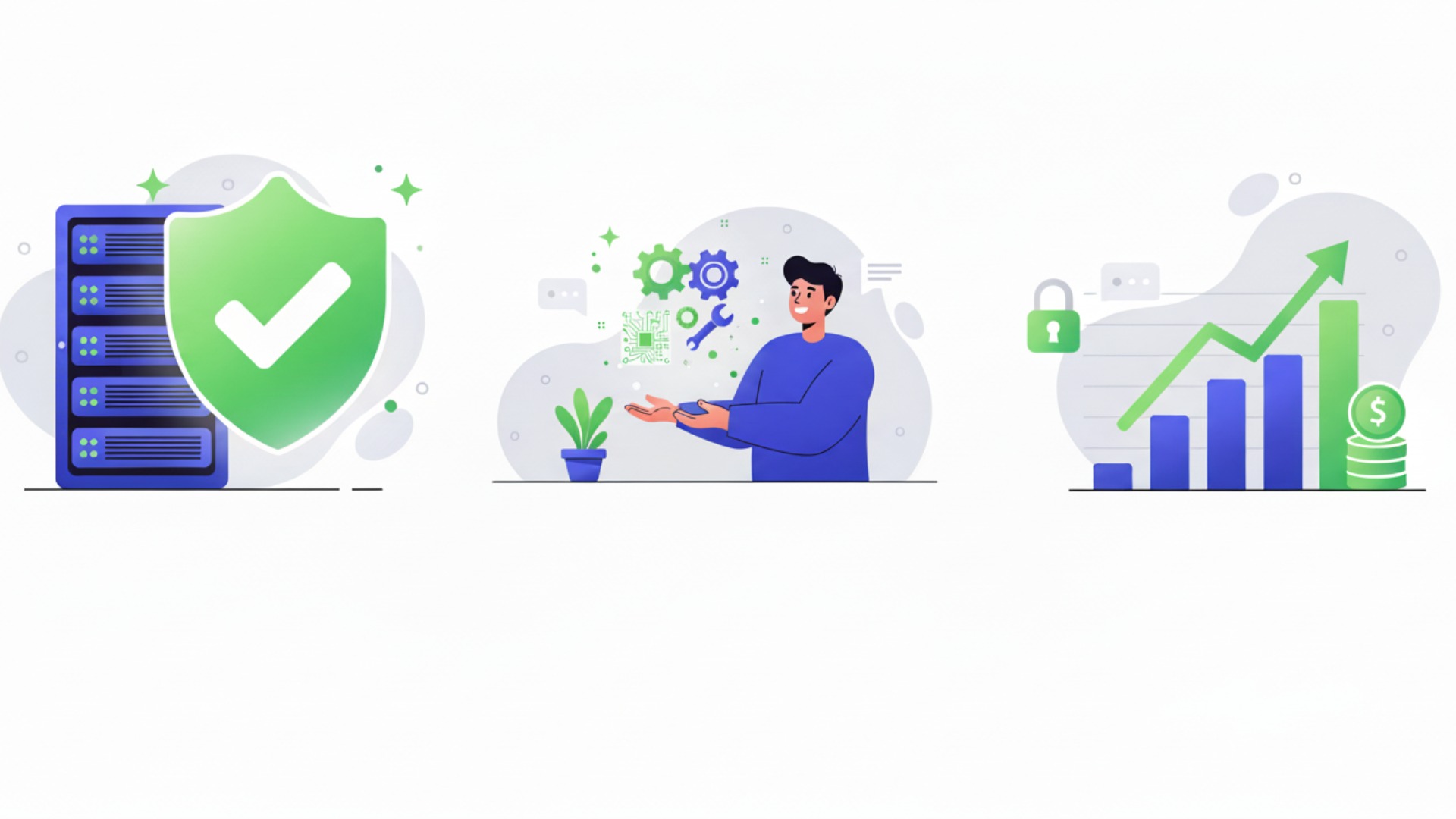

オンプレミスLLM導入における課題と対策

オンプレミスでのLLM導入は多くのメリットをもたらす一方で、「高額な初期投資」「専門人材の確保」「継続的な運用負荷」という3つの大きな課題も存在します。これらの課題を事前に理解し、適切な対策を講じることが、プロジェクト成功の鍵を握ります。

導入を検討する際には、メリットだけでなく、これらの現実的なハードルにも目を向け、自社で対応可能かしっかりと見極める必要があります。それぞれの課題と、その対策について解説します。

課題1:高性能なハードウェアへの初期投資

LLMを快適に動作させるには、高性能なGPU(Graphics Processing Unit)を搭載したサーバーが不可欠であり、その導入には多額の初期費用がかかります。 特に、数十億から数千億パラメータを持つ大規模なモデルを扱う場合、数百万円から数千万円規模の投資が必要になることも珍しくありません。

この課題への対策としては、まず導入目的とユースケースを明確にし、必要最小限のスペックから始める「スモールスタート」が有効です。全ての業務にいきなり最高性能のモデルを適用するのではなく、特定の部門やタスクに限定して比較的小規模なモデルから導入し、費用対効果を検証しながら段階的に拡張していくアプローチが推奨されます。また、ハードウェアの選定にあたっては、専門家の助言を求めることも重要です。

課題2:専門知識を持つ人材の確保

オンプレミス環境の構築・運用には、LLMの知識だけでなく、サーバーやネットワーク、セキュリティに関する高度な専門知識を持つインフラエンジニアが不可欠です。モデルの選定、環境構築、パフォーマンスチューニング、トラブルシューティングなど、対応すべき業務は多岐にわたります。

しかし、こうしたスキルを持つ人材は市場全体で不足しており、採用や育成は容易ではありません。対策としては、外部の専門企業とのパートナーシップが考えられます。AI導入支援サービスなどを活用し、専門家のサポートを受けながら社内人材を育成していく方法が現実的です。AX CAMPのような実践的な研修プログラムを通じて、自社に必要なスキルセットを計画的に獲得していくことも有効な手段となります。

課題3:運用・保守の継続的な負荷

オンプレミス環境は、一度構築したら終わりではありません。ハードウェアのメンテナンス、OSやソフトウェアのアップデート、セキュリティパッチの適用、モデルの定期的な更新など、安定稼働を維持するためには継続的な運用・保守作業が発生します。これらは専門知識を要するだけでなく、相応の工数がかかるため、担当者の大きな負担となり得ます。

この運用負荷を軽減するためには、体制構築が重要です。担当者を一人に限定せず、複数名でチームを組み、業務を標準化・ドキュメント化して属人化を防ぐことが求められます。また、サーバーの監視やログ管理を自動化するツールを導入することも有効です。運用・保守にかかるコストや工数をあらかじめ計画に織り込み、持続可能な運用体制を設計することが不可欠です。

オンプレミスLLM導入を成功させるための準備

オンプレミスでのLLM導入を成功させるためには、技術的な構築作業に入る前の準備段階が極めて重要です。特に、「導入目的の明確化」と「適切なハードウェアの選定」という2つのステップを丁寧に進めることが、プロジェクトの成否を分けます。

「何となくAIを導入したい」といった曖昧な状態では、適切な投資判断ができず、期待した成果を得ることはできません。具体的なゴール設定と、それを実現するための現実的な計画が不可欠です。

導入目的と具体的なユースケースの明確化

まず最初に行うべきは、「LLMを導入して、どの業務の、どのような課題を解決したいのか」を具体的に定義することです。目的が明確になることで、必要となるLLMの規模や機能、そしてハードウェアのスペックがおのずと決まってきます。

例えば、以下のように具体的なユースケースを洗い出します。

- 社内問い合わせチャットボット

- 議事録要約

- ソースコード生成の補助

- 技術文書検索の精度向上

これらのユースケースごとに、期待する成果(例:問い合わせ対応工数を50%削減、ドキュメント作成時間を1時間→10分に短縮)を数値目標として設定することが理想です。目的が具体的であればあるほど、導入後の効果測定も容易になります。

必要なハードウェアスペック(GPU・メモリ)の選定

導入目的が明確になったら、次はその目的を達成するために必要なハードウェアを選定します。LLMの性能は、特にGPUのVRAM(ビデオメモリ)容量に大きく依存します。VRAMが不足すると、モデルを動作させることすらできません。

モデルの規模(パラメータ数)と必要となるVRAM容量の目安は以下の通りです。ただし、これはあくまで一般的な目安であり、量子化技術などによって要求スペックは変動します。(参考:【ローカルLLM】Ollamaを使ってMacBook ProでLlama 2を動かす)

| モデル規模(パラメータ数) | 推奨VRAM容量(目安) | 代表的なGPU |

|---|---|---|

| 7B(70億)クラス | 16GB以上 | NVIDIA RTX 4080, NVIDIA A4000 |

| 13B(130億)クラス | 24GB以上 | NVIDIA RTX 4090, NVIDIA RTX 6000 Ada Generation |

| 70B(700億)クラス | 48GB x 2枚以上 | NVIDIA L40S, NVIDIA A100, NVIDIA H100 |

CPUやメインメモリ(RAM)、ストレージ(高速なNVMe SSD推奨)も重要ですが、まずはLLMの頭脳となるGPUの選定が最優先です。どのモデルを動かしたいかによって必要なGPUが決まるため、ユースケースの明確化がいかに重要であるかがわかります。予算と性能のバランスを取りながら、最適なハードウェア構成を検討しましょう。

【2026年時点】オンプレミスで使えるおすすめLLM14選

本リストは2025年11月時点の情報です。LLMの開発は非常に速いため、最新の情報は各モデルの公式サイトでご確認ください。オンプレミスで利用できるオープンソースLLMは数多く存在し、それぞれに特徴があります。モデルを選定する際には「総合的な性能」「日本語への対応度」「リソース効率」といった観点から、自社の目的に合ったものを選ぶことが重要です。

ここでは、特に注目すべき14のモデルを3つのカテゴリに分けて紹介します。これらの情報を参考に、自社のユースケースに最適なモデルを見つけてください。

【性能重視】海外製の高機能オープンソースLLM

最高の性能を求める場合、海外のテック企業や研究機関が開発したモデルが第一候補となります。これらのモデルは、膨大なデータで学習されており、英語を中心とした様々なタスクで極めて高い能力を発揮します。

- Llama 3.1 (Meta)

- Mistral Large (Mistral AI)

- Command R+ (Cohere)

- Qwen 2 (Alibaba Cloud)

- Gemma 2 (9B/27B) (Google)

中でもMeta社のLlama 3ファミリーは、複数のパラメータサイズが公開されており、特に大規模なモデルは多くのベンチマークで最先端のクローズドモデルに匹敵する性能を示しています。(出典:Meta AIの基盤となる、オープンソースの最先端LLM「Llama 3」を発表) 汎用性が非常に高く、様々な用途で活躍が期待できる最有力モデルの一つです。

【日本語対応】国内開発や日本語に強いLLM

日本語のニュアンスや文化的背景を深く理解した応答が求められる業務では、国内で開発されたモデルや、日本語データで重点的に学習されたモデルが適しています。これらのモデルは、より自然で正確な日本語処理を実現します。

- ELYZA-japanese-Llama-3 (ELYZA)

- Swallow-MS (東京工業大学と産業技術総合研究所などの研究チーム)

- CyberAgentLM3 (サイバーエージェント)

- PLaMo-13B (Preferred Networks)

特にELYZA社が開発した「ELYZA-japanese-Llama-2-70b」は、日本語のベンチマーク評価において当時のGPT-5を上回るスコアを記録しており、日本語性能において世界トップクラスの実力を持っています。(出典:日本語LLMで最高性能を達成した「ELYZA-japanese-Llama-2-70b」を商用利用可能なライセンスで公開) カスタマーサポートなど、高品質な日本語対話が必須の場面で非常に有効です。

【効率・特化型】省リソースや特定業務向けのLLM

限られたハードウェアリソースでLLMを運用したい場合や、特定のタスクに特化したモデルが必要な場合には、軽量で高効率なモデルが選択肢となります。これらのモデルは「SLM(小規模言語モデル)」とも呼ばれます。

- Phi-3 (Microsoft)

- Gemma 2 (2B) (Google)

- Code Llama (Meta)

- DeepSeek Coder (DeepSeek AI)

- Japanese Stable LM (Stability AI)

Microsoft社のPhi-3は、パラメータ数が3.8B(mini)、7B(small)、14B(medium)と軽量ながら、サイズが2倍以上のモデルに匹敵する性能を持つコストパフォーマンスに優れたモデルです。(出典:Phi-3 のご紹介: パワフルな機能を備えた、費用対効果が高く、小規模な言語モデル) 特にスマートフォンなどのデバイス上での動作も想定されており、エッジAIとしての活用も期待されています。

オンプレミスLLMの基本的な構築・導入手順

オンプレミスでLLMを導入するプロセスは、大きく4つのステップに分けられます。それは「ハードウェアの準備」「モデルの準備」「推論サーバーの構築」「アプリケーションとの連携」です。各ステップで適切なツールを選び、設定を進めていく必要があります。

ここでは、代表的なツールを例に挙げながら、基本的な構築・導入手順の全体像を解説します。この流れを理解することで、自社での導入計画をより具体的にイメージできるでしょう。

Step1: ハードウェア環境のセットアップ

最初に、LLMを動作させるための物理的なサーバーを準備し、OSや必要なソフトウェアをインストールします。この段階が、すべての土台となります。

- サーバーの設置と配線:データセンターやサーバルームに物理マシンを設置します。

- OSのインストール:Linux(Ubuntu Serverなど)が一般的に利用されます。

- NVIDIAドライバのインストール:GPUを認識させ、性能を最大限に引き出すために必須です。

- CUDA Toolkitのインストール:GPU上で高速な並列処理を行うための開発環境です。

これらの設定が完了し、OSがGPUを正しく認識している状態になれば、ハードウェアの準備は完了です。特にドライバとCUDAのバージョン互換性には注意が必要です。(参考:GPUサーバー構築(NVIDIAドライバ、CUDA、cuDNN、Docker))

Step2: LLMモデルのダウンロードと配置

次に、利用したいオープンソースLLMのモデルデータをダウンロードし、サーバー上に配置します。モデルデータは、数GBから数百GBになることもあるため、高速なネットワーク環境と十分なストレージ容量が必要です。

モデルは主に「Hugging Face Hub」というAIモデルの共有プラットフォームからダウンロードするのが一般的です。(出典:Download files from the Hub)しかし、利用するモデルのライセンス(商用利用可否、改変・再配布条件など)を必ず確認し、コンプライアンスを遵守することが極めて重要です。必要に応じて、法務部門によるチェックを行うことを強く推奨します。

Step3: 推論サーバーの構築とAPI設定

ダウンロードしたモデルを実際に動かし、外部のアプリケーションから利用できるようにするための「推論サーバー」を構築します。このサーバーが、テキスト生成などのリクエストを受け付け、LLMに処理させて結果を返す役割を担います。

推論サーバーを効率的に構築・運用するためのフレームワークとして、以下のようなツールがよく利用されます。(参考:GPUサーバー構築(NVIDIAドライバ、CUDA、cuDNN、Docker))各ツールは用途や前提条件が異なるため、目的に応じて選択することが重要です。

- vLLM:メモリ効率を重視したサーバー向け。高いスループットが求められる本番環境に適しています。

- Ollama:ローカルでの簡易実行向け。簡単なコマンドで導入でき、開発や検証フェーズで役立ちます。

- TensorRT-LLM (NVIDIA):NVIDIA製GPU環境専用。最高の推論速度を追求する場合に有効ですが、モデルの最適化・変換作業が必要です。

これらのツールを起動しAPIエンドポイントを公開しますが、その際は必ず適切なセキュリティ対策を講じる必要があります。具体的には、APIキーによる認証・認可の実装、通信のTLS/SSL暗号化、アクセスログの取得・保管、そして個人情報や機密情報の流出を防ぐための厳格なアクセス制御が不可欠です。

Step4: アプリケーションとの連携とテスト

最後に、構築した推論サーバーを自社の業務アプリケーションやチャットボットなどと連携させます。連携は、推論サーバーが提供するAPIを介して行います。

アプリケーション側からAPIにリクエスト(例:「”以下の文章を要約してください:…”」というテキストデータ)を送信すると、推論サーバーがLLMで要約を生成し、その結果をAPIのレスポンスとして返します。この一連の通信が正しく行われるかを確認し、様々な入力パターンでテストを繰り返して、応答の精度や速度を検証します。

この連携部分の開発を効率化するために、「LangChain」や「LlamaIndex」といったフレームワークが活用されることもあります。これらのツールを使うことで、より複雑なAIアプリケーションの開発を簡素化できます。十分なテストを経て、実運用に耐えうる品質であることを確認したら、導入は完了です。

LLMのオンプレミス導入ならAX CAMPへご相談ください

LLMのオンプレミス導入は、セキュリティやカスタマイズ性の面で大きなメリットがある一方、専門的な知識と技術が求められる複雑なプロジェクトです。「何から手をつければいいかわからない」「自社に最適なハードウェアやモデルが選べない」「導入後の運用体制に不安がある」といった課題を抱えている企業様も多いのではないでしょうか。

そのようなお悩みをお持ちでしたら、ぜひ一度、私たちAX CAMPにご相談ください。AX CAMPは、単なるAI研修を提供するだけでなく、お客様のビジネス課題に寄り添い、AIの戦略策定から導入、そして内製化までをトータルで支援する伴走型サービスです。これまで多くの企業のAI導入プロジェクトを成功に導いてきた実績豊富なコンサルタントが、貴社の状況を丁寧にヒアリングします。(参考:【2024年6月最新】LLM(大規模言語モデル)比較15選!料金・性能・選び方を徹底解説)

私たちは、特定のツールやモデルに固執することなく、中立的な立場で貴社の目的達成に最適な構成をご提案します。サービス提供にあたっては、守秘義務契約の締結はもちろん、成果物の範囲、料金体系、責任の所在について事前に契約書で明確に定めます。セキュアな環境で自社独自のAIを構築し、競争優位性を確立するための第一歩を、私たちと一緒に踏み出しませんか。まずは無料相談(現状の課題整理と、解決の方向性に関するご提案)にて、お気軽にお話をお聞かせください。

まとめ:LLM オンプレ導入でセキュアなAI活用を実現

本記事では、LLMのオンプレミス導入について、クラウドとの違いからメリット、課題、具体的な構築手順、そしておすすめのモデルまでを網羅的に解説しました。改めて、重要なポイントを振り返ります。

- オンプレミスの最大の利点:高いセキュリティと自由なカスタマイズ性

- 導入時の主な課題:初期投資、専門人材の確保、運用負荷

- 成功の鍵:導入目的の明確化と適切なハードウェア選定

- モデル選定の観点:性能、日本語対応、リソース効率を総合的に判断

- 構築のステップ:ハードウェア準備→モデル配置→推論サーバー構築→アプリ連携

オンプレミスでのLLM導入は、自社の貴重なデータ資産を外部に出すことなく、安全にAIを活用するための最も確実な方法の一つです。初期投資や専門知識といったハードルはありますが、それを乗り越えることで得られる競争優位性は計り知れません。自社の業務に特化した独自のAIを育てることは、他社には真似できない強力な武器となります。

もし、この記事を読んで「自社でも挑戦してみたいが、何から始めればよいか不安だ」と感じられたなら、ぜひAX CAMPの無料相談をご活用ください。貴社の課題に合わせた最適な導入プランをご提案し、プロジェクトの成功に向けて強力にサポートします。セキュアなAI環境を構築し、ビジネスの次なるステージへと進みましょう。