LLM(大規模言語モデル)を活用したテキスト分類の精度が上がらず、実務への導入に課題を感じていませんか。あるいは、従来の開発手法との違いが分からず、どこから手をつければ良いか悩んでいる方も多いかもしれません。LLMは、従来のモデルと異なり、少ないデータでも高い精度を発揮できるポテンシャルを秘めていますが、その能力を最大限に引き出すには特有のノウハウが必要です。

この記事では、LLMによる分類タスクの基本概念から、精度を最大化するための具体的な手法、そして最新のビジネス活用事例までを網羅的に解説します。読み終える頃には、自社の課題解決に向けたLLM分類タスクの実装プランを具体的に描けるようになっているでしょう。AI導入を検討中の方向けに、具体的な進め方がわかる資料もご用意していますので、ぜひご活用ください。

LLMによる分類タスクとは?基本概念と注目される背景

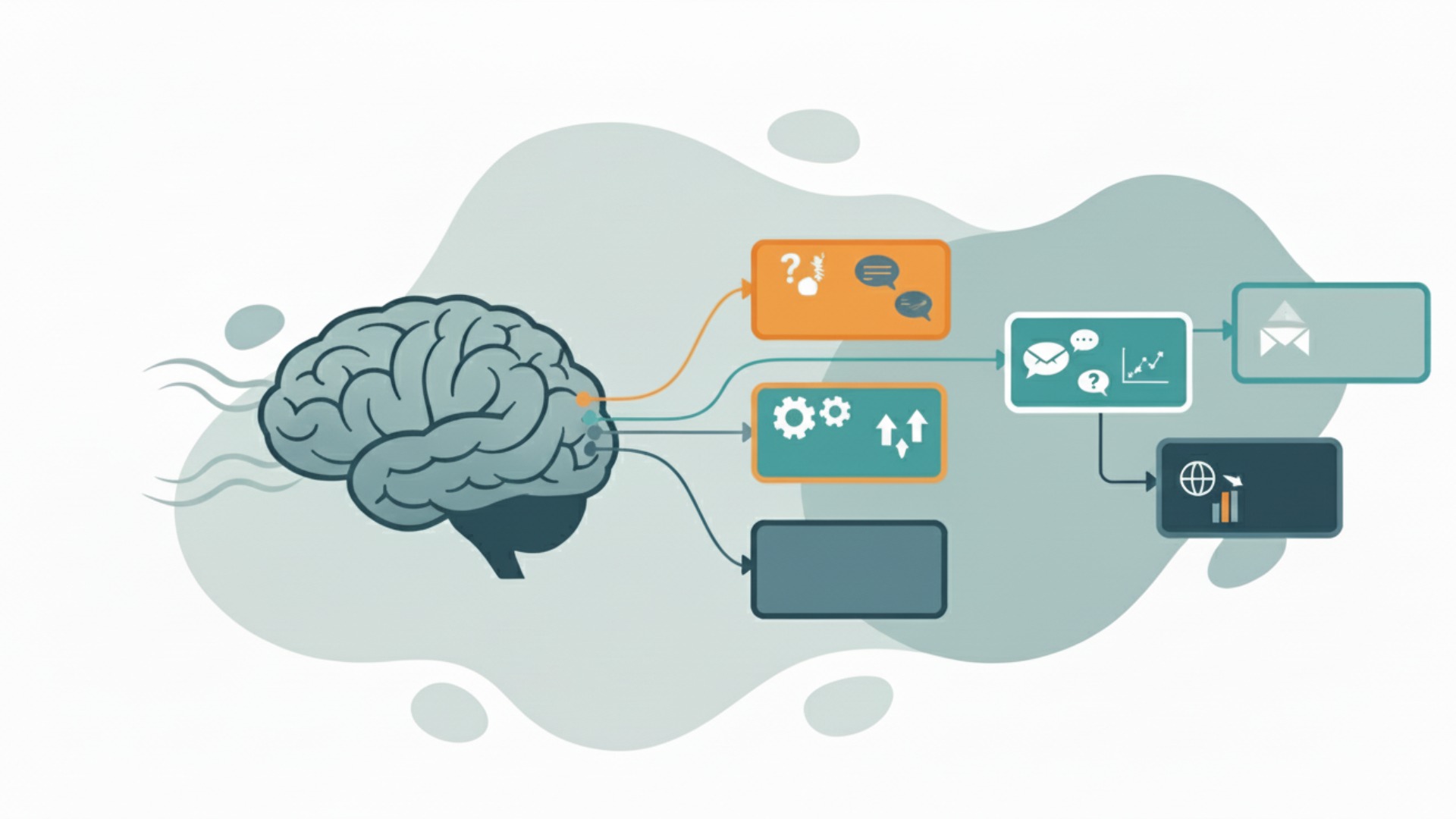

結論として、LLMによる分類タスクとは大規模言語モデルを用いて、テキストを事前に定義されたカテゴリへ自動で振り分ける技術です。例えば、顧客からの問い合わせメールを「質問」「要望」「クレーム」に分類したり、ニュース記事を「政治」「経済」「スポーツ」に仕分けたりする作業を自動化します。この技術が今、ビジネスの現場で大きな注目を集めています。

テキスト分類タスクの概要とビジネスにおける重要性

テキスト分類は、多くの企業にとって不可欠な業務の一つです。顧客フィードバックの分析、アンケート結果の集計、SNS投稿の感情分析、スパムメールの検出など、その用途は多岐にわたります。これらの業務を人手で行うと、膨大な時間とコストがかかるだけでなく、担当者による判断のばらつきも発生しかねません。

テキスト分類を自動化することで、業務効率を飛躍的に向上させ、より一貫性のあるデータ分析を実現できます。これにより、企業は顧客ニーズの迅速な把握やサービス品質の向上といった、より戦略的な活動にリソースを集中させられるようになるのです。

なぜ今、分類タスクにLLMが活用されるのか

これまでテキスト分類には、BERTなどの機械学習モデルが主に使われてきました。しかし、これらのモデルは特定のタスクごとに大量の教師データを用意し、ファインチューニング(追加学習)を行う必要がありました。このプロセスには、専門的な知識と多くの時間が求められたのが実情でした。

一方で、GPTシリーズやClaudeといった最新のLLMは、適切なプロンプト設計や条件次第で、多様な分類タスクで高い精度を発揮する場合があります。事前に膨大なテキストデータで学習しているため、文脈やニュアンスを深く理解する能力に長けています。この手軽さと汎用性の高さこそ、ビジネスシーンでLLMの活用が急速に広まっている大きな理由です。

https://media.a-x.inc/llm-text-classification従来の分類モデル(BERTなど)とLLMの違い

従来の分類モデルとLLMの最も大きな違いは、学習アプローチと汎用性にあります。BERTに代表される従来のモデルが特定のタスクに特化した「専門家」であるとすれば、LLMは多様なタスクを柔軟にこなせる「万能家」と表現できるでしょう。この違いを理解することが、適切なモデル選定の第一歩です。(出典:AIと機械学習の違いとは?LLMとの関連性やビジネス活用例を解説)

学習アプローチの違い:ファインチューニング主体からプロンプティングへ

従来のモデルで高い精度を出すには、そのタスク専用のラベル付きデータを数千〜数万件用意し、ファインチューニングを行うのが一般的でした。これは、モデルを特定の業務内容に最適化させるための重要な工程ですが、データ準備のコストが導入の大きな障壁となることがありました。(出典:大規模言語モデル(LLM)のファインチューニングについて)

対照的に、LLMはプロンプティングという手法を効果的に活用します。これは、モデルに対して自然言語で「この文章をポジティブかネガティブに分類してください」といった指示を与えるだけで、タスクを実行させるアプローチです。全く例を与えない「ゼロショット」や、数個の例を与える「フューショット」でも機能しますが、その性能はタスクやドメインに依存するため、実際の業務で利用する前には必ず評価が必要です。(出典:大規模言語モデル(LLM)は人間のように「メタ認知」を使って思考を修正できる)

性能と汎用性における比較

性能面では、特定タスクに特化して大量のデータでファインチューニングされた従来モデルが、LLMの汎用的な性能を上回るケースも依然として存在します。しかし、LLMは一つのモデルで分類、要約、翻訳、文章生成など、多岐にわたるタスクをこなせる圧倒的な汎用性を持ち合わせています。

以下の表は、両者の特徴をまとめたものです。

| 比較項目 | 従来の分類モデル(BERTなど) | LLM(GPTシリーズなど) |

|---|---|---|

| 学習アプローチ | ファインチューニングが主体 | プロンプティングが主体 |

| 必要なデータ量 | 多い(数千〜数万件) | 少ない(ゼロ〜数十件) |

| 汎用性 | 低い(特定タスクに特化) | 高い(多様なタスクに対応) |

| 導入の容易さ | 専門知識が必要 | 比較的容易 |

| 文脈理解能力 | 高い | 非常に高い |

ビジネスで多様なテキスト処理を迅速に試したい場合や、データ準備に大きなコストをかけられない状況では、LLMが非常に有力な選択肢となるでしょう。

LLMで分類タスクを実装する主要なアプローチ

LLMを用いてテキスト分類を実装するには、大きく分けて2つのアプローチが存在します。手軽に始められる「プロンプティング」と、特定のタスクで最高レベルの精度を目指す「ファインチューニング」です。それぞれの特性に加え、運用面の考慮事項も理解し、目的や予算に応じて最適な手法を選択することが重要です。(出典:AIのファインチューニングとは?仕組みやメリット・デメリット、LLMでの活用法を解説)

ゼロショット/フューショットプロンプティング

プロンプティングは、LLMに自然言語で指示を与えてタスクを実行させる最も基本的なアプローチです。特に、以下の2つの手法が頻繁に用いられます。

- ゼロショットプロンプティング:分類の例を一切示さず、指示だけを与える手法。「このメールを『重要』か『通常』に分類して」のように、最も手軽に試せます。

- フューショットプロンプティング:いくつかの分類例(ショット)をプロンプトに含める手法。モデルに手本を見せることで、より複雑なタスクや独自の分類基準にも対応しやすくなり、精度が向上します。

まずはゼロショットで試し、精度が不十分な場合にフューショットへと移行するのが効率的な進め方です。ただし、プロンプトが長くなるとコストや処理時間に影響するため、コンテキスト長の制約も意識する必要があります。

ファインチューニング(PEFT/LoRAなど)

ファインチューニングは、特定のドメインやタスクに特化した独自のデータセットを用いてLLMを追加学習させるアプローチです。これにより、汎用的なLLMを自社専用のモデルへとカスタマイズし、プロンプティングだけでは到達できない高い精度を目指せます。例えば、医療分野の専門用語や、法律業界特有の文書分類などで特に効果を発揮します。

かつては膨大な計算コストが課題でしたが、現在ではPEFT(Parameter-Efficient Fine-Tuning)やその一種であるLoRA(Low-Rank Adaptation)といった、計算資源を大幅に抑えながら効率的に追加学習を行う手法が主流です。これにより、以前よりも低コストで、かつ迅速にファインチューニングを実施できるようになりました。高精度が求められる領域では、外部の最新情報を参照するRAG(Retrieval-Augmented Generation)との併用も有効な選択肢となります。(出典:LoRA/PEFT:LLMのファインチューニングを効率化する手法)

【実践】LLMを用いた分類タスクの基本的な手順

LLMによる分類タスクの実装は、4つの主要なステップで進めることができます。目的設定から評価・改善までのサイクルを回すことで、継続的に精度を高めていくことが可能です。ここでは、その基本的な流れと、実運用で必須となるポイントを解説します。(出典:LLMの導入・開発支援(PoC)コンサルティング)

実装のステップは以下の通りです。

- 目的とカテゴリの定義

- データの準備

- モデル選定と実装

- 評価と改善

まず、「何を」「どのようなカテゴリに」分類したいのかを明確に定義します。例えば、「顧客からの問い合わせを、内容に応じて『料金プラン』『技術的な質問』『その他』の3つに分類する」といった具体的な目的を設定しましょう。カテゴリは、互いに重複せず、網羅的であることが理想です。

次に、分類対象となるテキストデータを準備します。フューショットプロンプティングやファインチューニングを行う場合は、正解ラベルが付与された少量のサンプルデータも用意してください。このデータの品質が、最終的な分類精度に大きく影響します。なお、個人情報や機密情報を含む場合は、事前に利用目的を明確にして本人同意を取得する、不要な個人情報は匿名化・マスキングする、データ保持期間とアクセス制御を設けるといった具体的な遵守策を講じてください。

続いて、タスクの要件に合ったLLMを選定します。OpenAIのGPTシリーズ、GoogleのGemini、AnthropicのClaudeなど、各モデルには得意な処理やコストが異なるため、比較検討が重要です。各ベンダーの利用規約・データ利用方針(学習への利用の可否、ログ保存、機密データの扱い)を確認し、必要に応じてプライベートデプロイやオンプレミス、データ匿名化等の対策を講じることが不可欠です。(出典:【2026年】GPT-5・Claude 4.5・Gemini 2.5の性能・料金を比較)

最後に、実装した分類モデルの性能を評価します。テストデータを用いて、正解率(Accuracy)や適合率(Precision)、再現率(Recall)といった客観的な指標で精度を測定します。期待した精度に達しない場合は、プロンプトの修正やデータの改善を繰り返します。本番環境では、モデルのバージョンを固定して性能の安定性を保ち、誤分類が発生した際に人間が介入する仕組み(ヒューマンインザループ)を組み込むなど、継続的な品質管理が成功の鍵となります。

https://media.a-x.inc/llm-implementationLLM分類タスクの精度を最大化する3つのポイント

LLMを用いた分類タスクで高い精度を実現するためには、いくつかの重要なポイントがあります。中でも、「効果的なプロンプト」「高品質な少数ショット」「データ品質の管理」の3点が特に重要です。これらの要素を最適化することで、LLMの能力を最大限に引き出せるようになります。(出典:LLMの精度を上げる“3つの問い”)

1. 効果的なプロンプトエンジニアリング

プロンプトは、LLMに対する指示書そのものです。精度を上げるためには、曖昧さをなくし、具体的で明確な指示を与えることが不可欠と言えます。例えば、単に「分類してください」と指示するのではなく、「あなたは熟練のカスタマーサポート担当者です。以下の問い合わせ内容を『緊急』『通常』『低』の3段階の優先度に分類し、JSON形式で理由とあわせて出力してください」のように、役割、タスク、出力形式を具体的に指定します。

このように、役割(ペルソナ)を与えたり、思考プロセスを段階的に示させたり(Chain of Thought)、出力形式を厳密に指定したりすることで、モデルの思考が安定し、分類精度が向上する傾向があります。

2. 高品質な少数ショット学習(Few-shot Learning)

フューショット学習で与える例の質は、精度に直結します。単にランダムな例を選ぶのではなく、戦略的に選定することが重要です。例えば、各カテゴリの典型的な例を含めることで、モデルはカテゴリの基本的な特徴を素早く学習できます。

さらに、カテゴリの境界線上にあり、判断が難しい「判断に迷う境界線の例」を意図的に含めることも有効です。これにより、モデルはより微妙なニュアンスの違いを学習し、分類の精度を高められます。数個の高品質な例が、数百の低品質な例に勝ることも少なくありません。

3. データセットの拡張と品質管理

ファインチューニングを行う場合、データセットの品質が成功の鍵を握ります。データの量もさることながら、一貫性のある高品質なラベリングが極めて重要です。ラベル付けの基準が曖昧だったり、担当者によって判断がぶれたりすると、モデルは混乱し、性能が低下してしまいます。

また、データが特定の傾向に偏らないように注意も必要です。例えば、ポジティブな意見ばかりのデータで感情分析モデルを学習させると、ネガティブな意見を正しく分類できなくなる可能性があります。データの偏りをなくし、多様なサンプルを含めることで、未知のデータに対する汎化性能の高いモデルを構築できるのです。

https://media.a-x.inc/llm-finetune-dataset【2026年】LLM分類タスクの最新ビジネス活用事例

LLMによる分類タスクは、既に多くのビジネス現場で導入が進み、具体的な成果を上げています。顧客サポートの効率化から専門的な業務の自動化まで、その活用範囲は広がり続けています。ここでは、AX CAMPの支援を通じて成果を上げた企業の事例を3つ紹介します。

株式会社Route66様の事例

マーケティング支援を手掛ける株式会社Route66様では、コンテンツ制作における原稿執筆が大きな時間的コストとなっていました。AX CAMPの研修を通じてAIライティングツールを導入し、記事のトピック分類や構成案作成、本文執筆までを自動化する仕組みを構築。この結果、当該企業の事例では、特定業務において従来24時間以上を要した工程が、同社報告では最速で10秒相当の生成が確認されたとされています。これは、LLMがテキストの分類だけでなく、その後の生成タスクまで一貫して実行できることを示す好例と言えるでしょう。(出典:【AX CAMP】たった10秒で記事を生成!原稿執筆24時間→10秒を実現したAIライティングの裏側)

WISDOM合同会社様の事例

SNS広告やショート動画制作を行うWISDOM合同会社様は、事業拡大に伴う人材採用のコストと業務負荷に課題を抱えていました。LLMの活用により、応募者のレジュメをスキルや職種に応じて自動で分類・評価するシステムを導入。これにより、採用担当者のスクリーニング業務が大幅に効率化されました。最終的に、同社では、特定のスクリーニング業務において従来の担当者2名分に相当する工数削減が確認されました。(出典:【AX CAMP】採用コストをかけずに事業拡大!AI活用で2名分の業務を代替したWISDOM社の戦略)

株式会社エムスタイルジャパン様の事例

美容健康食品の製造販売を行う株式会社エムスタイルジャパン様では、コールセンターの応対履歴確認や、手作業での広告レポート作成に多くの時間を費やしていました。LLMとGAS(Google Apps Script)を連携させ、問い合わせ内容を自動でカテゴリ分類し、要約するシステムを構築。これにより、従来は月に16時間かかっていた履歴確認業務がほぼゼロになりました。全社的には月100時間以上の業務削減を達成し、従業員がより付加価値の高い業務に集中できる環境を実現しました。(出典:月100時間以上の“ムダ業務”をカット!エムスタイルジャパン社が築いた「AIは当たり前文化」の軌跡)

https://media.a-x.inc/llm-use-casesLLMのビジネス活用ならAX CAMPのAI研修へ

LLMをビジネスに活用し、業務効率を飛躍させたいとお考えなら、実践的なスキルが身につくAX CAMPのAI研修をご検討ください。多くの企業が直面する「何から手をつければ良いかわからない」「自社に合う活用法が見つからない」といった初期段階の課題を解決するために設計された、実践型の法人向け研修サービスです。

AX CAMPの最大の特長は、単なる知識のインプットに留まらない、実務直結のカリキュラムにあります。貴社の具体的な業務課題をヒアリングし、それに合わせてカスタマイズされた研修プログラムをご提供。プロンプトエンジニアリングの基礎から、APIを活用した業務自動化システムの構築まで、ハンズオン形式で実践的に学ぶことができます。

さらに、研修後も専門家による伴走サポートが受けられるため、学習したスキルを確実に現場で活かし、成果につなげることが可能です。「AIを導入したが、使いこなせずに形骸化してしまった」という失敗を避けたい企業様に最適です。自社でLLMを使いこなし、競争力を高めたいとお考えの担当者様は、ぜひ一度、無料相談にお申し込みください。貴社の可能性を最大限に引き出すお手伝いをいたします。

まとめ:LLMによる分類タスクで業務の自動化と高度化を実現しよう

本記事では、LLMを用いたテキスト分類タスクについて、その基本概念から実践的な精度向上テクニック、そして最新の企業事例までを網羅的に解説しました。LLMは、従来の機械学習モデルに比べて導入のハードルが低く、それでいて高い精度と汎用性を誇る非常に強力なツールです。

この記事の要点を以下にまとめます。

- LLMはテキスト分類を効率化し、業務を自動化する強力な技術です。

- 実装には手軽な「プロンプティング」と高度な「ファインチューニング」があります。

- 精度向上の鍵は、具体的で明確な「プロンプト」と高品質な「データ」が握ります。

- 顧客サポートから専門業務まで、多様なビジネスシーンで既に活用が進んでいます。

顧客からの問い合わせ対応、SNSの評判分析、社内文書の整理など、テキストデータが関わるあらゆる業務を自動化・高度化できる可能性があります。効果的なプロンプトエンジニアリングやフューショット学習といった手法を駆使することで、自社の特定のニーズに合わせた高精度な分類モデルを迅速に構築できるでしょう。

AX CAMPでは、この記事で紹介したようなLLMの活用法を、貴社の実務に落とし込むための具体的なノウハウを提供しています。専門家の支援を受けながら、AI導入による業務効率化を確実に実現したい方は、ぜひ下記の資料請求や無料相談をご活用ください。