ビジネスにおけるデータ活用が一般化する中で、「相関関係」だけでなく、より深い「因果関係」を理解したいというニーズが高まっています。しかし、真の因果関係を特定することは、専門家でさえ困難な課題でした。この状況を打破する可能性を秘めているのが、大規模言語モデル(LLM)です。LLMの登場により、これまで見過ごされてきたビジネスチャンスの発見や、より精度の高い意思決定が期待されています。

この記事では、2026年最新の研究動向を踏まえ、LLMが因果推論をどのように可能にするのか、その仕組みからビジネスへの応用事例、そして現時点での限界までを網羅的に解説します。本記事を読めば、LLMと因果推論の全体像を掴み、自社のデータ活用を一段階引き上げるためのヒントを得られるでしょう。AIの高度な活用方法や、具体的な業務への導入に関心のある方は、弊社AX CAMPが提供する「AI活用研修のサービス資料」もぜひご覧ください。貴社の課題解決に繋がる情報が見つかるはずです。

なぜ今「LLMと因果推論」が注目されるのか?

結論として、LLMと因果推論の組み合わせが注目される最大の理由は、企業の意思決定の質を根本から変えるポテンシャルを秘めているためです。現代のビジネスはデータに基づいて行われますが、その多くは「相関関係」の分析に留まっています。例えば、「広告Aの表示回数が増えると、商品の売上が増える」という相関は分かっても、それが本当に広告Aの効果なのか、別の要因が影響しているのかを区別するのは困難でした。

この「相関と因果の混同」は、誤ったビジネス判断に繋がりかねません。そこで因果推論は、「何が本当に原因で、何が結果なのか」を科学的に解明するアプローチです。LLMは、その膨大な知識と言語理解能力を活かすことで、従来は専門家が多大な時間を費やしていた因果関係の仮説立案や検証プロセスを大幅に効率化できると期待されています。これにより、データに基づいた、より確かなアクションへと繋げられるのです。

DX(デジタルトランスフォーメーション)が深化し、あらゆるビジネス活動がデータ化される現代において、データの表面的な関係性だけでなく、その裏にある因果メカニズムを解明することの重要性は増すばかりです。LLMは、そのための強力なツールとして、今まさに大きな注目を集めています。

https://media.a-x.inc/ai-data-analysis

https://media.a-x.inc/llm-prediction

そもそも因果推論とは?LLM登場以前の課題

因果推論とは、ある事象が別の事象を引き起こす「原因と結果」の関係性、すなわち因果関係を統計的なデータから推定するための分析手法群を指します。単に二つの事象が同時に起こることを示す相関関係とは明確に区別され、ビジネスや政策の効果を正しく測定するために不可欠な考え方です。

しかし、LLMが登場する以前、この因果推論を実務で活用するにはいくつかの大きなハードルが存在しました。これらの課題が、多くの企業にとって因果分析の導入を困難なものにしていたのです。

相関関係と因果関係の根本的な違い

相関関係と因果関係の違いを理解することは、因果推論の第一歩です。この二つはしばしば混同されますが、その意味は全く異なります。

相関関係とは、二つの事象が連動して変化する関係を指します。例えば、「夏の気温が上がると、アイスクリームの売上も上がる」という関係です。一方で、因果関係とは、一方の事象がもう一方の事象を直接引き起こす原因となっている関係を指します。「広告の出稿量を増やすと、ウェブサイトへのアクセス数が増える」などがこれにあたります。

有名な例に、「アイスクリームの売上」と「水難事故の発生件数」の間に見られる正の相関があります。データ上、両者は同時に増減しますが、「アイスクリームが売れると水難事故が増える」という因果関係はありません。この場合、「気温の上昇」という第三の因子(交絡因子)が両方の原因となっているのです。このように、相関関係があるからといって、そこに因果関係があるとは限りません。

従来の統計モデルにおける因果分析の難しさ

従来の統計学的な手法で因果関係を証明するには、ランダム化比較試験(RCT)が最も信頼性の高い方法とされてきました。これは、対象者をランダムに2つのグループに分け、一方にだけ施策(介入)を行い、その効果を比較する手法です。しかし、ビジネスの現場でRCTを実施するには、以下のような多くの困難が伴いました。

- コストと時間:大規模な実験には相応の予算と期間が必要となる。

- 倫理的な問題:特定の顧客グループを意図的に不利な条件に置くことが許されない場合がある。

- 実施環境の制約:外部要因を完全にコントロールできる環境を用意することが難しい。

上記のような課題が存在します。例えば、特定の顧客グループにだけ割引クーポンを配布し、その効果を測定するのは現実的ではない場合があります。また、分析には統計学の高度な専門知識が必要で、結果の解釈も容易ではありませんでした。さらに、データ上には現れない「交絡因子」の存在を見抜き、その影響を統計的に調整する必要があり、分析者の経験や知識に大きく依存する側面があったのです。

LLMは因果推論をどのように実行するのか?

LLMは、従来の統計モデルとは異なるアプローチで因果推論の課題に貢献します。その核となるのは、人間が持つ膨大な言語知識と文脈理解能力を疑似的に再現し、データだけでは捉えきれない変数間の関係性を推測する能力です。LLMは、特定の計算式に依存するのではなく、言語データに埋め込まれた因果構造を学習・利用することで、推論を支援します。

具体的には、LLMは複数のメカニズムを組み合わせて因果推論を支援します。これらは従来の手法を完全に置き換えるものではなく、むしろ分析プロセスを強化し、加速させる役割を担います。

膨大なテキストデータからの因果構造の学習

LLMは、インターネット上のテキスト、書籍、科学論文といった膨大なデータを学習しています。このデータの中には、「AがBの原因となる」「CによってDが引き起こされた」といった、因果関係を明示的・暗示的に示す無数の表現が含まれています。LLMはこれらの表現パターンを学習することで、テキストに埋め込まれた関係性をパラメータとして保持しており、研究ではこれを用いて因果関係の候補を抽出できることが示唆されています。(出典:科学研究費助成事業データベース)

LLMが明示的な知識グラフを内部に直接格納しているわけではありませんが、学習データに基づく分散表現の中から多くの関係情報を引き出すことはできます。例えば、「金融緩和」と「株価上昇」が特定の文脈で頻繁に原因と結果として記述されていれば、LLMはその因果の方向性を学習します。これにより、分析者が仮説を立てる際のたたき台を提供したり、想定外の因果関係の候補を提示したりできるのです。

反事実的推論(Counterfactual Reasoning)のシミュレーション

因果推論の核心的な問いの一つに、「もしAをしていなかったら、Bはどうなっていたか?」という反事実を考えることがあります。LLMは、その生成能力を活かして、この「もしも」の世界を言語ベースで描き出す、反事実シナリオの生成に活用できます。これを反事実的推論(Counterfactual Reasoning)と呼びます。

例えば、「昨年、この広告キャンペーンを実施しなかった場合、売上はどうなっていただろうか?」という問いに対し、LLMは仮説生成の参考となるシナリオを文章で生成できます。ただし、これらのシミュレーション結果はあくまで「仮説生成ツール」であり、確定的な因果推定や予測値ではありません。LLMの出力は仮説生成やシナリオ比較に有用ですが、統計的検証が不可欠である点は認識しておく必要があります。(出典:J-GLOBAL 科学技術総合リンクセンター)

因果グラフの自動生成と解釈支援

因果分析では、変数間の因果関係を矢印で結んだ「因果グラフ」の作成が有効です。従来、このグラフは専門家がドメイン知識に基づき手動で作成していましたが、非常に手間のかかる作業でした。LLMは、このプロセスを自動化、または強力に支援できます。

分析対象のデータや関連文献をLLMに入力することで、変数間の因果関係の仮説を抽出し、因果グラフの初期案を作成する支援ができます。しかし、得られたグラフはあくまで仮説であり、因果発見アルゴリズムや統計的検証、そして専門家のレビューを通じて検証・修正する必要があります。LLMは、生成されたグラフの各要素が何を意味し、どのような根拠に基づくかを自然言語で説明することもでき、分析プロセスの透明性と効率を向上させます。

https://media.a-x.inc/generative-ai-learning

https://media.a-x.inc/llm-inference

【2026年最新】LLMの因果推論に関する主要な研究動向

LLMと因果推論の融合は、AI研究の中でも特に活発な領域の一つです。2025年現在、その研究は単に既存のLLMを応用するだけでなく、因果推論の能力そのものを強化する方向へと進化しています。ここでは、注目すべき三つの主要な研究動向を紹介します。

これらの研究は、LLMが単なるテキスト生成ツールから、より高度な分析や意思決定を支援するパートナーへと進化していく未来を示唆しています。

CausalLM:因果関係に特化した言語モデルの登場

汎用的なLLMも一定の因果推論能力を持ちますが、その性能は学習データに存在するバイアスに影響されやすいという課題があります。この問題に対処するため、因果関係の識別や推定タスクに特化して設計・学習された「CausalLM」の研究が進んでいます。

これらのモデルは、テキスト中の相関関係と因果関係を示す表現をより正確に区別したり、与えられた状況から交絡因子を特定したりする能力が強化されています。将来的には、研究者が因果に関する問いを投げかけると、関連する文献を自動的に調査し、統計的根拠と共に因果関係の有無を回答するような、専門アシスタントとしての活用が期待できます。

マルチモーダルデータと因果推論の融合

現実世界の因果関係は、テキスト情報だけで完結することは稀です。例えば、工場の生産ラインにおける故障の原因を探るには、稼働ログ(テキスト)だけでなく、センサーデータ(数値)、監視カメラの映像(動画)など、多様な形式のデータを統合的に分析する必要があります。このような複数のモダリティ(種類)のデータを扱うのがマルチモーダルAIです。

最新の研究では、LLMを中核としたマルチモーダルモデルに因果推論の能力を組み込む試みが進められています。これにより、テキスト、画像、数値データなどを横断的に分析し、より複雑で現実に即した因果関係を解明できるようになると期待されています。例えば、医療分野で患者のレントゲン画像と電子カルテのテキスト情報を組み合わせて治療効果の因果関係を分析する、といった応用が考えられます。

LLMエージェントによる介入実験の自動化

因果関係を最も確実に見つける方法は、実際に「介入」してみることです。この介入実験(A/Bテストなど)のプロセス自体を、LLMに自律的に実行させる「LLMエージェント」の研究が注目を集めています。LLMエージェントとは、目標達成のために自ら計画を立て、ツールを使い、行動を起こすことができるAIプログラムです。

因果推論の文脈では、LLMエージェントが「ウェブサイトのボタンの色を変えればコンバージョン率が上がるのではないか?」といった仮説を自ら立案。次に、A/Bテストツールを操作して実験を設計・実行し、得られた結果を分析して因果効果を報告する、といった一連のタスクを自動化します。これにより、人間を介さずに高速で仮説検証サイクルを回し、継続的にサービスを改善していくことが可能になります。(出典:Microsoft、自動でタスクを遂行するAI「LLMエージェント」のフレームワークを発表)

https://media.a-x.inc/ai-new

https://media.a-x.inc/llm-multimodal

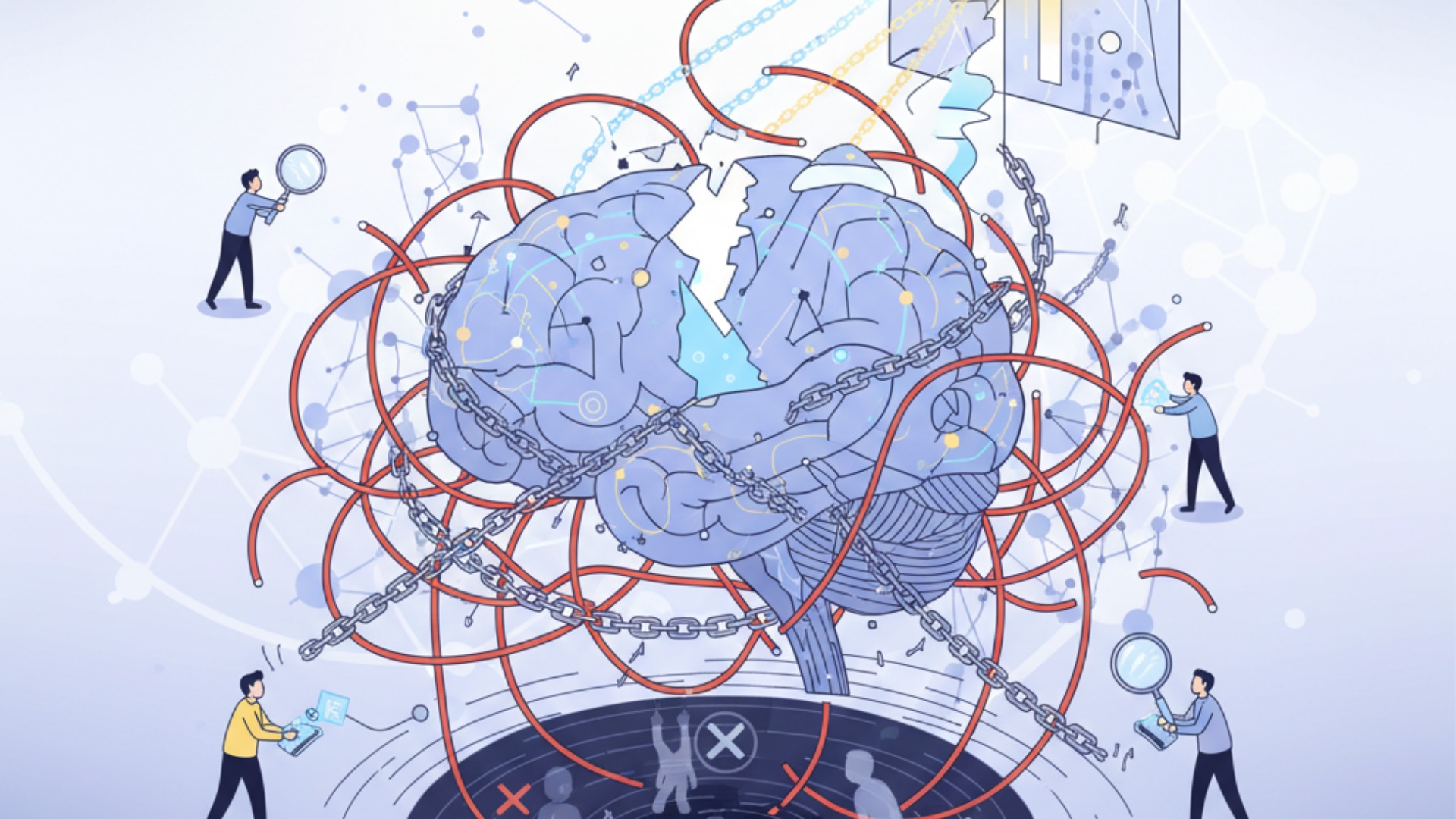

LLMによる因果推論の限界と乗り越えるべき課題

LLMは因果推論に新たな可能性をもたらす一方で、その能力には明確な限界と克服すべき課題が存在します。これらの課題を理解せずにLLMの分析結果を鵜呑みにすることは、誤った意思決定に繋がる危険性があります。技術のポテンシャルを最大限に活かすためには、その限界を正しく認識することが不可欠です。

主な課題は、学習データの質に由来する問題と、モデル内部の動作が不透明であるという二つの側面に大別されます。

「見せかけの相関」と「未知の交絡因子」の問題

LLMの知識は、あくまで学習データに基づいています。そのため、学習データ内に存在する「見せかけの相関」を、あたかも真の因果関係であるかのように学習してしまうリスクが常に伴います。例えば、特定の業界のニュース記事で「株価下落」と「CEOの交代」が頻繁に同時に報じられていた場合、LLMは両者に強い因果関係があると誤認する可能性があります。

さらに深刻なのは、学習データに全く含まれていない「未知の交絡因子」の問題です。前述のアイスクリームと水難事故の例で言えば、もし学習データに「気温」に関する情報が一切なければ、LLMがその交絡関係を見抜くことは原理的に不可能です。LLMはあくまでデータ内のパターンを学習するものであり、データを超えた世界の物理法則や社会構造を完全に理解しているわけではないのです。

推論プロセスのブラックボックス性と説明可能性の欠如

もう一つの大きな課題は、LLMがどのようにして結論に至ったのか、その推論プロセスが人間には理解しにくい「ブラックボックス」である点です。LLMはある問いに対して因果関係を示唆する回答を生成できますが、その回答がどのようなデータや内部パラメータの相互作用によって生まれたのかを正確に説明することは困難です。

この説明可能性(Explainability)の欠如は、特に医療、金融、法務といった、判断の根拠が厳しく問われる領域での活用において大きな障壁となります。「AIがそう判断したからです」というだけでは、重大な意思決定の理由として不十分な場合が多いでしょう。推論プロセスの透明性を高め、人間がその妥当性を検証できるような仕組み(Explainable AI, XAI)の研究が、今後の普及に向けた重要な鍵となります。

https://media.a-x.inc/ai-limitations

https://media.a-x.inc/ai-hallucination

LLM因果推論のビジネス活用事例と応用分野

LLMによる因果推論は、まだ発展途上の技術ですが、すでに様々なビジネス分野での活用が期待され、実証実験が進められています。特に、顧客行動や市場の反応といった複雑な要因が絡み合う領域において、その価値を発揮します。ここでは、代表的な活用事例と応用分野を紹介します。

これらの事例は、企業が「なぜ」を深く掘り下げ、より効果的な戦略を立案するためのヒントとなるでしょう。

マーケティング:広告効果測定と顧客行動の要因分析

マーケティングは、因果推論が最も効果を発揮する分野の一つです。どの広告が本当に購買に繋がったのかを分析する「アトリビューション分析」や、顧客がサービスを解約する真の理由を探る「チャーン分析」などが典型例です。LLMは、顧客レビューやSNSの投稿といった定性的なデータと、購買履歴などの定量的なデータを統合的に分析し、これまで見過ごされてきた顧客インサイトを発見する手助けをします。

例えば、広告運用を手掛けるグラシズ様では、AI活用によってLP制作を内製化。これにより、どのキャッチコピーやデザインがコンバージョンに繋がるかという仮説検証を高速で回せるようになりました。結果として、月額10万円かかっていたLPライティング外注費を0円に、制作時間も3営業日から2時間に短縮することに成功しています。(出典:AI(人工知能)の種類をわかりやすく解説!それぞれの仕組み・活用事例も紹介)

業務効率化:ボトルネックの特定と生産性向上

業務プロセスのボトルネックを特定し、改善するという観点でもAIは有効です。美容健康食品を扱うエムスタイルジャパン様では、コールセンターでの過去の対応履歴確認や、手作業での広告レポート作成に多くの時間を費やしていました。AIとGAS(Google Apps Script)を導入し、これらの定型業務を自動化。その結果、月間16時間かかっていた確認業務がほぼゼロになるなど、全社で月100時間以上の業務削減を達成し、より創造的な業務に時間を割けるようになりました。(出典:AIで経理業務は効率化できるのか?メリットや効率化のポイントを解説)

また、組織全体の生産性向上という課題に対しても、AIによる原因分析と対策が有効です。WISDOM合同会社様では、事業拡大に伴う人材採用が課題となっていました。AI研修を通じて業務を棚卸し、どの部分を自動化すれば最もインパクトが大きいかを分析。結果、採用を検討していた2名分の業務をAIが完全に代替し、採用コストをかけずに生産性を向上させることに成功しました。(出典:【実践】AI導入ワークショップとは?進め方や成功のコツを解説)

https://media.a-x.inc/ai-use-case

https://media.a-x.inc/llm-marketing

LLMと因果推論の融合が拓く未来

LLMと因果推論の技術がさらに成熟し、融合していくことで、私たちの社会やビジネスは大きな変革を遂げる可能性があります。その未来像は、単なる業務効率化に留まらず、これまで人間だけでは到達できなかったレベルの意思決定や、新たな科学的発見を加速させるものです。AIが人間の専門家と協働する、新たな時代の幕開けと言えるでしょう。

例えば、政策立案の分野では、ある政策が経済や雇用に与える影響をシミュレーションする際の、補助的なツールとしての活用が期待されます。LLMはシナリオ作成の参考となる可能性を秘めていますが、その結果は必ず検証と専門家によるレビューが必要です。また、新薬開発などの研究分野では、膨大な論文から有望な仮説を抽出する支援が考えられますが、これも研究者が検証すべき実験の優先順位付けを助けるものであり、イノベーションのサイクルを加速させる一助となることが期待されています。

ビジネスの現場においては、リアルタイムに変動する市場データや顧客の反応をLLMが常に監視・分析し、「今、この瞬間に打つべき最善の一手」の仮説を因果関係の候補と共に提案する、高度な意思決定支援システムが現実のものとなるでしょう。これは、経験や勘に頼っていた部分をデータとAIが補強し、組織全体の判断精度を飛躍的に向上させる未来です。

LLMのビジネス活用や因果推論の導入ならAX CAMP

LLMを用いた因果推論のような高度なAI技術をビジネスで真に活用するためには、ツールの使い方を覚えるだけでは不十分です。その背景にある理論を理解し、自社の課題に合わせて応用する実践的なスキルが不可欠となります。しかし、多くの企業では「何から学べば良いか分からない」「理論倒れで実務に繋がらない」といった課題に直面しています。

本気でAI活用を推進し、ビジネス成果に繋げたいとお考えなら、AX CAMPの実践型AI研修をご検討ください。AX CAMPは、単なる知識の提供に留まらず、貴社の実務課題をテーマにしたカリキュラムを通じて、明日から使えるスキルを習得することに重点を置いています。因果推論のような高度なテーマについても、その基礎からビジネス応用までを体系的に学ぶことが可能です。

経験豊富な講師陣が、研修中はもちろん、研修後も伴走支援を行うため、自社だけでは解決が難しい専門的な課題にも対応できます。理論と実践の架け橋となるAX CAMPで、データに基づいた本質的な課題解決能力を身につけ、貴社のDXを加速させませんか。まずは、無料でダウンロードできる資料で、研修内容の詳細をご確認ください。

まとめ:LLMの因果推論は新たな分析の地平を切り拓く

本記事では、大規模言語モデル(LLM)と因果推論の融合について、その基本原理から最新の研究動向、ビジネスへの応用、そして限界までを解説しました。LLMは、データ分析の世界に革命をもたらし、単なる「相関」の発見から「因果」の解明へと、分析の次元を大きく引き上げる可能性を秘めています。

この記事の要点をまとめます。

- 因果と相関は別物:ビジネスの正しい意思決定には、両者の違いを理解することが不可欠。

- LLMのアプローチ:膨大な言語知識から因果構造を学習し、反事実的推論などで分析を支援する。

- 技術の進化:因果推論に特化したCausalLMや、LLMエージェントによる実験自動化など研究が活発化している。

- 限界の認識:見せかけの相関やブラックボックス性といった課題も存在し、結果の鵜呑みは危険。

- 広がる応用:マーケティングの効果測定から業務効率化、政策立案まで、多様な分野での活用が期待される。

LLMと因果推論は、データドリブンな意思決定を新たなレベルへと導く強力な組み合わせです。しかし、そのポテンシャルを最大限に引き出し、ビジネス成果に繋げるには、技術への深い理解と、それを使いこなすための実践的なスキルが求められます。もし貴社がAIを活用して本質的な課題解決を目指しているのであれば、専門家の支援を受けることが成功への近道です。

AX CAMPでは、貴社の状況に合わせた最適なAI導入プランのご提案から、実践的なスキルを習得するための研修まで、一気通貫でサポートしています。まずは無料相談にて、貴社が抱える課題をお聞かせください。