自社のサービスに大規模言語モデル(LLM)を組み込みたい、あるいは社内業務を効率化したいと考えたとき、避けては通れないのがAPIの選定です。しかし、

「どのモデルを選べば良いかわからない」

「料金体系が複雑でコストを計算しにくい」

といった悩みを抱える担当者は少なくありません。2025年現在、主要なLLMは性能向上と価格競争を繰り広げており、選択肢はかつてないほど多様化しています。この記事では、OpenAIのGPT-5、GoogleのGemini 2.5 Pro、AnthropicのClaude 4シリーズなど、主要なLLM APIの最新料金と性能を徹底比較します。各モデルの強みや最適な用途を理解し、自社の目的と予算に合ったAPIを選ぶための具体的なポイントを解説しますので、ぜひ最適なモデル選定にお役立てください。AI導入の具体的な進め方や研修について関心のある方は、弊社のAI導入支援実績をまとめた資料も併せてご活用ください。

- LLM APIとは?基本的な仕組みを解説

- LLM APIの主要な課金モデル

- LLM APIを選ぶ上で重要な比較ポイント5つ

- 【2026年最新】主要LLM API料金・性能比較一覧表

- OpenAI (GPT-5シリーズ) のAPI料金とモデル比較

- Google (Geminiシリーズ) のAPI料金とモデル比較

- Anthropic (Claude 4シリーズ) のAPI料金とモデル比較

- Microsoft Azure OpenAI Serviceの料金体系と特徴

- Amazon Bedrockで利用できるLLMと料金体系

- Cohere APIの料金と特徴

- X (Grok) APIの料金と特徴

- 【目的別】最適なLLM APIの選び方

- コストパフォーマンスで選ぶおすすめLLM API 3選

- 性能・精度重視で選ぶおすすめLLM API 3選

- オープンソースLLMをセルフホストする場合のコスト比較

- LLM APIの利用料金をシミュレーションする方法

- API利用コストを抑えるための実践的なテクニック

- LLM API利用時の注意点とセキュリティ対策

- LLM APIの最新トレンドと今後の展望【2026年版】

- LLM APIの導入・活用ならAX CAMPの研修がおすすめ

- まとめ:LLM APIの料金比較で自社に最適なモデルを選ぼう

LLM APIとは?基本的な仕組みを解説

結論として、LLM APIは専門的なインフラを自社で構築することなく、最先端のAI機能を手軽に利用するための接続口です。開発者は自身のアプリケーションからAPIを呼び出すだけで、文章生成、要約、翻訳、質問応答といった高度なタスクを実行できます。この仕組みによって、スタートアップから大企業まで、あらゆる組織がAI技術を迅速にサービスへ組み込めるようになりました。

API経由でLLMを利用するメリット

APIを利用する最大のメリットは、インフラの構築・運用にかかる莫大な手間とコストを大幅に削減できる点にあります。高性能なLLMを自社で運用する場合、巨大な計算能力を持つサーバーの確保や、モデルを常に最新に保つ専門人材が不可欠です。これには、巨額の初期投資と継続的な運用コストが発生します。

その点、APIを利用すれば、これらのインフラ管理はすべてサービス提供者が担います。開発者はAPIを呼び出すコードを書くだけで、常に最新かつ最高性能のモデルを利用できるのです。結果として、本来注力すべきアプリケーションの機能開発やユーザー体験の向上にリソースを集中させられます。

「トークン」の概念と料金計算への影響

LLM APIの料金を理解する上で、「トークン」という単位は避けて通れません。トークンとは、モデルがテキストを処理する際の最小単位であり、テキストはこのトークンに分割されてから処理されます。日本語の場合、ひらがな1文字が1〜2トークン、漢字1文字が2〜3トークンとして扱われることが一般的ですが、この数値はモデルの「トークナイザ」に依存するため変動します。

APIの利用料金は、このトークンの数に基づいて計算されるのが基本です。具体的には、APIに送信するテキスト(インプット)と、モデルが生成したテキスト(アウトプット)のそれぞれのトークン数に応じて課金されます。したがって、APIのコストを正確に見積もるには、tiktokenのようなツールで処理対象のテキストが何トークンに相当するのかを事前に計測することが極めて重要になります。

LLM APIの主要な課金モデル

LLM APIの料金体系は、主に3つのモデルに大別されます。それぞれの特徴を把握し、自社の利用頻度や予算計画に合ったモデルを選ぶことが、コストを最適化する上で不可欠です。ここでは、各課金モデルの仕組みと、どのようなケースに適しているかを解説します。

従量課金モデル(Pay-as-you-go)

従量課金は、APIを使用した分だけ料金が発生する、最も標準的なモデルです。具体的には、前述した「トークン」を単位として、インプットとアウトプットの量に応じた料金が計算されます。利用量が少ない初期段階ではコストを低く抑えられるため、新規サービスの開発時や、利用頻度に波がある場合に最適です。

ほとんどのプロバイダーがこのモデルを採用しており、手軽に始められる点が大きな魅力と言えます。ただし、サービスの成長に伴い利用量が急増するとコストも比例して増加するため、大規模な運用を見据える際は後述するコスト削減策の併用が欠かせません。

プロビジョンドスループットモデル

プロビジョンドスループットとは、あらかじめ一定の処理能力(スループット)を予約し、その対価として料金を支払うモデルです。月額や年額で契約することにより、一定量のリクエストを安定した速度で処理することが保証されます。このモデルは、Microsoft Azure OpenAI ServiceやAmazon Bedrockなどで提供されています。

このモデルは、常に大量のリクエストが発生する大規模な商用サービスや、安定した応答速度がビジネス要件となるシステムに適しています。従量課金と比較してトークンあたりの単価が割安になることが多く、利用量の予測が立てられるのであれば、大幅なコスト削減が期待できます。

月額固定・サブスクリプションモデル

一部のサービスでは、月額固定料金で規定量までのAPI利用が可能なサブスクリプションモデルも存在します。このモデル最大のメリットは、毎月のコストが固定されるため、予算管理が非常に容易になる点です。利用量の上限を超過した場合は、追加料金が発生するか、一時的に利用が制限される仕組みが一般的です。

毎月のAPIコール数や処理データ量がある程度一定で、予算を厳密に管理したい企業にとって有効な選択肢です。ただし、提供しているプロバイダーは限られるため、利用を検討しているモデルがこの料金体系に対応しているか事前の確認が必要です。

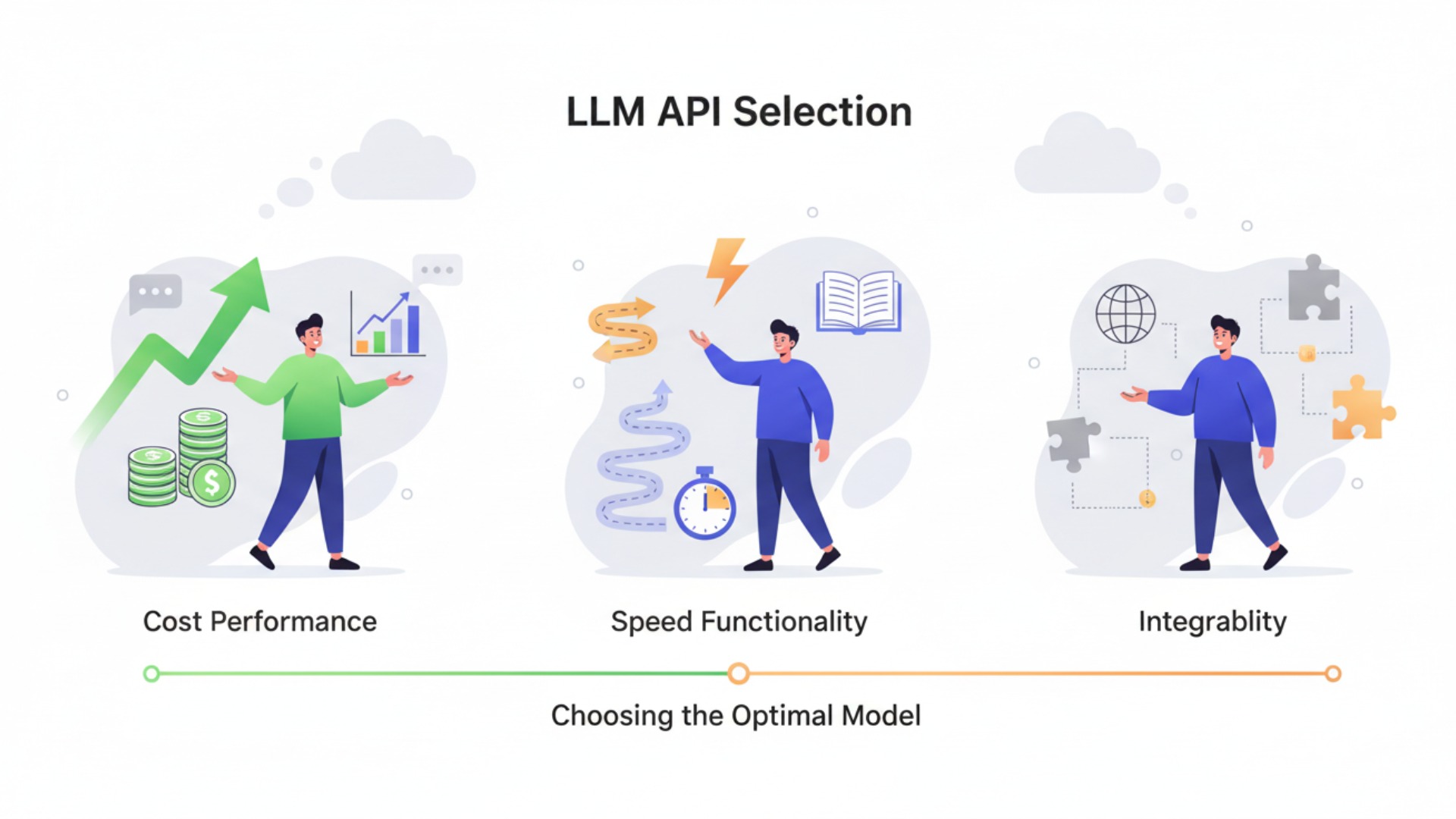

LLM APIを選ぶ上で重要な比較ポイント5つ

LLM APIを選定する際には、料金だけでなく、性能や機能、速度といった多角的な視点での比較が成功の鍵を握ります。自社のアプリケーション要件と照らし合わせ、最適なバランスを持つモデルを見極めることが重要です。ここでは、API選定で特に重視すべき5つの比較ポイントを具体的に解説します。

1. 料金(コストパフォーマンス)

料金は、API選定における最も重要な基準の一つです。比較する際は、100万トークンあたりの単価でインプット料金とアウトプット料金をそれぞれ確認するのが一般的です。多くの場合、文章を生成するアウトプットの方が、インプットよりも高く設定されている傾向にあります。(出典:ChatGPTのAPI料金で失敗しないためのチェックリスト)

しかし、表面的な単価だけで判断するのは早計です。安価なモデルでも性能が低ければ、望む結果を得るために何度もAPIを呼び出すことになり、結果的に高価なモデルよりコストがかさむ可能性があります。自社の用途で求める品質を担保できる性能と、料金のバランスが取れたモデルを選ぶ視点が不可欠です。料金情報は各社の公式サイトで確認することを推奨します。

2. 性能と精度

モデルの性能と精度は、アプリケーションの品質そのものに直結します。特に、複雑な文章の理解や生成、専門分野の要約、正確な情報に基づく応答が求められる場合、高性能なモデルの選択が必須です。各社が公開するベンチマークスコア(MMLU、GPQAなど)は客観的な比較材料になりますが、最終的には自社のユースケースで実際にテストし、精度を評価することが最も重要です。

例えば、創造性の高いテキスト生成にはOpenAIのGPT-5が、長文の読解や誠実な応答が求められるならAnthropicのClaudeシリーズが強みを発揮するなど、モデルごとに得意領域は異なります。目的に合ったモデルを選びましょう。

3. コンテキストウィンドウの長さ

コンテキストウィンドウとは、一度にモデルが処理できる情報の最大量(トークン数)を指します。このサイズが大きいほど、より長い文章や複雑な対話の文脈を保持したまま応答を生成できます。例えば、数万ページに及ぶ技術文書を読み込ませて質問応答させたり、長時間の会議録を一度に要約したりするタスクでは、巨大なコンテキストウィンドウが威力を発揮します。

2025年現在、主要モデルでは100万トークンを超えるコンテキストウィンドウも登場しており、これまで不可能だった大規模なデータ処理が可能になっています。(出典:Google Japan Blog: Gemini のアップデート、そしてデベロッパーと Google Cloud のお客様向けの新機能) 自社のアプリケーションが扱うデータ量を考慮し、十分な長さを持つモデルを選ぶことが重要です。

4. レスポンス速度(レイテンシ)

リアルタイムでの対話が求められるチャットボットや、迅速な応答がビジネス価値となるアプリケーションでは、レスポンス速度(レイテンシ)がユーザー体験を大きく左右します。APIを呼び出してから最初の応答が返ってくるまでの時間(Time-To-First-Token)や、1秒あたりに生成されるトークン数(Tokens-Per-Second)が主な指標です。

一般的に、モデルの規模が大きく高性能であるほど、レスポンス速度は遅くなる傾向にあります。そのため、速度が最優先される用途では、性能を少し抑えた軽量なモデル(例:GPT-5 nano, Gemini 2.5 Flash)を選択するのが賢明な判断です。多くのプロバイダーは、速度重視と性能重視のモデルを両方ラインナップしています。

5. マルチモーダル対応

マルチモーダルとは、テキストに加えて画像、音声、動画といった複数の種類のデータ(モダリティ)を統合的に処理できる能力のことです。この能力により、画像の内容を文章で説明させたり、動画の要約を生成させたり、音声で質問してテキストで回答を得たりといった高度な応用が可能になります。

特にGoogleのGeminiシリーズは、開発当初からマルチモーダルを前提に設計されており、この分野で非常に高い能力を示します。自社のサービスで画像や音声などの非テキストデータを活用したい場合、マルチモーダルへの対応可否は重要な選定基準となるでしょう。

【2026年最新】主要LLM API料金・性能比較一覧表

2025年10月現在、主要なLLM APIは性能向上と価格改定を絶えず続けています。ここでは、代表的なモデルの料金と主要スペックを一覧表にまとめました。(出典:【2024年5月】ChatGPT・Gemini・Claude・Copilotの料金を比較!結局どれが一番いい?)各モデルの特性を比較し、自社のニーズに最も合致するAPIを選定するための参考にしてください。

料金は、特に断りがない限り、100万トークンあたりの米ドル(USD)表記です。コンテキストウィンドウのサイズは、モデルが一度に処理できる情報量の上限を示しています。これらの数値を基に、コストと性能のバランスを慎重に検討することが重要です。

| モデルファミリー | 主要モデル名 | インプット料金 ($/1Mトークン) | アウトプット料金 ($/1Mトークン) | コンテキストウィンドウ | 提供元・出典 |

|---|---|---|---|---|---|

| OpenAI GPT-5 | GPT-5 | $1.25 | $10.00 | 12.8万トークン | OpenAI / Azure |

| GPT-5 mini | $0.25 | $2.00 | 12.8万トークン | OpenAI / Azure | |

| GPT-5 nano | $0.05 | $0.40 | 12.8万トークン | OpenAI / Azure | |

| Google Gemini | Gemini 2.5 Pro | $1.25 (≤200k) / $2.50 (>200k) | $10.00 (≤200k) / $15.00 (>200k) | 最大100万トークン (一部プレビュー) | |

| Gemini 2.5 Flash | $0.10 | $0.40 | 100万トークン | ||

| Anthropic Claude 4 | Claude Opus 4.1 | $15.00 | $75.00 | 最大20万トークン | Anthropic / AWS / Google |

| Claude Sonnet 4.5 | $3.00 | $15.00 | 最大20万トークン | Anthropic / AWS / Google | |

| Cohere | Command R+ | $2.50 – $3.00 | $10.00 – $15.00 | 12.8万トークン | Cohere / AWS / Azure等 |

| Command R | $0.50 | $1.50 | 12.8万トークン | Cohere / AWS / Azure等 | |

| X (Grok) | Grok 4 Fast | $0.20 (≤128k) / $0.40 (>128k) | $0.50 (≤128k) / $1.00 (>128k) | 最大200万トークン | xAI (直販API等) |

※上記の料金およびスペックは2025年10月15日時点の公式情報に基づいています。最新の情報は各社の公式ドキュメントを必ずご確認ください。提供プラットフォームやコンテキスト長、モデルのバージョンに応じて料金が変動するモデルが含まれます。

OpenAI (GPT-5シリーズ) のAPI料金とモデル比較

OpenAIは、LLM市場を牽引する存在であり、その最新モデルであるGPT-5シリーズは、多様なニーズに応える強力なラインナップを揃えています。性能、コスト、速度のバランスが異なる複数のモデルを提供しており、用途に応じて最適なものを選択できるのが強みです。また、Microsoft Azure OpenAI Serviceを通じても利用でき、エンタープライズ向けのセキュアな環境が提供されています。

フラッグシップモデルのGPT-5は、インプットが1.25ドル/1Mトークンという価格で、極めて高い推論能力と創造性を誇ります。コンテキストウィンドウは12.8万トークンで、多くのタスクに対応可能です。一方で、コストや速度を重視するユースケース向けに、GPT-5 miniやGPT-5 nanoといった軽量モデルも用意されています。特にGPT-5 nanoは、インプットが0.05ドル/1Mトークンと非常に安価で、簡単なタスクの自動化などに大きな費用対効果をもたらします。(出典:OpenAI Pricing)

Google (Geminiシリーズ) のAPI料金とモデル比較

GoogleのGeminiシリーズは、開発当初からマルチモーダルを前提に設計された、非常に汎用性の高いモデル群です。テキスト、画像、音声、動画を統合的に扱う能力に長けており、多様なデータ形式を扱うアプリケーション開発において強力な選択肢となります。その柔軟性は、他のモデルにはない独自の価値を提供します。

最上位モデルのGemini 2.5 Proは、最大100万トークンという広大なコンテキストウィンドウを持ちますが、この機能は一部プレビュー版での提供となる点に注意が必要です。(出典:Gemini Models – Google AI for Developers) 料金はOpenAIのGPT-5と同水準ですが、20万トークンを超える長文を扱う場合は料金が変動します。 一方、速度とコスト効率を重視したGemini 2.5 Flashは、同等のコンテキストウィンドウを維持しつつ、より安価な価格で提供されており、リアルタイム性が求められるチャットアプリケーションなどでその真価を発揮するでしょう。(出典:Gemini API pricing)

Anthropic (Claude 4シリーズ) のAPI料金とモデル比較

Anthropic社のClaudeシリーズは、高い安全性と信頼性、そして卓越した長文読解能力に定評があるモデルです。特に、ハルシネーション(もっともらしい嘘の情報を生成する現象)を抑制し、誠実な応答を返すように設計されている点が大きな特徴と言えます。Amazon BedrockやGoogle Cloud Vertex AIといった主要クラウドプラットフォームからも利用可能です。

最新フラッグシップモデルのClaude Opus 4.1は、業界最高水準の性能を誇りますが、その分料金はインプットが15ドル/1Mトークンと高価です。一方で、性能とコストのバランスに優れたClaude Sonnet 4.5は、インプットが3ドル/1Mトークンで提供されており、多くのビジネスユースで中心的な役割を担います。これらのモデルは最大20万トークンのコンテキストウィンドウを持ち、ミッションクリティカルな業務において高い信頼性を提供します。(出典:Anthropic Models)

Microsoft Azure OpenAI Serviceの料金体系と特徴

Microsoft Azure OpenAI Serviceは、OpenAIの強力なモデル群を、Microsoft Azureの堅牢なクラウドインフラ上で利用できるエンタープライズ向けサービスです。 Azureが提供する高度なセキュリティ、コンプライアンス、データプライバシー機能を活用できるため、特に大企業や機密情報を扱う組織にとって、第一の選択肢となり得ます。

料金体系は基本的にOpenAIの公式APIと連動していますが、Azure独自の課金モデルも提供されています。 代表的なものが「プロビジョンドスループット」であり、あらかじめ処理能力を確保することで、大規模なワークロードに対して安定したパフォーマンスとコストメリットを実現します。 さらに、24時間以内に処理を完了すればよい非同期タスク向けに、通常料金の最大50%割引が適用されるBatch APIも用意されており、コスト最適化の選択肢が豊富です。 ただし、この割引は対象モデルや利用リージョンに条件があるため、事前の確認が必要です。

Amazon Bedrockで利用できるLLMと料金体系

Amazon Bedrockは、Amazon Web Services (AWS) が提供する、主要な基盤モデル(FM)を単一のAPIで利用できるフルマネージドサービスです。 Amazon自身のTitanモデルに加え、AnthropicのClaude、Cohere、MetaのLlamaなど、サードパーティ製の高性能モデルを手軽に利用できる点が最大の魅力です。

料金体系は、利用するモデルや課金形態によって異なります。基本は、処理したトークン数に基づくオンデマンド(従量課金)ですが、安定したスループットが必要な場合にはプロビジョンドスループットを選択することも可能です。 これにより、開発者は特定のベンダーに縛られることなく、アプリケーションの要件に最も適したモデルを柔軟に選択し、コストを最適化できるのです。

Cohere APIの料金と特徴

Cohereは、特にエンタープライズ向けの検索・対話アプリケーションに強みを持つLLMプロバイダーです。高度な検索拡張生成(RAG)技術や、多言語対応、ファインチューニング機能が充実しており、企業の独自データと連携させた高精度なAIシステムの構築を得意としています。価格は、利用するホスティング環境(Cohere直販、AWS、Azure等)によって変動する点に留意が必要です。

主力モデルであるCommand R+は、3ドル/1Mトークン(インプット)で、高性能な対話・生成能力を提供します。一方、コストパフォーマンスに優れたCommand Rは、0.50ドル/1Mトークン(インプット)と非常に安価でありながら、多くのタスクで十分な性能を発揮します。また、検索結果の順序を最適化する「Rerank」や、テキストをベクトル化する「Embed」といった、特化した機能を持つAPIも提供しており、これらを組み合わせることで高度な検索システムを構築できます。

X (Grok) APIの料金と特徴

xAI社が開発するGrokは、リアルタイムの情報にアクセスし、ユーモアを交えた応答ができるというユニークな特徴を持つLLMです。ソーシャルメディアプラットフォームX(旧Twitter)の膨大なデータと連携しているため、最新のトレンドや話題に関する応答に特に優れています。

API料金は、高速モデルであるGrok 4 Fastが0.20ドル/1Mトークン(インプット、12.8万トークンまで)からと、非常に競争力のある価格設定になっています。さらに、200万トークンという非常に大きなコンテキストウィンドウも特徴の一つです。最新情報への迅速なアクセスや、ユーザーエンゲージメントを高めるためのユニークな対話AIを開発したい場合に、有力な選択肢となるでしょう。(出典:Grok-4 Fast Reasoning)

【目的別】最適なLLM APIの選び方

LLM APIの選定は、達成したい目的によって大きく異なります。コスト、性能、速度、機能といった要素を総合的に評価し、自社のプロジェクトに最適なモデルを見つけることが重要です。ここでは、代表的な3つの目的別に、APIの選び方の指針を示します。

まず、コストパフォーマンスを最優先するなら、OpenAIのGPT-5 nanoやGoogleのGemini 2.5 Flash、CohereのCommand Rなどが候補になります。これらのモデルは100万トークンあたりの単価が1ドル未満と安価でありながら、一般的なタスクをこなすには十分な性能を持ち、大量のテキストデータを処理する定型業務の自動化に最適です。

次に、最高の性能と精度を求めるのであれば、OpenAIのGPT-5やAnthropicのClaude Opus 4.1が筆頭に挙がります。これらのフラッグシップモデルは、複雑な推論や専門的な文章生成など、品質が最優先されるタスクでその能力を発揮します。料金は高価ですが、それに見合うだけの価値を提供してくれるでしょう。

最後に、リアルタイムの対話アプリケーションのようにレスポンス速度を重視するなら、Grok 4 FastやGemini 2.5 Flashのような軽量で高速なモデルが適しています。これらのモデルは、ユーザーの入力を待たせることなく、スムーズな対話体験を実現するためにチューニングされており、ユーザー体験の向上に大きく貢献します。

コストパフォーマンスで選ぶおすすめLLM API 3選

多くのビジネスユースにおいて、コストと性能のバランスは最も重要な選定基準となります。ここでは、手頃な価格でありながら高い実用性を持つ、コストパフォーマンスに優れたLLM APIを3つ厳選して紹介します。これらのモデルは、幅広い用途で安定した成果を期待できるため、LLM導入の第一歩として最適です。

1. Google Gemini 2.5 Flash

Gemini 2.5 Flashは、100万トークンという巨大なコンテキストウィンドウを持ちながら、インプット料金が0.10ドル/1Mトークンと非常に安価なモデルです。速度にも優れており、リアルタイム性が求められるアプリケーションにも対応可能です。マルチモーダル入力も可能なため、テキストだけでなく画像などを扱う幅広い用途で高いコストパフォーマンスを発揮します。(出典:Gemini API pricing)

2. Cohere Command R

CohereのCommand Rは、インプット料金が0.50ドル/1Mトークンという低価格ながら、ビジネスユースに特化した堅実な性能を提供します。特に、企業の内部データと連携させるRAG(検索拡張生成)の精度に定評があり、社内知識ベースを活用したチャットボットやドキュメント検索システムの構築に適しています。多言語対応も強みの一つです。

3. OpenAI GPT-5 nano

GPT-5 nanoは、フラッグシップモデルGPT-5の強力な性能を継承しつつ、価格を大幅に抑えたバランスの取れたモデルです。インプット料金は0.05ドル/1Mトークンと極めて手頃で、分類や要約といった多くのタスクで上位モデルに匹敵する品質の出力を得られます。OpenAIの豊富な開発者エコシステムやドキュメントを活用できる点も、開発を進める上で大きなメリットになります。(出典:OpenAI Pricing)

性能・精度重視で選ぶおすすめLLM API 3選

研究開発、専門的なコンテンツ作成、あるいは企業の根幹をなす業務の自動化など、品質に一切の妥協が許されないタスクには、最高性能のモデルを選択する必要があります。ここでは、2026年時点で業界をリードする、性能と精度を最優先する場合におすすめのLLM APIを3つ紹介します。

1. OpenAI GPT-5

GPT-5は、依然として汎用性と創造性において業界のベンチマークと見なされています。複雑な指示の理解、ニュアンスを捉えた文章生成、高度なプログラミング能力など、あらゆる面で卓越した性能を発揮します。料金はインプットが1.25ドル/1Mトークンですが、その価格に見合う高品質な結果が期待でき、多くの開発者にとって第一の選択肢であり続けています。(出典:OpenAI Pricing)

2. Anthropic Claude Opus 4.1

Claude Opus 4.1は、特に長文の読解・分析能力と、慎重で信頼性の高い応答生成において他の追随を許しません。膨大な量のドキュメントを読み込ませて要約させたり、複雑な契約書の内容について質問したりといったタスクに最適です。料金はインプットが15ドル/1Mトークンと高価ですが、その精度と信頼性はミッションクリティカルな業務において他に代えがたい価値を提供します。(出典:Anthropic Models)

3. Google Gemini 2.5 Pro

Gemini 2.5 Proは、マルチモーダル能力と巨大なコンテキストウィンドウを両立した高性能モデルです。テキストだけでなく、画像や音声を含む複雑な情報を統合的に理解し、高度な推論を実行できます。料金はGPT-5と同水準のインプットが1.25ドル/1Mトークン(20万トークンまで)で、特に複数のデータ形式を扱う最先端のアプリケーション開発において、その真価を発揮するでしょう。(出典:Gemini API pricing)

https://media.a-x.inc/llm-open-source

オープンソースLLMをセルフホストする場合のコスト比較

商用のAPIサービスを利用する代わりに、MetaのLlamaシリーズのようなオープンソースLLMを自社サーバー(オンプレミス)やクラウド上に展開(セルフホスト)する選択肢もあります。このアプローチの最大のメリットは、データのプライバシーを完全に自社でコントロールできる点と、利用量が増えてもAPI利用料がかからない点です。

しかし、セルフホストには相応のコストと専門知識が求められます。まず、高性能なLLMを快適に動作させるためには、ハイスペックなGPUを搭載したサーバーへの初期投資が不可欠です。例えば、GPUを1〜4枚搭載したサーバーの構築だけで数十万円から数百万円、さらにデータセンター費用や保守費用、運用を担当する専門人材の人件費も継続的に発生します。

API利用料と比較すると、短期的にはセルフホストの方が高コストになるケースが多いです。しかし、非常に大規模かつ継続的にLLMを利用する場合には、長期的にはAPI利用料を上回るコストメリットが生まれる可能性も秘めています。導入を検討する際は、総所有コスト(TCO)の観点から、ハードウェア費用、人件費、運用費を総合的に試算し、商用APIの利用料と比較検討することが重要です。

LLM APIの利用料金をシミュレーションする方法

LLM APIの導入を検討する際、事前にコストを正確に見積もることは、プロジェクトの予算策定において極めて重要です。料金シミュレーションを行うには、まず自社のユースケースにおける平均的なAPIコールあたりのトークン数を把握することから始めます。

具体的な手順は以下の通りです。

- 平均インプットトークン数の算出

- 平均アウトプットトークン数の算出

- 月間の想定APIコール数の設定

これらの数値を基に、以下の計算式で月額料金の概算を算出できます。

月額概算料金 = (平均インプットトークン数 × インプット単価 + 平均アウトプットトークン数 × アウトプット単価) × 月間コール数 / 1,000,000

例えば、あるチャットボットで、ユーザーからの入力が平均500トークン、AIの応答が平均300トークンで、月に10万回の対話が発生すると仮定します。GPT-5 mini(インプット$0.25/1M, アウトプット$2.00/1M)を利用する場合、月額料金は「(500 × $0.25 + 300 × $2.00) × 100,000 / 1,000,000 = $72.5」と計算できます。このように具体的な数値を当てはめることで、現実的なコスト感を持つことができます。(出典:OpenAI Pricing)

API利用コストを抑えるための実践的なテクニック

LLM APIの利用が本格化すると、コストの増大が課題となることがあります。しかし、いくつかの工夫を凝らすことで、品質を維持しながら利用料金を大幅に削減できます。ここでは、すぐに実践できる効果的なコスト削減テクニックを紹介します。

最も基本的かつ効果的なのは、タスクに応じて適切なモデルを使い分けることです。 例えば、メールの件名作成のような簡単なタスクにはGPT-5 nanoのような安価なモデルを使い、複雑なレポート作成にはGPT-5を使う、といった具合です。全てのタスクに最高性能のモデルを使う必要はありません。

また、APIに送信するプロンプトの工夫も重要です。冗長な表現を避け、簡潔で明確な指示を与えることで、インプットトークン数を削減できます。 さらに、Few-shotプロンプティングのように、いくつかの例を提示することで、モデルが意図を正確に理解し、短いアウトプットで済むように誘導することも有効です。その他、以下のテクニックも考えられます。

- レスポンスのキャッシュ活用

- リクエストのバッチ処理(Batch APIの利用)

- 出力トークン数の上限設定

これらのテクニックを組み合わせることで、APIコストを計画的に管理し、費用対効果を最大化することが可能になります。

LLM API利用時の注意点とセキュリティ対策

LLM APIを業務利用する際には、利便性の裏にあるリスクにも目を向ける必要があります。特に、情報漏洩とセキュリティは、企業が最も注意すべき点です。 APIを通じて機密情報や個人情報を送信する場合、そのデータがモデルの学習に利用されないか、あるいは通信経路で漏洩するリスクがないかを確認しなければなりません。

対策として、多くのAPIプロバイダーは、送信されたデータを学習に利用しないオプトアウト設定や、データ保持期間を定めたポリシーを用意しています。Microsoft Azure OpenAI ServiceやAmazon Bedrockのようなエンタープライズ向けサービスでは、閉域網接続やVPC(Virtual Private Cloud)内での利用など、より高度なセキュリティオプションが提供されています。これらの機能を活用し、自社のセキュリティポリシーに準拠した形でAPIを利用することが不可欠です。

また、プロンプトインジェクションのような、悪意のある入力によってモデルに意図しない動作をさせる攻撃にも注意が必要です。ユーザーからの入力をAPIに渡す際には、入力値をサニタイズ(無害化)するなどの対策を講じることが推奨されます。

LLM APIの最新トレンドと今後の展望【2026年版】

2025年のLLM API市場は、いくつかの重要なトレンドによって特徴づけられています。まず、モデルの性能向上と価格競争の激化です。各社が次々と高性能なモデルをリリースする一方で、既存モデルの価格を引き下げる動きが続いており、ユーザーはより手頃な価格で高性能なAIを利用できる環境が整いつつあります。

次に、コンテキストウィンドウのさらなる拡大が挙げられます。100万トークンを超えるコンテキストウィンドウが標準的になりつつあり、これにより一度に扱える情報量が飛躍的に増大しました。今後も、さらに巨大なデータセットを扱えるモデルの登場が期待されるでしょう。

また、特定タスクに特化した小規模モデルの台頭も注目すべき動きです。汎用的な大規模モデルだけでなく、特定の業界や業務にファインチューニングされた、軽量で高速なモデルの需要が高まっています。将来的には、これらの小規模モデルを自社のデバイス上で直接動作させる「オンデバイスAI」の流れも加速し、オフライン環境での利用や、より低遅延な処理が可能になると考えられます。

LLM APIの導入・活用ならAX CAMPの研修がおすすめ

LLM APIの選定や活用は、多くの企業にとって未知の領域であり、どのモデルをどう使えば業務改善につながるのか、判断が難しい場面も少なくありません。APIの技術的な仕様を理解するだけでなく、それを自社のビジネス課題と結びつけ、具体的なソリューションを企画・開発するスキルが求められます。

株式会社AXが提供する「AX CAMP」は、実務直結のスキル習得に特化した法人向けAI研修サービスです。本記事で解説したような各種LLM APIの特性を理解し、それらを活用して業務を自動化・効率化するための具体的な手法を、ハンズオン形式で学ぶことができます。単なる知識のインプットに留まらず、自社の課題をテーマにシステムを構築する実践的なカリキュラムが特徴です。

実際に、AX CAMPを導入した企業様からは、具体的な成果が報告されています。SNSマーケティング事業を手掛けるC社様では、非エンジニアチームがAIによるSNS投稿の完全自動化システムを内製化し、運用にかかる時間を1日3時間から1時間に短縮、月間1,000万インプレッションを達成しました。(出典:月間1,000万impを自動化!C社でAI活用が当たり前の文化になった背景とは?)

また、SNS広告を手掛けるWISDOM合同会社様では、AI活用によって採用予定だった2名分の業務を完全に自動化することに成功しています。さらに、美容健康食品を扱うエムスタイルジャパン様では、コールセンター業務や広告レポート作成を自動化し、全社で月100時間以上の業務削減を達成しました。(出典:月100時間以上の”ムダ業務”をカット!エムスタイルジャパン社が築いた「AIは当たり前文化」の軌跡)

※これらは個別の事例に基づく一例であり、すべての企業で同様の成果を保証するものではありません。

「どのAPIを選べば良いかわからない」「AIを導入したいが、社内に知見のある人材がいない」といった課題をお持ちでしたら、ぜひ一度、AX CAMPの導入をご検討ください。貴社の状況に合わせた最適なAI活用プランをご提案します。

まとめ:LLM APIの料金比較で自社に最適なモデルを選ぼう

本記事では、2026年最新の主要LLM APIについて、料金、性能、機能の観点から徹底的に比較・解説しました。OpenAI、Google、Anthropicといった主要プレイヤーは、それぞれ特徴の異なる多様なモデルを提供しており、自社の目的や予算に応じて最適なAPIを選択することが、AI活用の成否を分ける重要なポイントとなります。

LLM API選定の要点を以下にまとめます。

- 料金はトークン単位の従量課金が主流

- 目的(コスト、性能、速度)に応じてモデルを使い分ける

- コンテキストウィンドウの長さも重要な指標

- セキュリティや運用体制も考慮に入れる

最適なモデルを適切に導入・運用することで、業務効率の向上や新サービス創出の可能性が期待されます。ただし、その成果は導入目的の明確さや、運用体制に大きく依存することも忘れてはなりません。

もし、自社だけでLLM APIの導入や活用を進めることに不安を感じる場合は、専門家の支援を受けることをお勧めします。「AX CAMP」では、貴社のビジネス課題に寄り添い、最適なAPI選定から具体的な業務改善アプリケーションの開発までを伴走支援します。無料の個別相談も実施しておりますので、まずはお気軽にお問い合わせください。