LLM(大規模言語モデル)をビジネスで活用する上で、その出力が常に安全で信頼できるとは限りません。意図しない不適切な回答や誤った情報を生成するリスクがあり、どのように制御すればよいか悩む担当者は少なくないでしょう。この課題を解決する核心技術が

「LLMアライメント」です。この記事では、アライメントの基本的な仕組みから、2026年時点での最新の技術手法、そして今後の展望までを網羅的に解説します。読み終える頃には、LLMを安全に活用するための具体的な道筋が見えるはずです。AIの導入や活用に関する不明点を解消したい方は、当社のAX CAMPサービス資料もぜひご参照ください。

LLMアライメントとは?その重要性と目的

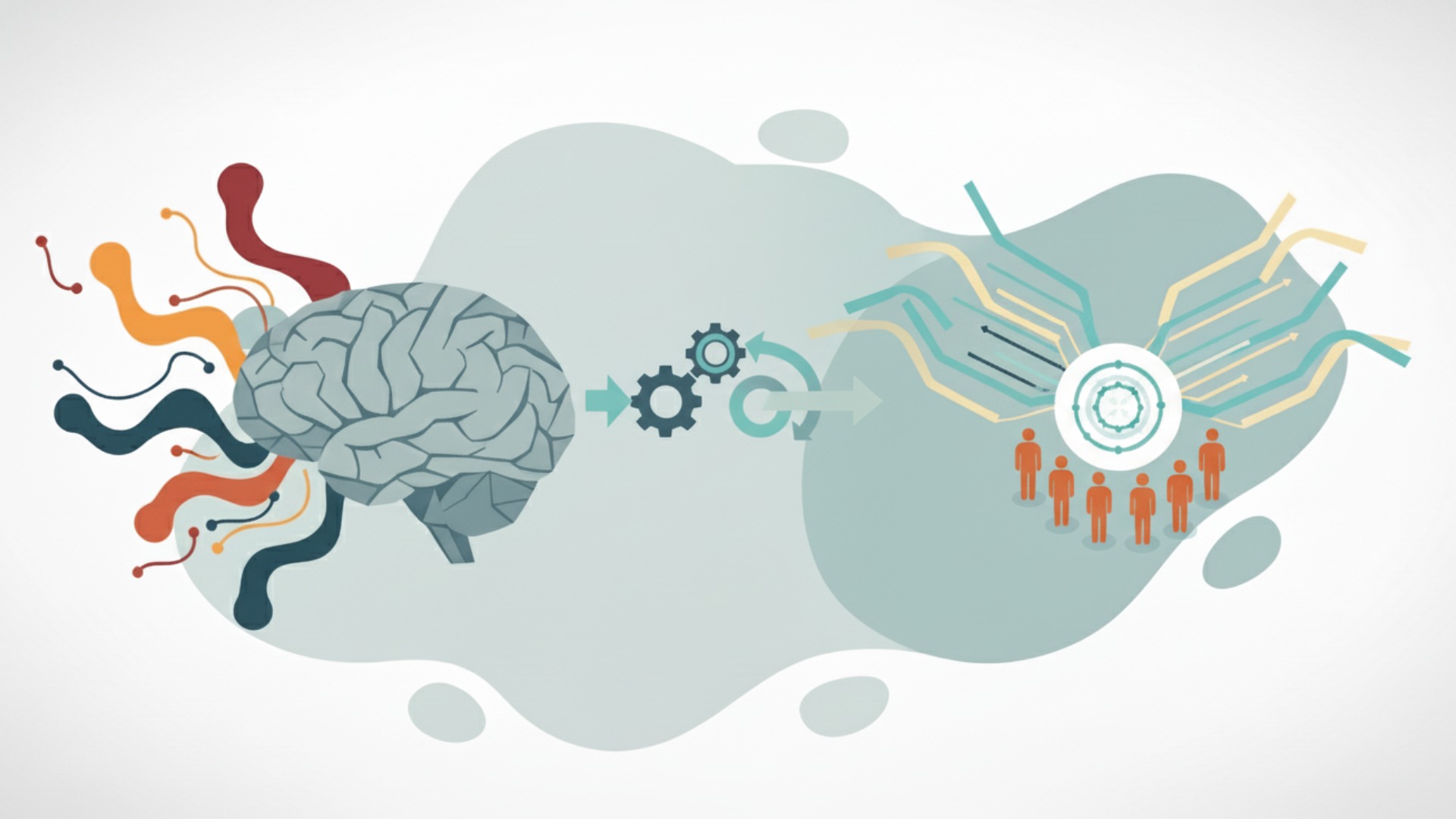

結論として、LLMアライメントとは、AIの応答を人間の意図や社会的な価値観に沿わせる(alignさせる)ための一連の技術やプロセスを指します。膨大なデータから学習しただけの「ベースモデル」は、時に人間にとって有害、不誠実、あるいは役に立たない回答を生成する可能性があります。アライメントは、こうしたAIの潜在的なリスクを抑制し、より安全で信頼性の高いツールにするために不可欠な工程なのです。

人間の意図や価値観にAIを一致させる技術

アライメントの具体的な目的は、LLMの出力を人間の期待に沿うように調整することです。これは、単にユーザーの命令に正確に従うだけでなく、その背景にある倫理観や社会規範を理解し、反映させることを含みます。例えば、差別的な表現を避けたり、危険な行為を助長するような情報提供を拒否したりする能力は、アライメントによって後天的に獲得されるものです。この技術により、LLMは単なる言語予測ツールから、人間と協調できるパートナーへと進化します。

なぜアライメントが必要なのか?AIの潜在的リスク

アライメントが施されていないLLMには、いくつかの重大なリスクが存在します。一つは「ハルシネーション(幻覚)」と呼ばれる、事実に基づかないもっともらしい嘘を生成してしまう問題です。また、学習データに含まれる偏見を増幅させ、差別的な内容を出力する「バイアス」のリスクも指摘されています。さらに、悪意のあるユーザーによって有害な目的で利用される可能性も無視できません。これらのリスクを低減し、企業がコンプライアンスを遵守しながらAIを活用するために、アライメントは必要不可欠な安全対策と言えるでしょう。

アライメントが目指す3つの原則「HHH」

LLMアライメントの指針として広く知られているのが「HHH(Helpful, Honest, Harmless)」という3つの原則です。これは、AIの応答が人間にとってどうあるべきかを示したもので、多くのAI開発企業がモデル調整の基準としています。

- Helpful(有益): ユーザーの要求を正確に理解し、的確で分かりやすい情報を提供する。

- Honest(正直): 事実に基づいた情報を提供し、不確かなことや知らないことは正直に認める。

- Harmless(無害): 差別的、暴力的、あるいは危険な内容を含まず、ユーザーや社会に害を与えない。

ビジネスでLLMを選定・活用する際には、この3つの観点からそのAIの安全性を評価することが重要です。これにより、自社の倫理基準に合致したAI運用が可能になります。

LLMアライメントがもたらす具体的なメリット

LLMアライメントは、AIの安全性を確保するだけでなく、その実用性を飛躍的に向上させるための重要なプロセスです。アライメントによってAIの応答が人間の価値観や意図に沿うようになることで、具体的にもたらされるメリットは多岐にわたります。

- ユーザー体験の向上: アライメントは、不正確、有害、あるいは文脈に沿わない不適切な回答を大幅に削減します。 これにより、ユーザーはより安心してAIとの対話に集中でき、知りたい情報を的確に得たり、目的のタスクをスムーズに完了させたりすることが可能になります。

- ビジネス活用の拡大: 企業にとって、アライメントはAI導入のリスクを低減し、活用の幅を広げる鍵となります。 例えば、カスタマーサポートに導入する際、不適切な発言でブランドイメージを損なうリスクを抑制できます。 また、コンプライアンスが重視される業界においても、信頼性の高いAIとして業務プロセスに組み込みやすくなります。

- 社会的な信頼性の構築: AIが倫理規範や社会通念を尊重した応答をすることで、技術に対する社会全体の信頼感が醸成されます。 これにより、教育や公共サービスといった、より繊細な配慮が求められる分野へのAI応用が進み、社会全体の利益に貢献することが期待されます。

このように、LLMアライメントがもたらすメリットは、単なるリスク回避に留まりません。AIをより信頼でき、役立つパートナーとして社会に統合していくための基盤となる技術なのです。

LLMにおけるアライメントの学習プロセス

LLMアライメントは、モデル開発の特定の段階で集中的に行われます。そのプロセスは、大きく分けて「事前学習」と「事後学習」の2つのフェーズに分けることができ、アライメントは主に後者で重要な役割を果たします。この流れを理解することで、アライメントがLLMの性能や安全性にどう影響を与えるかが見えてきます。

事前学習(Pre-training)との関係性

事前学習は、LLM開発の最初のステップです。インターネット上の膨大なテキストデータなどを使い、モデルに言語の基本的なパターンや文法、そして幅広い知識を学習させます。この段階では、特定の価値観を教え込むというよりは、言語そのものの仕組みを理解させることが主目的です。そのため、事前学習が完了しただけの「ベースモデル」は、知識は豊富ですが、人間社会のルールや倫理観を理解しているわけではありません。アライメントは、このベースモデルを人間にとってより望ましい形に調整するための次のステップとなります。

https://media.a-x.inc/llm-pretraining事後学習(Post-training)におけるアライメントの位置づけ

事後学習は、事前学習済みのモデルに対して行われる追加のトレーニングフェーズであり、アライメントはこの段階の中核をなします。ここでは、人間の手によって作成された質の高いデータセットや、人間のフィードバックを用いてモデルを微調整(ファインチューニング)します。具体的には、「教師ありファインチューニング(SFT)」で模範的な回答スタイルを学習させ、その後に「人間からのフィードバックによる強化学習(RLHF)」などで、より細かな人間の好みを反映させていきます。このプロセスを通じて、LLMはHHH原則に沿った応答を生成できるようになるのです。

LLMアライメントを実現する主要な技術手法

LLMを人間の価値観に沿わせるためには、いくつかの具体的な技術手法が用いられます。2025年現在、特に重要とされているのが「RLHF」「DPO」「憲法AI」の3つです。これらの手法はそれぞれ異なるアプローチを取りますが、いずれもAIの応答をより安全で有益なものにすることを目的としています。(出典:Large Language Models Alignment: A Survey)

人間からのフィードバック強化学習(RLHF)

RLHF(Reinforcement Learning from Human Feedback)は、近年のLLMの性能向上に大きく貢献した代表的なアライメント手法です。このプロセスは、大きく3つのステップで構成されます。

- 教師ありファインチューニング(SFT): まず、人間が作成した高品質なQ&Aデータでベースモデルを微調整し、指示に従う能力の基礎を身につけさせます。

- 報酬モデルの学習: 次に、同じ質問に対してモデルに複数の回答を生成させ、人間がその良し悪しをランク付けします。この「人間の好み」のデータを学習し、どのような回答が高い評価を得るかを予測する「報酬モデル」を構築します。

- 強化学習による最適化: 最後に、報酬モデルからのフィードバック(報酬)が最大になるように、強化学習(PPOなど)を用いてLLM本体をさらにファインチューニングします。

このRLHFにより、モデルは人間の主観的な「良さ」を理解し、それに沿った応答を生成するようになります。

https://media.a-x.inc/llm-reinforcement-learning直接的な嗜好の最適化(DPO)

DPO(Direct Preference Optimization)は、RLHFの複雑さを解消するために登場した新しい手法です。RLHFでは報酬モデルの学習と強化学習という2段階のプロセスが必要でしたが、DPOはこれらのステップを一つにまとめ、人間の選好データから直接LLMを最適化します。(出典:Direct Preference Optimization: Your Language Model is Secretly a Reward Model)

具体的には、人間が「良い」と判断した回答の生成確率を高め、「悪い」と判断した回答の生成確率を低くするように、教師あり学習を用いて直接モデルを更新します。このアプローチにより、学習プロセスが安定しやすく、計算コストも削減できるため、近年多くのモデルで採用が進んでいます。

憲法AI(Constitutional AI)と自己整合

憲法AI(Constitutional AI)は、AI開発企業Anthropic社によって提唱されたユニークなアライメント手法です。このアプローチの最大の特徴は、人間のフィードバックへの依存を減らし、AIが事前に定義された原則(憲法)に基づいて自己改善を行う点にあります。(出典:Constitutional AI: Harmlessness from AI Feedback)

プロセスは2段階に分かれます。まず、AIに有害な質問への応答を生成させ、その応答を憲法(例:「人間に危害を加える方法を説明してはならない」といった原則リスト)に照らし合わせて自己批判させ、より安全な応答に修正させます。次に、この修正プロセスで得られた「安全な応答」のデータセットを使い、AI自身が良い応答と悪い応答を判断するモデルを学習させます。これにより、人間が常に監視しなくても、AIが自律的にアライメントを維持できるようになることを目指しています。

LLMアライメントの評価基準と原則

LLMが人間の価値観とどれだけ一致しているかを客観的に測るためには、明確な評価基準が必要です。そのために、様々な「ベンチマーク」が開発されています。これらのベンチマークは、モデルの能力を多角的にテストし、その安全性や信頼性を数値化する役割を果たします。企業がLLMを導入する際には、これらの評価結果を参考にすることが重要です。

性能評価に使われるベンチマークの紹介

LLMの性能評価には、多様なタスクを網羅したベンチマークが用いられます。これらは、モデルの知識、推論能力、真実性、安全性などを測定するために設計されており、それぞれの開発元や論文で詳細が公開されています。代表的なものには以下のようなものがあります。

- MMLU: 物理学や歴史、法律など57の多様な主題に関する知識を問うベンチマーク。

- TruthfulQA: よくある誤解や虚偽情報に対して、モデルがどれだけ真実に基づいた回答ができるかを評価します。

- HaluEval: モデルが生成した応答にハルシネーション(事実に基づかない情報)が含まれていないかを検出する能力を測ります。

- MT-Bench: 対話能力や指示追従能力など、より実用的な側面を評価するためのベンチマークです。

これらのベンチマークスコアは、各LLMの特性を比較検討する上での客観的な指標の一つとなります。

倫理的・社会的な価値観の反映方法

ベンチマークによる性能評価に加え、LLMが倫理的・社会的な価値観を適切に反映できているかを評価することも極めて重要です。これには、特定の文化や思想に偏らない、多様な背景を持つ人々による評価が不可欠です。例えば、ジェンダーや人種に関するバイアスを測定する専門のデータセット(例: WinoGender, CrowS-Pairs)を用いて、モデルの公平性を検証する試みがなされています。

また、企業が独自のガイドラインを策定し、それに沿った応答ができるかをテストすることも有効です。AIの応答が自社の企業倫理やブランドイメージに合致しているかを確認するプロセスは、ビジネス利用におけるリスク管理の根幹をなします。

LLMアライメントを実践する上での注意点とリスク

ベンチマークによる客観的な評価は重要ですが、LLMアライメントを実践する上では、いくつかの注意点とリスクが伴います。アライメントは単一の正しい答えがあるわけではなく、常にトレードオフを考慮する必要がある複雑なプロセスです。

- 価値観の偏り(バイアス): アライメントは、特定の価値観や文化をモデルに反映させるプロセスです。しかし、「誰の」価値観に合わせるかという問題は避けられません。開発者の意図しない形で、特定の文化圏や社会層のバイアスが埋め込まれ、公平性を欠いた応答を生成するリスクがあります。

- 性能とのトレードオフ(アライメント税): 安全性や無害性を過度に追求すると、LLMの持つ創造性や多様な応答能力が抑制されてしまうことがあります。この現象は「アライメント税(Alignment Tax)」と呼ばれ、モデルの有用性が低下する一因となります。

- 悪用のリスク(ジェイルブレイク): アライメントによって施された安全機能は、巧妙に作られた指示(プロンプト)によって意図的に回避される可能性があります。 この「ジェイルブレイク(脱獄)」と呼ばれる手法により、モデルが有害または不適切なコンテンツを生成してしまうリスクは常に存在します。

これらのリスクを理解し、どのような価値観をどの程度反映させるのか、性能と安全性のバランスをどう取るのかを慎重に検討することが、責任あるLLMの運用には不可欠です。

LLMアライメントが直面する課題と今後の展望

LLMアライメント技術は急速に進歩していますが、依然として多くの課題を抱えています。これらの課題を理解することは、AIの限界を認識し、将来の技術動向を予測する上で重要です。価値観の多様性という根本的な問題から、技術的なトレードオフ、そして未来の研究の方向性まで、今後の展望を探ります。

価値観の多様性と定義の難しさ(アライメント税)

アライメントにおける最も根源的な課題は、「誰の価値観に合わせるべきか」という問いです。文化、宗教、個人の信条によって「正しい」とされる価値観は大きく異なります。グローバルに展開されるLLMにとって、全てのユーザーにとって公平で中立的なアライメントを実現することは極めて困難です。

また、「アライメント税(Alignment Tax)」と呼ばれる問題も存在します。これは、安全性を高めるためにアライメントを強化すると、モデルの性能や創造性が一部犠牲になるというトレードオフの関係を指します。例えば、過度に無害さを追求した結果、当たり障りのない役に立たない回答しか生成できなくなるケースです。この最適なバランスを見つけることが、今後の大きな課題となっています。

https://media.a-x.inc/llm-bias2025年以降の研究動向と技術予測

2025年以降、LLMアライメントの研究はさらに加速すると予測されます。一つの方向性として、より効率的でスケーラブルなアライメント手法の開発が挙げられます。DPOのような手法のさらなる発展や、AIがAIを監督・評価することで人間の負担を軽減する「スケーラブルな監視」技術の研究が進むでしょう。

もう一つの重要なトレンドは、「解釈可能性(Interpretability)」の向上です。これは、AIがなぜそのような判断や応答をしたのか、その内部の意思決定プロセスを人間が理解できるようにする技術です。モデルの透明性が高まることで、問題が発生した際の原因究明が容易になり、より高度なアライライメント制御が可能になると期待されています。

LLMのビジネス活用やアライメント技術を学ぶならAX CAMP

LLMアライメントの仕組みを理解することは、AIをビジネスで安全かつ効果的に活用するための第一歩です。しかし、理論の理解だけでなく、自社の課題に合わせてAIを適切にカスタマイズし、運用していく実践的なスキルがなければ、真の成果には繋がりません。特に、アライメントに関連するリスク管理やガイドライン策定は、専門的な知識が求められる領域です。

もし貴社が「AI導入を進めたいが、何から手をつければ良いか分からない」「AIの潜在的なリスクをどう管理すればよいか不安だ」といった課題を抱えているなら、実践型の法人向けAI研修「AX CAMP」が解決の糸口となるかもしれません。AX CAMPでは、LLMの基礎技術から、ビジネス現場での具体的な活用方法、そして安全な運用体制の構築までを体系的に学ぶことができます。

単なる座学に留まらず、貴社の実務課題をテーマにしたワークショップを通じて、明日から使えるスキルを習得できるのが特長です。実際に、多くの導入企業様で具体的な成果が報告されています。

- グラシズ様(リスティング広告運用):LPライティングの外注費月10万円を0円にし、制作時間も3営業日から2時間へと大幅に短縮しました。(出典:【AX CAMP導入事例】LP制作時間3営業日→2時間、月10万円の外注費を内製化しコスト削減を実現!)

- Route66様(マーケティング支援):これまで24時間かかっていた原稿執筆がわずか10秒で完了するなど、圧倒的な生産性向上を達成しました。(出典:【AX CAMP導入事例】原稿執筆24時間→10秒?! 業務効率化で月50時間以上の工数削減!)

- C社様(メディア運営):SNS運用業務の時間を1日3時間から1時間へ66%削減し、月間1,000万インプレッションを達成しました。

より詳しいカリキュラムや、貴社の状況に合わせたカスタマイズプランについては、無料のオンライン相談でご案内しています。まずはお気軽に資料請求いただき、AI活用の可能性をご確認ください。※上記の成果は一例であり、効果を保証するものではありません。

LLM アライメントに関するよくある質問(FAQ)

1. LLMアライメントとは、具体的に何を目指す技術ですか?

LLMアライメントとは、AIの応答を人間の意-とや社会的な価値観に沿わせる技術のことです。 具体的には、モデルが「有用(Helpful)」「正直(Honest)」「無害(Harmless)」という3つの原則(HHH)に従うよう調整します。 これにより、不正確な情報や、人種差別的な発言といった危険なコンテンツの生成を防ぎ、AIを安全で信頼できるものにすることを目的とします。

2. LLMアライメントをビジネスに導入すると、どのようなメリットがありますか?

LLMアライメントの導入は、主に3つのビジネスメリットをもたらします。第一に、不適切・無関係な回答が減少し、ユーザーの意図を正確に汲み取ることで顧客満足度が向上します。第二に、差別的・攻撃的な発言によるブランドイメージの毀損や「炎上」といったリスクを低減できます。 第三に、これらの改善を通じて、ユーザーからの信頼を獲得し、サービスの継続的な利用やコンバージョン率の向上に繋がります。

3. LLMアライメントを導入・運用する際の注意点は何ですか?

LLMアライメント導入時の注意点は3つです。①価値観の偏り:フィードバック提供者の価値観にモデルが過剰適合し、多様な意見を反映できなくなるリスクがあります。 ②データ品質の担保:質の低いフィードバックデータは、かえってAIの性能を悪化させる可能性があります。③継続的な監視と更新:社会の価値観は変化するため、一度調整して終わりではなく、定期的なモデルの再評価と調整が不可欠です。

4. LLMアライメントの代表的な手法「RLHF」はどのような仕組みですか?

RLHF(人間のフィードバックによる強化学習)は、主に3つのステップでLLMを調整します。 ①まず、ある指示に対し複数の回答を生成させ、人間がそれらをランク付けします。②次に、そのランク付けデータを基に「人間の好み」を学習した報酬モデルを構築します。③最後に、その報酬モデルがより高い点数をつけるような回答を生成できるよう、LLM自体を強化学習で最適化します。

まとめ:LLMアライメントを理解して安全なAI活用へ

本記事では、LLMを人間の意図や価値観に沿わせるための核心技術「LLMアライメント」について、その目的から主要な手法、課題、そして未来の展望までを解説しました。安全なAI活用を実現するためには、これらの知識が不可欠です。

- アライメントの重要性: AIの潜在的リスク(ハルシネーション、バイアス等)を抑制し、信頼性を確保する。

- HHHの三原則: AIの応答は「有益(Helpful)」「正直(Honest)」「無害(Harmless)」であるべきという指針。

- 主要な技術手法: RLHF、DPO、憲法AIなど、多様なアプローチでAIの調整が行われている。

- 評価と課題: ベンチマークによる客観評価と、価値観の多様性やアライメント税といった課題が存在する。

LLMアライメントは、AI技術が社会に受け入れられ、その恩恵を最大限に引き出すための鍵となります。しかし、これらの専門的な技術を自社だけで実装し、適切に運用管理していくことには高いハードルが伴います。専門家の支援を受けながら、自社に合ったAI活用戦略を策定することが成功への近道です。

AX CAMPでは、AIの専門家が貴社の状況をヒアリングし、最適なAI導入・活用プランをご提案します。研修を通じて社内にAI人材を育成することで、外部に依存しない持続可能なDX推進体制を構築できます。導入事例でご紹介したように、SNS運用工数を66%削減したり、LPライティングの制作時間を3営業日から2時間へ短縮したりといった成果も、専門的な支援があってこそ実現可能です。まずは第一歩として、無料の資料請求から始めてみてはいかがでしょうか。※記載の成果は導入事例の一部であり、効果を保証するものではありません。成果には企業の状況や取り組みによって差が生じます。